大数据处理及工具开发

1、大数据处理及工具开发

(1)大数据环境下的数据处理需求

大数据环境下数据来源非常丰富且数据类型多样,存储和分析挖掘的数据量庞大,对数据展现的要求较高,并且很看重数据处理的高效性和可用性。(2)大数据的意义

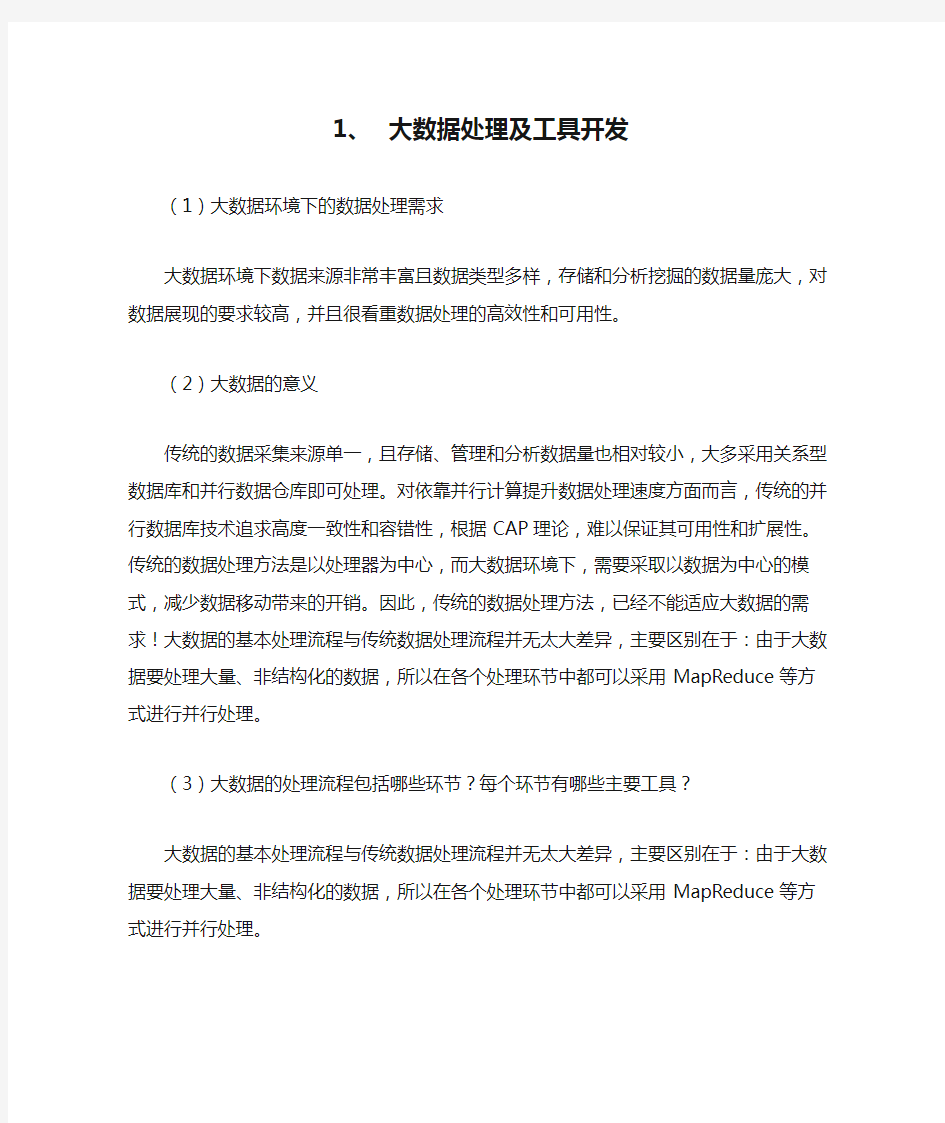

传统的数据采集来源单一,且存储、管理和分析数据量也相对较小,大多采用关系型数据库和并行数据仓库即可处理。对依靠并行计算提升数据处理速度方面而言,传统的并行数据库技术追求高度一致性和容错性,根据CAP理论,难以保证其可用性和扩展性。传统的数据处理方法是以处理器为中心,而大数据环境下,需要采取以数据为中心的模式,减少数据移动带来的开销。因此,传统的数据处理方法,已经不能适应大数据的需求!大数据的基本处理流程与传统数据处理流程并无太大差异,主要区别在于:由于大数据要处理大量、非结构化的数据,所以在各个处理环节中都可以采用MapReduce等方式进行并行处理。(3)大数据的处理流程包括哪些环节?每个环节有哪些主要工具?

大数据的基本处理流程与传统数据处理流程并无太大差异,主要区别在于:由于大数据要处理大量、非结构化的数据,所以在各个处理环节中都可以采用MapReduce等方式进行并行处理。

(4)大数据技术为什么能提高数据的处理速度?

数据的并行处理利器——MapReduce

大数据可以通过MapReduce这一并行处理技术来提高数据的处理速度。MapReduce的设计初衷是通过大量廉价服务器实现大数据并行处理,对数据一致性要求不高,其突出优势是具有扩展性和可用性,特别适用于海量的结构化、半结构化及非结构化数据的混合处理。

MapReduce将传统的查询、分解及数据分析进行分布式处理,将处理任务分配到不同的处理节点,因此具有更强的并行处理能力。作为一个简化的并行处理的编程模型,MapReduce 还降低了开发并行应用的门槛。

MapReduce是一套软件框架,包括Map(映射)和Reduce(化简)两个阶段,可以进行海量数据分割、任务分解与结果汇总,从而完成海量数据的并行处理。MapReduce的工作原理其实是先分后合的数据处理方式。Map即“分解”,把海量数据分割成了若干部分,分给多台处理器并行处理;Reduce即“合并”,把各台处理器处理后的结果进行汇总操作以得到最终结果。如右图所示,如果采用MapReduce来统计不同几何形状的数量,它会先把任务分配到两个节点,由两个节点分别并行统计,然后再把它们的结果汇总,得到最终的计算结果。MapReduce适合进行数据分析、日志分析、商业智能分析、客户营销、大规模索引等业务,并具有非常明显的效果。通过结合MapReduce技术进行实时分析,某家电公司的信用计算时间从33小时缩短到8秒,而MKI的基因分析时间从数天缩短到20分钟。

(5)大数据技术在数据采集方面采用了哪些新的方法

系统日志采集方法

很多互联网企业都有自己的海量数据采集工具,多用于系统日志采集,如Hadoop的Chukwa,Cloudera的Flume,Facebook的Scribe等,这些工具均采用分布式架构,能满足每秒数百MB的日志数据采集和传输需求。

1)Chukwa

·代理:负责采集最原始的数据并发送给收集器。

·适配器:直接采用数据的接口和工具。

·收集器:负责收集代理收送来的数据,并定时写入急群众。·MapReduce分析

·多路分配器:负责对数据的分类排序和去重。

2)Flume

3)Scribe

Scribe是Facebook开源的日志收集系统,在Facebook内部已经得到大量的应用。它能够从各种日志源上收集日志,存储到一个中央存储系统(可以是NFS,分布式文件系统等)上,以便于进行集中统计分析处理,它为日志的“分布式收集,统一处理”提供一个可扩展的,高容错的方案。

Scribe架构

Scribe agent

Scribe agent实际上是一个thrift client。向scribe发送数据的唯一方法是使用thrift client,scribe内部定义了一个thrift接口,用户使用该接口将数据发送给server。

Scribe

Scribe接收到thrift client发送过来的数据,根据配置文件,将不同主题的数据发送给不同的对象。

存储系统

存储系统实际上就是scribe中的store。

网络数据采集方法:对非结构化数据的采集

网络数据采集是指通过网络爬虫或网站公开API等方式从网站上获取数据信息。该方法可以将非结构化数据从网页中抽取出来,将其存储为统一的本地数据文件,并以结构化的方式存储。它支持图片、音频、视频等文件或附件的采集,附件与正文可以自动关联。除了网络中包含的内容之外,对于网络流量的采集可以使用DPI或DFI等带宽管理技术进行处理。

其他数据采集方法

对于企业生产经营数据或学科研究数据等保密性要求较高的数据,可以通过与企业或研究机构合作,使用特定系统接口等相关方式采集数据。

大数据分析工具:

Hadoop

Hadoop 是一个能够对大量数据进行分布式处理的软件框架。但是 Hadoop 是以一种可靠、高效、可伸缩的方式进行处理的。Hadoop 是可靠的,因为它假设计算元素和存储会失败,因此它维护多个工作数据副本,确保能够针对失败的节点重新分布处理。Hadoop 是高效的,因为它以并行的方式工作,通过并行处理加快处理速度。Hadoop 还是可伸缩的,能够处理 PB 级数据。此外,Hadoop 依赖于社区服务器,因此它的成本比较低,任何人都可以使用。

Hadoop是一个能够让用户轻松架构和使用的分布式计算平台。用户可以轻松地在Hadoop上开发和运行处理海量数据的应用程序。它主要有以下几个优点:

1. 高可靠性。Hadoop按位存储和处理数据的能力值得人们信赖。

2. 高扩展性。Hadoop是在可用的计算机集簇间分配数据并完成计算任务的,这些集簇可以方便地扩展到数以千计的节点中。

3. 高效性。Hadoop能够在节点之间动态地移动数据,并保证各个节点的动态平衡,因此处理速度非常快。

4. 高容错性。Hadoop能够自动保存数据的多个副本,并且能够自动将失败的任务重新分配。

Hadoop带有用 Java 语言编写的框架,因此运行在 Linux 生产平台上是非常理想的。Hadoop 上的应用程序也可以使用其他语言编写,比如 C++。

大数据分析的六大工具介绍

大数据分析的六大工具介绍 2016年12月 一、概述 来自传感器、购买交易记录、网络日志等的大量数据,通常是万亿或EB的大小,如此庞大的数据,寻找一个合适处理工具非常必要,今天我们为大家分学在大数据处理分析过程中六大最好用的工具。 我们的数据来自各个方面,在面对庞大而复杂的大数据,选择一个合适的处理工具显得很有必要,工欲善其事,必须利其器,一个好的工具不仅可以使我们的工作事半功倍,也可以让我们在竞争日益激烈的云计算时代,挖掘大数据价值,及时调整战略方向。 大数据是一个含义广泛的术语,是指数据集,如此庞大而复杂的,他们需要专门设il?的硬件和软件工具进行处理。该数据集通常是万亿或EB的大小。这些数据集收集自各种各样的来源:传感器、气候信息、公开的信息、如杂志、报纸、文章。大数据产生的其他例子包括购买交易记录、网络日志、病历、事监控、视频和图像档案、及大型电子商务。大数据分析是在研究大量的数据的过程中寻找模式, 相关性和其他有用的信息,可以帮助企业更好地适应变化,并做出更明智的决策。 二.第一种工具:Hadoop Hadoop是一个能够对大量数据进行分布式处理的软件框架。但是Hadoop是 以一种可黑、高效、可伸缩的方式进行处理的。Hadoop是可靠的,因为它假设计算元素和存储会失败,因此它维护多个工作数据副本,确保能够针对失败的节点重新分布处理。Hadoop 是高效的,因为它以并行的方式工作,通过并行处理加快处理速度。Hadoop还是可伸缩的,能够处理PB级数据。此外,Hadoop依赖于社区服务器,因此它的成本比较低,任何人都可以使用。

Hadoop是一个能够让用户轻松架构和使用的分布式计算平台。用户可以轻松地 在Hadoop上开发和运行处理海量数据的应用程序。它主要有以下儿个优点: ,高可黑性。Hadoop按位存储和处理数据的能力值得人们信赖。,高扩展性。Hadoop是 在可用的计?算机集簇间分配数据并完成讣算任务 的,这些集簇可以方便地扩展到数以千计的节点中。 ,高效性。Hadoop能够在节点之间动态地移动数据,并保证各个节点的动 态平衡,因此处理速度非常快。 ,高容错性。Hadoop能够自动保存数据的多个副本,并且能够自动将失败 的任务重新分配。 ,Hadoop带有用Java语言编写的框架,因此运行在Linux生产平台上是非 常理想的。Hadoop上的应用程序也可以使用其他语言编写,比如C++。 第二种工具:HPCC HPCC, High Performance Computing and Communications(高性能计?算与通信)的缩写° 1993年,山美国科学、工程、技术联邦协调理事会向国会提交了“重大挑战项 U:高性能计算与通信”的报告,也就是被称为HPCC计划的报告,即美国总统科学战略项U ,其U的是通过加强研究与开发解决一批重要的科学与技术挑战 问题。HPCC是美国实施信息高速公路而上实施的计?划,该计划的实施将耗资百亿 美元,其主要U标要达到:开发可扩展的计算系统及相关软件,以支持太位级网络 传输性能,开发千兆比特网络技术,扩展研究和教育机构及网络连接能力。

数据库开发管理工具

图书仓库治理系统 本系统要紧完成对图书仓库的库存治理,包括图书入库、出库、库存,职员信息,供应商信息以及密码治理等六个方面。系统能够完成对各类信息的扫瞄、查询、添加、删除、修改、报表等功能。 系统的核心是入库、库存和出库三者之间的联系,每一个表的修改都将联动的阻碍其它的表,当完成入库或出库操作时系统会自动地完成库存的修改。查询功能也是系统的核心之一,在系统中即有单条件查询和多条件查询,也有精确查询和模糊查询,系统不仅有静态的条件查询,也有动态生成的条件查询,其目的差不多上为了方便用户使用。系统有完整的用户添加、删除和密码修改功能,并具备报表打印功能。 系统采纳Microsoft Office中的Access 2000来设计数据库,并使用当前优秀的开发工具—Delphi 6.0 ,它有着最为灵活的数据库结构,对数据库应用有着良好的支持。 论文要紧介绍了本课题的开发背景,所要完成的功能和开发的过

程。重点的讲明了系统设计的重点、设计思想、难点技术和解决方案。 关键字:数据库,SQL语言,Delph 6,数据库组件,仓库治理 目录 第一章引言 (1) 1.1 课题来源 (1) 1.2 开发工具的选择 (2) 1.3 所做的要紧工作 (3) 第二章数据库概论……………………………………………………………………

2.1 数据库的进展 (4) 2.1.1 数据库的进展 (4) 2.1.2 数据库时期的特点 (5) 2.1.3 数据库技术 (6) 2.2 数据库理论基础 (7) 2.2.1 数据库模型 (7) 2.2.2 数据库体系结构 (10) 2.2.3 数据的独立性 (11) 2.2.4 范式…………………………………………………………………

大数据分析及其在医疗领域中的应用-图文(精)

第7期 24 2014年4月10日 计算机教育 ComputerEducation ◆新视点 文章编号:1672.5913(2014)07—0024-06 中图分类号:G642 大数据分析及其在医疗领域中的应用 邹北骥 (中南大学信息科学与工程学院,湖南长沙410083) 摘要:互联网和物联网技术的快速发展给数据的上传与下载带来了前所未有的便利,使得互联网上 的数据量急剧增长,由此产生了针对大数据的存储、计算、分析、处理等新问题,尤其是对大数据的挖掘。文章分析当前大数据产生的背景,阐述大数据的基本特征及其应用,结合医疗领域,论述医疗 大数据分析的目的、意义和主要方法。 关键词:大数据;物联网;医疗;大数据挖掘 1 大数据早已存在,为何现在称之为大

数据时代 计算与数据是一对孪生姐妹,计算需要数据,数据通过计算产生新的价值。数据是客观事 物的定量表达,来自于客观世界并早已存在。例 如,半个世纪前,全球的人口数量就有数十亿,与之相关的数据就是大数据;但是在那个时代,由于技术的局限性,大数据的采集、存储和处理 还难以实现。 互联网时代之前,采集世界各地的数据并让它们快速地进入计算系统几乎是一件不可想象的 事情。20世纪80年代兴起的互联网技术在近30 年里发生了翻天覆地的变化,彻底地改变了人们的工作和生活方式【l】。通过互联网人们不仅可以下载到新闻、小说、论文等各类文字数据,而且可以轻而易举地下载到音乐、图像和视频等多媒体数据,这使得互联网上的数据流量急剧增长。据统计,现在互联网上每分钟流人流出的数 据量达到1 000 PB,即10亿 GBt21。 推动大数据产生的另一个重要因素是物联网技术。近几年发展起来的物联网技 术通过给每个物品贴上标签 并应用RFID等技术实现了

数据库开发工具的深刻比较

数据库开发工具的比较 VB:全称Visual Basic,它是以Basic语言作为其基本语言的一种可视化编程工具。是新人开发与系统无关的综合应用程序的首选;容易使用和厂商财力很强是其仅有的两点优势。VB开发效率高,代码执行效率一般,但是入门和学习速度快,有较好的学习氛围和帮助书籍和帮助文档。但是随着微软的.net技术的推广,VB将会逐渐推出历史舞台。 它对组件技术的支持是基于COM和ActiveX,对于组件技术不断完善发展的今天,它也显出了它的落后性;同时VB在进行系统底层开发的时候也是相对复杂的,调用API函数需声明,调用不方便,不能进行DDK编程,不可能深入Ring0编程,不能嵌套汇编;而且面向对象的特性差;网络功能和数据库功能也没有非常特出的表现。 PB:全称PowerBuilder,是开发MIS系统和各类数据库跨平台的首选,使用简单,容易学习,容易掌握,在代码执行效率上也有相当出色的表现。是开发大型MIS及各类数据库跨平台应用的首选;从数据库前端工具来讲甚至远远超过了Oracle的Develop系列等专门的工具;从通用语言角度来讲功能也与VB等不相上下;多媒体和网络功能与其他工具相比较弱。 PB是一种真正的4GL语言(第四代语言),可随意直接嵌套SQL语句返回值被赋值到语句的变量中,支持语句级游标,存储过程和数据库函数,是一种类似SQLJ的规范,数据访问中具有无可比拟的灵活

性。但是它在系统底层开发中犯了跟VB一样的错误,调用API函数需声明,调用不方便,不能进行DDK编程,不可能深入Ring0编程,不能嵌套汇编;在网络开发中提供了较多动态生成Web页面的用户对象和服务以及系统对象,非常适合编写服务端动态Web应用,有利于商业逻辑的封装;但是用于网络通讯的支持不足;静态页面定制支持有限,使得PB在网络方面的应用也不能非常广泛。面向对象特向也不是太好。 C Builder/Dephi:它们都是基于VCL库的可视化开发工具,是唯一一套能够同时适用于开发数据库应用、网络及Web应用、分布式应用、可重用组件、系统软件、驱动程序、多媒体及游戏等所有软件的高效率开发环境,并且学习使用较为容易,充分提现了所见即所得的可视化开发方法,开发效率高。由于两者都是Borland公司的产品,自然继承了该公司一贯以来的优良传统:代码执行效率高。但是,它们并不是毫无缺点,它们所作的最大不足之处就是他们的帮助系统在众多的编程工具中是属于比较差的。C++Builder的VCL库是基于Object pascal(面向对象pascal),使得C++Builder在程序的调试执行上都面向落后于其他编程工具。而Delphi则是它的语言不够广泛、开发系统软件功能不足两个比较大的缺点。 VC:全称Visual C++是基于MFC库的可视化的开发工具,从总体上说它是一个功能强大但是不便使用的一种工具。从功能上讲除了跨平台应用外什么都可开发;从开发效率角度讲只局限于开发windows 系统应用、可重用组件及驱动程序。

大数据处理技术的总结与分析

数据分析处理需求分类 1 事务型处理 在我们实际生活中,事务型数据处理需求非常常见,例如:淘宝网站交易系统、12306网站火车票交易系统、超市POS系统等都属于事务型数据处理系统。这类系统数据处理特点包括以下几点: 一就是事务处理型操作都就是细粒度操作,每次事务处理涉及数据量都很小。 二就是计算相对简单,一般只有少数几步操作组成,比如修改某行得某列; 三就是事务型处理操作涉及数据得增、删、改、查,对事务完整性与数据一致性要求非常高。 四就是事务性操作都就是实时交互式操作,至少能在几秒内执行完成; 五就是基于以上特点,索引就是支撑事务型处理一个非常重要得技术. 在数据量与并发交易量不大情况下,一般依托单机版关系型数据库,例如ORACLE、MYSQL、SQLSERVER,再加数据复制(DataGurad、RMAN、MySQL数据复制等)等高可用措施即可满足业务需求。 在数据量与并发交易量增加情况下,一般可以采用ORALCERAC集群方式或者就是通过硬件升级(采用小型机、大型机等,如银行系统、运营商计费系统、证卷系统)来支撑. 事务型操作在淘宝、12306等互联网企业中,由于数据量大、访问并发量高,必然采用分布式技术来应对,这样就带来了分布式事务处理问题,而分布式事务处理很难做到高效,因此一般采用根据业务应用特点来开发专用得系统来解决本问题。

2数据统计分析 数据统计主要就是被各类企业通过分析自己得销售记录等企业日常得运营数据,以辅助企业管理层来进行运营决策。典型得使用场景有:周报表、月报表等固定时间提供给领导得各类统计报表;市场营销部门,通过各种维度组合进行统计分析,以制定相应得营销策略等. 数据统计分析特点包括以下几点: 一就是数据统计一般涉及大量数据得聚合运算,每次统计涉及数据量会比较大。二就是数据统计分析计算相对复杂,例如会涉及大量goupby、子查询、嵌套查询、窗口函数、聚合函数、排序等;有些复杂统计可能需要编写SQL脚本才能实现. 三就是数据统计分析实时性相对没有事务型操作要求高。但除固定报表外,目前越来越多得用户希望能做做到交互式实时统计; 传统得数据统计分析主要采用基于MPP并行数据库得数据仓库技术.主要采用维度模型,通过预计算等方法,把数据整理成适合统计分析得结构来实现高性能得数据统计分析,以支持可以通过下钻与上卷操作,实现各种维度组合以及各种粒度得统计分析。 另外目前在数据统计分析领域,为了满足交互式统计分析需求,基于内存计算得数据库仓库系统也成为一个发展趋势,例如SAP得HANA平台。 3 数据挖掘 数据挖掘主要就是根据商业目标,采用数据挖掘算法自动从海量数据中发现隐含在海量数据中得规律与知识。

大数据处理分析的六大最好工具

大数据处理分析的六大最好工具 来自传感器、购买交易记录、网络日志等的大量数据,通常是万亿或EB的大小,如此庞大的数据,寻找一个合适处理工具非常必要,今天我们为大家分享在大数据处理分析过程中六大最好用的工具。 【编者按】我们的数据来自各个方面,在面对庞大而复杂的大数据,选择一个合适的处理工具显得很有必要,工欲善其事,必须利其器,一个好的工具不仅可以使我们的工作事半功倍,也可以让我们在竞争日益激烈的云计算时代,挖掘大数据价值,及时调整战略方向。本文转载自中国大数据网。 CSDN推荐:欢迎免费订阅《Hadoop与大数据周刊》获取更多Hadoop技术文献、大数据技术分析、企业实战经验,生态圈发展趋势。 以下为原文: 大数据是一个含义广泛的术语,是指数据集,如此庞大而复杂的,他们需要专门设计的硬件和软件工具进行处理。该数据集通常是万亿或EB的大小。这些数据集收集自各种各样的来源:传感器、气候信息、公开的信息、如杂志、报纸、文章。大数据产生的其他例子包括购买交易记录、网络日志、病历、事监控、视频和图像档案、及大型电子商务。大数据分析是在研究大量的数据的过程中寻找模式,相关性和其他有用的信息,可以帮助企业更好地适应变化,并做出更明智的决策。 Hadoop Hadoop 是一个能够对大量数据进行分布式处理的软件框架。但是Hadoop 是以一种可靠、高效、可伸缩的方式进行处理的。Hadoop 是可靠的,因为它假设计算元素和存储会失败,因此它维护多个工作数据副本,确保能够针对失败的节点重新分布处理。Hadoop 是高效的,因为它以并行的方式工作,通过并行处理加快处理速度。Hadoop 还是可伸缩的,能够处理PB 级数据。此外,Hadoop 依赖于社区服务器,因此它的成本比较低,任何人都可以使用。

常见主流数据库分类

常见主流数据库分类 1、IBM 的DB2 DB2是IBM著名的关系型数据库产品,DB2系统在企业级的应用中十分广泛。截止2003年,全球财富500强(Fortune 500)中有415家使用DB2,全球财富100强(Fortune100)中有96家使用DB2,用户遍布各个行业。2004年IBM的DB2就获得相关专利239项,而Oracle 仅为99项。DB2目前支持从PC到UNIX,从中小型机到大型机,从IBM到非IBM(HP及SUN UNIX 系统等)的各种操作平台。 IBM绝对是数据库行业的巨人。1968年IBM在IBM 360计算机上研制成功了IMS这个业界第一个层次型数据库管理系统,也是层次型数据库中最为著名和最为典型的。1970年,IBM E.F.Codd发表了业界第一篇关于关系数据库理论的论文“A Relational Model of Data for Large Shared DataBanks”,首次提出了关系模型的概念。1974年,IBM Don Chamberlin和Ray Boyce通过System R项目的实践,发表了论文“SEQUEL:A Structured English Query Language”,我们现在熟知SQL就是基于它发展起来的。IBM 在1983年发布了DATABASE 2(DB2)for MVS(内部代号为“Eagle”),这就是著名的DB2数据库。2001年IBM以10亿美金收购了Informix的数据库业务,这次收购扩大了IBM分布式数据库业务。2006 DB2 9作为第三代数据库的革命性产品正式在全球发布。 作为关系数据库领域的开拓者和领航人,IBM在1977年完成了System R系统的原型,1980年开始提供集成的数据库服务器——System/38,随后是SQL/DSforVSE 和VM,其初始版本与SystemR研究原型密切相关。 DB2 forMVSV1 在1983年推出。该版本的目标是提供这一新方案所承诺的简单性,数据不相关性和用户生产率。1988年DB2 for MVS 提供了强大的在线事务处理(OLTP)支持,1989 年和1993 年分别以远程工作单元和分布式工作单元实现了分布式数据库支持。最近推出的DB2 Universal Database 6.1则是通用数据库的典范,是第一个具备网上功能的多媒体关系数据库管理系统,支持包括Linux在内的一系列平台。 2、Oracle Oracle 前身叫SDL,由Larry Ellison 和另两个编程人员在1977创办,他们开发了自己的拳头产品,在市场上大量销售,1979 年,Oracle公司引入了第一个商用SQL 关系数据库管理系统。Oracle公司是最早开发关系数据库的厂商之一,其产品支持最广泛的操作系统平台。目前Oracle关系数据库产品的市场占有率名列前茅。 Oracle公司是目前全球最大的数据库软件公司,也是近年业务增长极为迅速的软件提供与服务商。IDC(Internet Data Center)2007统计数据显示数据库市场总量份额如下:Oracle 44.1% IBM 21.3%Microsoft 18.3% Teradata 3.4% Sybase 3.4%。不过从使用情况看,BZ Research的2007年度数据库与数据存取的综合研究报告表明76.4%的公司使用了Microsoft SQL Server,不过在高端领域仍然以Oracle,IBM,Teradata为主。 2007年7月12日,甲骨文公司在美国纽约宣布推出数据库Oracle 11g,这是Oracle数

50个大数据可视化分析工具

50个大数据可视化分析工具 在大数据时代,数据可视化工具必须具有以下特性: (1)实时性:数据可视化工具必须适应大数据时代数据量的爆炸式增长需求,必须快速的收集分析数据、并对数据信息进行实时更新; (2)简单操作:数据可视化工具满足快速开发、易于操作的特性,能满足互联网时代信息多变的特点; (3)更丰富的展现:数据可视化工具需具有更丰富的展现方式,能充分满足数据展现的多维度要求; (4)多种数据集成支持方式:数据的来源不仅仅局限于数据库,数据可视化工具将支持团队协作数据、数据仓库、文本等多种方式,并能够通过互联网进行展现。 Excel 是快速分析数据的理想工具,也能创建供内部使用的数据图,但在颜色、线条和样式上可选择的范围有限。 Google Charts 提供了大量现成的图表类型,从简单的线图表到复杂的分层树地图等,还内置了动画和用户交互控制。 D3 能够提供大量线性图和条形图之外的复杂图表样式,例如V oronoi图、树形图、圆形集群和单词云等。 R语言 是主要用于统计分析、绘图的语言和操作环境。 Visual.ly 如果你需要制作信息图而不仅仅是数据可视化,Visual.ly是最流行的一个选择。

Processing 是数据可视化的招牌工具,只需要编写一些简单的代码,然后编译成Java,可在几乎所有平台上运行。 Leaflet 用来开发移动友好地交互地图。 OpenLayers 对于一些特定的任务来说,能够提供一些其他地图库都没有的特殊工具。 Polymaps 是一个地图库,主要面向数据可视化用户。可以将符号字体与字体整合,创建出漂亮的矢量化图标。 Gephi 是一个可视化的网络探索平台,用于构建动态的、分层的数据图表。 可以用CartoDB很轻易就把表格数据和地图关联起来。 Weka是数据分析的强大工具,还能生成一些简单的图表。 NodeBox是OS X上创建二维图形和可视化的应用程序。 Kartograph不需要任何地图提供者像Google Maps,用来建立互动式地图。 Modest Maps在一些扩展库的配合下,例如Wax,Modest Maps立刻会变成一个强大的地图工具。 Tangle是个用来探索、Play和查看文档更新的交互式库。既是图表,又是互动图形用户界面的小程序。当你调整一个图表中的输入范围时,其他关联图表的数据也会随之改变。 Rapha憀与其他库最大的不同是输出格式仅限SVG和VML。 jsDraw2DX用来创建任意类型的SVG交互式图形,可生成包括线、举行、多边形、椭圆、弧线等等图形。 Pizza Pie Charts是个响应式饼图图表。 FusionCharts XT是一款跨平台、跨浏览器的JavaScript图表组件,可提供令人愉悦的JavaScript图表体验。 iCharts有交互元素,可以从Google Doc、Excel 表单和其他来源中获取数据。

28款经典数据库管理工具

28款经典数据库管理工具 1、MySQL Workbench MySQL Workbench是一款专为MySQL设计的ER/数据库建模工具。它是著名的数据库设计工具DBDesigner4的继任者。你可以用MySQL Workbench设计和创建新的数据库图示,建立数据库文档,以及进行复杂的MySQL 迁移 MySQL Workbench是下一代的可视化数据库设计、管理的工具,它同时有开源和商业化的两个版本。该软件支持Windows 和Linux系统,下面是一些该软件运行的界面截图:2、数据库管理工具Navicat Lite NavicatTM是一套快速、可靠并价格相宜的资料库管理工具,大可使用来简化资料库的管理及降低系统管理成本。它的设计符合资料库管理员、开发人员及中小企业的需求。Navicat是以直觉化的使用者图形介面所而建的,让你可以以安全且简单的方式建立、组织、存取并共用资讯。 界面如下图所示:Navicat 提供商业版Navicat Premium 和免费的版本Navicat Lite 。免费版本的功能已经足够强大了。 Navicat 支持的数据库包括MySQL、Oracle、SQLite、PostgreSQL 和SQL Server 等。

3、开源ETL工具Kettle Kettle是一款国外开源的etl工具,纯java编写,绿色无需安装,数据抽取高效稳定(数据迁移工具)。Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。· 授权协议:LGPL · 开发语言:Java · 操作系统:跨平台 4、Eclipse SQL Explorer SQLExplorer是Eclipse集成开发环境的一种插件,它可以被用来从Eclipse连接到一个数据库。 SQLExplorer插件提供了一个使用SQL语句访问数据库的图形用户接口(GUI)。通过使用SQLExplorer,你能够显示表格、表格结构和表格中的数据,以及提取、添加、更新或删除表格数据。 SQLExplorer同样能够生成SQL脚本来创建和查询表格。所以,与命令行客户端相比,使用SQLExplorer可能是更优越的选择,下图是运行中的界面,很好很强大。l 授权协议:未知 l 开发语言:Java l 操作系统:跨平台

云计算大数据的55个可视化分析工具介绍

云计算大数据的55个最实用 可视化分析工具 近年来,随着云和大数据时代的来临,数据可视化产品已经不再满足于使用传统的数据可视化工具来对数据仓库中的数据抽取、归纳并简单的展现。传统的数据可视化工具仅仅将数据加以组合,通过不同的展现方式提供给用户,用于发现数据之间的关联信息。新型的数据可视化产品必须满足互联网爆发的大数据需求,必须快速的收集、筛选、分析、归纳、展现决策者所需要的信息,并根据新增的数据进行实时更新。因此,在大数据时代,数据可视化工具必须具有以下特性: (1)实时性:数据可视化工具必须适应大数据时代数据量的爆炸式增长需求,必须快速的收集分析数据、并对数据信息进行实时更新; (2)简单操作:数据可视化工具满足快速开发、易于操作的特性,能满足互联网时代信息多变的特点; (3)更丰富的展现:数据可视化工具需具有更丰富的展现方式,能充分满足数据展现的多维度要求; (4)多种数据集成支持方式:数据的来源不仅仅局限于数据库,数据可视化工具将支持团队协作数据、数据仓库、文本等多种方式,并能够通过互联网进行展现。

为了进一步让大家了解如何选择适合的数据可视化产品,本文将围绕这一话题展开,希望能对正在选型中的企业有所帮助。下面就来看看全球备受欢迎的的可视化工具都有哪些吧! 1.Excel Excel作为一个入门级工具,是快速分析数据的理想工具,也能创建供内部使用的数据图,但是Excel在颜色、线条和样式上课选择的范围有限,这也意味着用Excel很难制作出能符合专业出版物和网站需要的数据图。 2.Google Chart API Google Chart提供了一种非常完美的方式来可视化数据,提供了大量现成的图标类型,从简单的线图表到复杂的分层树地图等。它还内置了动画和用户交互控制。 3.D3 D3(Data Driven Documents)是支持SVG渲染的另一种JavaScript库。但是D3能够提供大量线性图和条形图之外的复杂图表样式,例如Voronoi图、树形图、圆形集群和单词云等。 4.R

课程名称大数据分析与应用

课程名称:大数据分析与应用 一、课程编码: 课内学时:32学分:2 二、适用学科专业:计算机专业硕士 三、先修课程:无 四、教学目标 通过本课程的课堂学习与应用案例,建立科学的大数据观,掌握大数据架构、大数据精准语义搜索、大数据语义分析挖掘、知识图谱等关键技术,熟练使用常用的大数据搜索挖掘与可视化工具,提升大数据的综合应用能力。 五、教学方式 课堂学习、研讨班与应用实践 六、主要内容及学时分配 1.科学的大数据观2学时 1.1.大数据的定义,科学发展渊源; 1.2.如何科学看待大数据? 1.3.如何把握大数据,分别从“知著”、“显微”、“晓义”三个层面阐述科学的大 数据观。 2.大数据技术平台与架构4学时 2.1云计算技术与开源平台搭建 2.2Hadoop、Spark等数据架构、计算范式与应用实践 3.机器学习与常用数据挖掘4学时 3.1常用机器学习算法:Bayes,SVM,最大熵、深度神经网络等; 3.2常用数据挖掘技术:关联规则挖掘、分类、聚类、奇异点分析。 4.大数据语义精准搜索4学时 4.1.通用搜索引擎与大数据垂直业务的矛盾; 4.2.大数据精准搜索的基本技术:快速增量在线倒排索引、结构化与非机构化数 据融合、大数据排序算法、语义关联、自动缓存与优化机制; 4.3.大数据精准搜索语法:邻近搜索、复合搜索、情感搜索、精准搜索; 4.4.JZSearch大数据精准搜索应用案例:国家电网、中国邮政搜索、国家标准搜 索、维吾尔语搜索、内网文档搜索、舆情搜索; 5.非结构化大数据语义挖掘10学时 5.1.语义理解基础:ICTCLAS与汉语分词 5.2.内容关键语义自动标引与词云自动生成; 5.3.大数据聚类; 5.4.大数据分类与信息过滤; 5.5.大数据去重、自动摘要; 5.6.情感分析与情绪计算;

大数据分析系统项目方案

大数据分析系统 方案

目录 第1章项目概述 (5) 1.1项目背景 (5) 1.2项目必要性 (5) 1.3建设目标 (6) 第2章需求分析 (8) 2.1功能及性能需求 (8) 2.2系统集成需求 (9) 2.3运行环境 (10) 2.4安全需求 (10) 第3章总体设计 (12) 3.1总体设计原则 (12) 3.2总体目标 (13) 3.3系统总体结构 (13) 3.4系统逻辑结构 (15) 第4章详细设计方案 (16) 4.1信息资源规划和数据库设计 (16) 4.1.1数据模型概述 (16) 4.1.2数据建模方法论 (17) 4.1.3数据建模基本原则 (18) 4.1.4数据库架构设计 (19) 4.2数据应用支撑系统设计 (21) 4.2.1大数据平台关键技术 (21) 4.2.2云平台数据共享功能 (26) 4.3数据服务层计 (33) 4.3.1模型的应用 (33) 4.3.2平台基础应用 (33) 4.4数据处理和存储系统设计 (34) 4.4.1大数据处理核心技术 (35) 4.4.2数据存储采用MPP与hadoop融合架构 (35) 4.5网络系统设计 (35) 4.6安全系统设计 (36) 4.6.1系统安全满足情况 (36) 4.6.2系统安全配置管理功能 (37) 4.6.3系统无安全漏洞保障 (40) 4.6.4软件自身安全 (43) 4.6.5性能和可靠性 (44) 4.7运行维护系统设计 (46)

4.7.2网络设备管理 (46) 4.7.3进程管理 (46) 4.7.4服务管理 (46) 4.7.5数据库管理 (46) 4.7.6中间管理 (46) 4.7.7集群管理 (47) 4.7.8故障管理 (47) 4.7.9性能管理 (47) 4.7.10配置文件管理 (47) 4.7.11SYSLOG管理 (47) 4.8其他系统设计 (47) 4.9系统配置及软硬件选型原则 (48) 4.9.1软硬件部署 (48) 4.9.2数据要求 (48) 4.9.3技术要求 (49) 4.10系统软硬件物理部署方案 (49) 第5章项目建设与运行管理 (51) 5.1项目领导机构 (51) 5.2项目管理机构 (51) 5.3项目承建机构 (53) 5.4运行维护机构 (53) 5.5相关管理制度 (54) 5.6项目测试 (55) 5.6.1单元测试 (55) 5.6.2集成测试 (55) 5.6.3系统测试 (56) 5.6.4性能测试 (56) 5.6.5验收测试 (57) 5.6.6安装测试 (57) 5.7安全性测试 (58) 5.7.1功能验证 (58) 5.7.2漏洞扫描 (58) 5.7.3模拟攻击实验 (58) 5.8项目验收 (60) 5.8.1项目验收要求 (60) 5.8.2项目验收的目的和原则 (61) 5.8.3项目验收的组织和实施 (61) 5.8.4项目验收的步骤和程序 (61) 5.8.5项目验收的测试方案 (61) 5.8.6项目验收的文档清单 (61) 第6章项目培训计划 (62) 6.1培训对象和培训目标 (62)

28款经典数据库管理工具

1、MySQL Workbench MySQL Workbench是一款专为MySQL设计的ER/数据库建模工具。它是著名的数据库设计工具DBDesigner4的继任者。你可以用MySQL Workbench 设计和创建新的数据库图示,建立数据库文档,以及进行复杂的MySQL迁移MySQL Workbench是下一代的可视化数据库设计、管理的工具,它同时有开源和商业化的两个版本。该软件支持Windows和Linux系统,下面是一些该软件运行的界面截图:

2、数据库管理工具Navicat Lite Navicat TM是一套快速、可靠并价格相宜的资料库管理工具,大可使用来简化资料库的管理及降低系统管理成本。它的设计符合资料库管理员、开发人员及中小企业的需求。Navicat是以直觉化的使用者图形介面所而建的,让你可以以安全且简单的方式建立、组织、存取并共用资讯。 界面如下图所示:

Navicat提供商业版Navicat Premium和免费的版本Navicat Lite。免费版本的功能已经足够强大了。 Navicat支持的数据库包括MySQL、Oracle、SQLite、PostgreSQL和SQL Server等。

3、开源ETL工具Kettle Kettle是一款国外开源的etl工具,纯java编写,绿色无需安装,数据抽取高效稳定(数据迁移工具)。Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

?授权协议:LGPL ?开发语言:Java ?操作系统:跨平台 4、Eclipse SQL Explorer SQLExplorer是Eclipse集成开发环境的一种插件,它可以被用来从Eclipse 连接到一个数据库。 SQLExplorer插件提供了一个使用SQL语句访问数据库的图形用户接口(GUI)。通过使用SQLExplorer,你能够显示表格、表格结构和表格中的数据,以及提取、添加、更新或删除表格数据。 SQLExplorer同样能够生成SQL脚本来创建和查询表格。所以,与命令行客户端相比,使用SQLExplorer可能是更优越的选择,下图是运行中的界面,很好很强大。

大数据分析软件

大数据分析软件?安徽象形信息科技专注于大数据分析领域,依托革命性的技术创新,产品远超国内外先进水平,已发展成为国内大数据分析产品领域的领导企业。公司以技术创新为核心战略,与中国科学技术大学成立大数据联合实验室,有效的把创新机制融入到科研、开发、生产和经营的各个环节。目前,已经与中软国际、天源迪科、神州数码、浪潮集团等多家知名企业形成了深入合作。 合肥卷烟厂打造大数据精益管理智能平台 2014年,合肥卷烟厂利用大数据分析软件ETHINK大数据平台技术,打造了大数据精益管理智能平台,深度分析“口袋”里的信息。他们将设备信息、生产信息、质量信息、能源消耗、成本数据等进行融合整理,形成了大数据的高效集成。 以该平台健康诊断云图为例,合肥卷烟厂围绕生产、设备、质量三个维度,利用专家法、层次分析法,设置各项数据彼此间的函数关系,计算出生产、设备、质量每天的分数。将不达标的关键单项指标产生告警,追踪问题缘由,指导问题解决,及时对问

题进行动态优化,并进行自我组织调整。 卷烟厂的大数据智能平台还包含决策管控、智慧社区等几个模块。在车间级管理上,平台可以按照需求,形成智能报表。卷烟厂智能检索知识库包含了经验库、说明书、OPS改善等企业知识成果,员工在遇到难题时可查阅信息,做到了企业知识成果的共享与交流,实现了员工能力提升的目的。 大数据分析软件?ETHINK是业界唯一的端到端的hadoop、spark平台上的大数据分析基础平台。我们的目标是简化大数据分析的过程,让人人都能够快速从数据获得决策智慧。您不再需要采用很多的数据集成、数据清洗、数据预处理、数据分析、数据挖掘、数据可视化、数据报告等众多的工具。ETHINK是一个集成性的平台,能够将您所有的数据,加载到hadoop,spark平台,并能够可视化您的数据,挖掘您的数据的高效平台。

6个用于大数据分析的最好工具

大数据是一个含义广泛的术语,是指数据集,如此庞大而复杂的,他们需要专门设计的硬件和软件工具进行处理。该数据集通常是万亿或EB的大小。这些数据集收集自各种各样的来源:传感器,气候信息,公开的信息,如杂志,报纸,文章。大数据产生的其他例子包括购买交易记录,网络日志,病历,军事监控,视频和图像档案,及大型电子商务。 在大数据和大数据分析,他们对企业的影响有一个兴趣高涨。大数据分析是研究大量的数据的过程中寻找模式,相关性和其他有用的信息,可以帮助企业更好地适应变化,并做出更明智的决策。 一、Hadoop Hadoop是一个能够对大量数据进行分布式处理的软件框架。但是 Hadoop 是以一种可靠、高效、可伸缩的方式进行处理的。Hadoop 是可靠的,因为它假设计算元素和存储会失败,因此它维护多个工作数据副本,确保能够针对失败的节点重新分布处理。Hadoop 是高效的,因为它以并行的方式工作,通过并行处理加快处理速度。Hadoop 还是可伸缩的,能够处理 PB 级数据。此外,Hadoop 依赖于社区服务器,因此它的成本比较低,任何人都可以使用。 Hadoop是一个能够让用户轻松架构和使用的分布式计算平台。用户可以轻松地在Hadoop 上开发和运行处理海量数据的应用程序。它主要有以下几个优点: ⒈高可靠性。Hadoop按位存储和处理数据的能力值得人们信赖。 ⒉高扩展性。Hadoop是在可用的计算机集簇间分配数据并完成计算任务的,这些集簇可以方便地扩展到数以千计的节点中。 ⒊高效性。Hadoop能够在节点之间动态地移动数据,并保证各个节点的动态平衡,因此处理速度非常快。 ⒋高容错性。Hadoop能够自动保存数据的多个副本,并且能够自动将失败的任务重新分配。 Hadoop带有用Java 语言编写的框架,因此运行在Linux 生产平台上是非常理想的。Hadoop 上的应用程序也可以使用其他语言编写,比如C++。 二、HPCC HPCC,High Performance Computing and Communications(高性能计算与通信)的缩写。1993年,由美国科学、工程、技术联邦协调理事会向国会提交了“重大挑战项目:高性能

大数据架构的介绍及分析

大数据架构的介绍及分析 数据分析工作虽然隐藏在业务系统背后,但是具有非常重要的作用,数据分析的结果对决策、业务发展有着举足轻重的作用。随着大数据技术的发展,数据挖掘、数据探索等专有名词曝光度越来越高,但是在类似于Hadoop系列的大数据分析系统大行其道之前,数据分析工作已经经历了长足的发展,尤其是以BI 系统为主的数据分析,已经有了非常成熟和稳定的技术方案和生态系统,对于BI 系统来说,大概的架构图如下: 可以看到在BI系统里面,核心的模块是Cube,Cube是一个更高层的业务模型抽象,在Cube之上可以进行多种操作,例如上钻、下钻、切片等操作。大部分BI系统都基于关系型数据库,关系型数据库使用SQL语句进行操作,但是SQL 在多维操作和分析的表示能力上相对较弱,所以Cube有自己独有的查询语言MDX,MDX表达式具有更强的多维表现能力,所以以Cube为核心的分析系统基本占据着数据统计分析的半壁江山,大多数的数据库服务厂商直接提供了BI套装软件服务,轻易便可搭建出一套Olap分析系统。不过BI的问题也随着时间的推移逐渐显露出来: BI系统更多的以分析业务数据产生的密度高、价值高的结构化数据为主,对于非结构化和半结构化数据的处理非常乏力,例如图片,文本,音频的存储,分析。 由于数据仓库为结构化存储,在数据从其他系统进入数据仓库这个东西,我

们通常叫做ETL过程,ETL动作和业务进行了强绑定,通常需要一个专门的ETL团队去和业务做衔接,决定如何进行数据的清洗和转换。 随着异构数据源的增加,例如如果存在视频,文本,图片等数据源,要解析数据内容进入数据仓库,则需要非常复杂等ETL程序,从而导致ETL变得过于庞大和臃肿。 当数据量过大的时候,性能会成为瓶颈,在TB/PB级别的数据量上表现出明显的吃力。 数据库的范式等约束规则,着力于解决数据冗余的问题,是为了保障数据的一致性,但是对于数据仓库来说,我们并不需要对数据做修改和一致性的保障,原则上来说数据仓库的原始数据都是只读的,所以这些约束反而会成为影响性能的因素。 ETL动作对数据的预先假设和处理,导致机器学习部分获取到的数据为假设后的数据,因此效果不理想。例如如果需要使用数据仓库进行异常数据的挖掘,则在数据入库经过ETL的时候就需要明确定义需要提取的特征数据,否则无法结构化入库,然而大多数情况是需要基于异构数据才能提取出特征。 在一系列的问题下,以Hadoop体系为首的大数据分析平台逐渐表现出优异性,围绕Hadoop体系的生态圈也不断的变大,对于Hadoop系统来说,从根本上解决了传统数据仓库的瓶颈的问题,但是也带来一系列的问题:从数据仓库升级到大数据架构,是不具备平滑演进的,基本等于推翻重做。 大数据下的分布式存储强调数据的只读性质,所以类似于Hive,HDFS 这些存储方式都不支持update,HDFS的write操作也不支持并行,这些特性导致其具有一定的局限性。 基于大数据架构的数据分析平台侧重于从以下几个维度去解决传统数据仓库做数据分析面临的瓶颈: 分布式计算:分布式计算的思路是让多个节点并行计算,并且强调数据本地性,尽可能的减少数据的传输,例如Spark通过RDD的形式来表现数据的计算逻辑,可以在RDD上做一系列的优化,来减少数据的传输。

大数据可视化和分析工具

大数据可视化和分析工具 大数据将为社会带来三方面变革:思维变革、商业变革、管理变革,各行业将大数据纳入企业日常配置已成必然之势。学习大数据的热潮也是风起云涌,千锋大数据全面推出新大纲,重磅来袭,今天千锋小编分享的是大数据可视化和分析工具。 1、Excel2016 Excel作为一个入门级工具,是快速分析数据的理想工具,也能创建供内部使用的数据图,同时,它也支持3D的可视化展示,微软发布了一款叫做GeoFlow 的插件,它是结合Excel和Bing地图所开发出来的3D数据可视化工具,可以直接通过Bing地图引擎生成可视化3D地图。但是Excel在颜色、线条和样式上课选择的范围有限,这也意味着用Excel很难制作出能符合专业出版物和网站需要的数据图。 2、SPSS 22 SPSS 22版本有强大的统计图制作功能,它不但可以绘制各种常用的统计图乃至复杂的3D视图,而且能够由制作者自定义颜色,线条,文字等,使制图变得丰富多彩,善心悦目。 3、R语言 R具有强大的统计计算功能和便捷的数据可视化系统。ggplot2是一个用来绘制统计图形的R软件包。ggplot2是由其背后的一套图形语法所支持的,它可以绘制出很多美观的图形,同时能避免诸多繁琐的细节。ggplot2采用了图层的设计方式,你可以从原始的图层开始,首先绘制原始数据,然后不断地添加图形注释和统计汇总的结果。

4、Tableau Public Tableau不仅可以制作图表、图形还可以绘制地图,用户可以直接将数据拖拽到系统中,不仅支持个人访问,还可以进行团队协作同步完成数据图表绘制。 5、Google Charts Google Charts提供大量数据可视化格式,从简单的散点图到分层树地图。可视化效果是完全个性化的,你可以通过动态数据进行实时连接。Google Charts可以兼容多个浏览器以及在多个平台可使用(IOS和安卓设备)。 6、D3.js D3 是流行的可视化库之一,它被很多其他的表格插件所使用。它允许绑定任意数据到DOM,然后将数据驱动转换应用到Document中。你可以使用它用一个数组创建基本的HTML表格,或是利用它的流体过度和交互,用相似的数据创建惊人的SVG条形图。 7、Gephi Gephi是一个支持动态和分层图的交互可视化与探测工具。Gephi强大的OpenGL引擎允许实时可视化,可以支持网络多达50,000个节点1,000,000条边。它给用户提供了切割边缘布局算法,包括基于力的算法和多层次算法,使得操作体验更高效。此外,该软件是完全免费使用,该公司仅收私有仓库的费用。 8、echarts echarts不是外国的,是国内百度团队的产物。总所周知,百度统计做得挺不错的。他们这个echarts也算是用到淋漓尽致。社区也算比较活跃,例子也十分多,实用一样方便。 9、highcharts