iscsi-测试以及liunx编程问题

软件实现iSCSI Target和Initiator

一 安装MS iSCSI Initiator客户端

二 安装并配置Windows iSCSI Target服务器

三 配置MS iSCSI Initiator客户端,测试MultiPath

四 利用CHAP进行登录验证

五 对Microsoft Cluster的支持

六 安装并配置Redhat Linux AS4U2 iSCSI Initiator客户端

一 安装MS iSCSI Initiator客户端

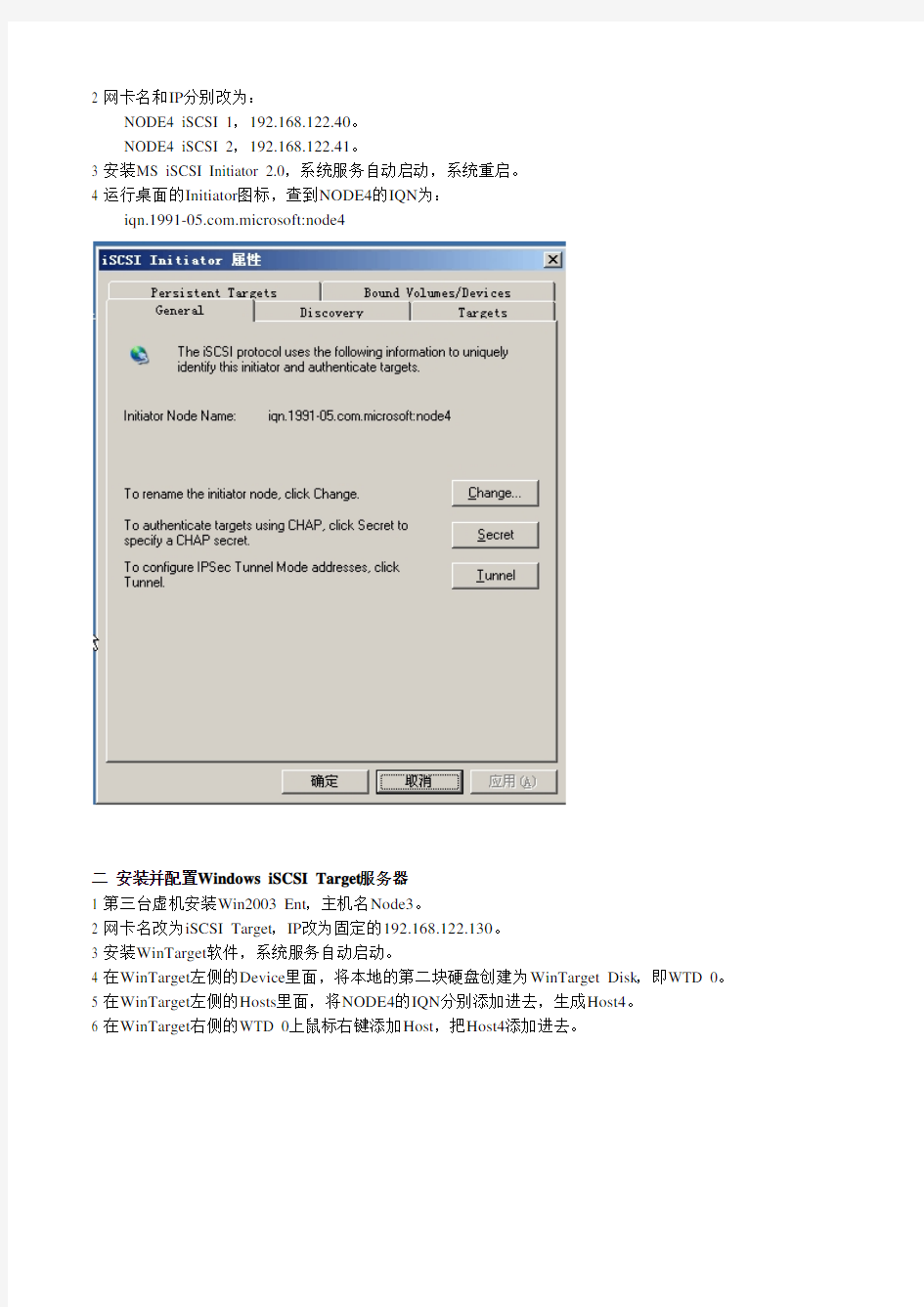

1 新建一台虚机,双网卡(为测试Multipath)。安装Win2003 Ent,主机名Node4。

2 网卡名和IP分别改为:

NODE4 iSCSI 1,192.168.122.40。

NODE4 iSCSI 2,192.168.122.41。

3 安装MS iSCSI Initiator 2.0,系统服务自动启动,系统重启。

4 运行桌面的Initiator图标,查到NODE4的IQN为:

https://www.wendangku.net/doc/693560105.html,.microsoft:node4

二 安装并配置Windows iSCSI Target服务器

1 第三台虚机安装Win2003 Ent,主机名Node3。

2 网卡名改为iSCSI Target,IP改为固定的192.168.122.130。

3 安装WinTarget软件,系统服务自动启动。

4 在WinTarget左侧的Device里面,将本地的第二块硬盘创建为WinTarget Disk,即WTD 0。

5 在WinTarget左侧的Hosts里面,将NODE4的IQN分别添加进去,生成Host4。

6 在WinTarget右侧的WTD 0上鼠标右键添加Host,把Host4添加进去。

三 配置MS iSCSI Initiator客户端,测试MultiPath

1运行桌面的Initiator图标,点击Discovery标签,在Target Portals下点Add,添加iSCSI Target服务器的IP,再点OK即可。

2 在Target标签下,出现刚刚添加的iSCSI Target服务器。Name是https://www.wendangku.net/doc/693560105.html,.stringbeansoftware:node3-node4-target,Status是Inactive。

3 点击Log On,将Automatic restore…和Enable multi-path的钩选上,再点Advanced。

4 将Local adapter改为Microsoft iSCSI Initiator,Source IP选成第一块网卡的IP,192.168.122.40,Target Portal选iSCSI服务器的192.168.122.130,完成第一块网卡的登录。

5 重复步骤3-4,Source IP选第二块网卡的IP,即192.168.122.41,完成第二块网卡的登录。

6 回到Target标签,Status变为Connected,点Details。

7 发现有了两个session,分别为xxxxx5和xxxxx6。即两块网卡都登录成功。

下面要配置两块网卡的Multipath。有两种Multipath,Multiple connections per session (MCS)和Microsoft MPIO。MCS允许在一个session中建立多个TCP连接,且对所有的LUN只能实施一种Load Balance Policy。MPIO允许建立多个session,且可以对不同的LUN实施不同的Load Balance Policy。这里使用的是MPIO。

在session标签下面,有个connection按钮,点进去可以配置MCS。若要配置MPIO,则要切换到Devices 标签下进行配置。

8 切换到Devices标签,发现了两个设备。点Advanced。

9 从General切换到MPIO标签下,发现Load Balance Policy为Fail Over Only,双网卡是Active/Standby模式。

10 将Load Balance Policy改为Round Robin,则原Standby网卡的Type变为Active。

11 点一个Path的Details进去,可以发现其Source IP,即为第二块网卡的IP。

12 到磁盘管理中,对新的硬盘进行分区。注意:软件iSCSI不支持动态磁盘和启动分区!!!

13 到我的电脑中,发现新添加的分区已经就绪,可以读写。

14 对该分区写入大文件,发现双网卡同时工作(不能拔网卡!)。注意红色数字圈,共3处。

15 将Load Balance Policy改回Fail Over Only,再次写入大文件,发现只有一个网卡工作。注意红色数字圈,共3处。

16 拔掉第一块网卡,5秒左右后,自动fail-over到第二块网卡。注意红色数字圈,共4处。

注:也可在WinTarget服务器上配置双网卡,配置Multipath。

四 利用CHAP进行登录验证

1 在服务器端的WinTarget上,对Host进行Authentication设置。启用CHAP验证,用户名就是IQN号,再输入一个大于12位的密码。

2 在客户端的iSCSI Initiator上,在Logon的时候,点Advanced制定登录IP等信息时,选中用CHAP验证,并输入密码,即可完成登录。

五 对Microsoft Cluster的支持

因为iSCSI磁盘支持SCSI RESERVE和RELEASE命令,所以Microsoft Server Cluster (MSCS)支持将iSCSI磁盘作为共享存储(包括quorum盘)。

Microsoft MPIO和Microsoft iSCSI DSM可与MSCS同时使用。Windows 2000只支持failover一种load balance policy。尽管Windows 2000支持iSCSI Server cluster,但是MS更多支持Windows Server 2003:

https://www.wendangku.net/doc/693560105.html,/windowsserver2003/technologies/storage/iscsi/iscsicluster.mspx

大致步骤:

在下例中,双机节点分别为node1和node3,iSCSI WinTarget服务器为node2。共享盘为Q:

1 在WinTarget服务器上,为共享的iSCSI磁盘分配第二个Host,即node3。相当于为DS300的一个逻辑驱动器,添加了两个IQN访问权。

2 在node3上通过iSCSI initiator连接到共享磁盘,在磁盘管理中,发现新的未分区磁盘。创建分区,制定字母Q,卷名Quorum。

3 将Q盘作为仲裁,配置好双机后,node1状态如下,磁盘Q,群集IP,群集名均属于node1。

4 从node1,在Q上建立测试文件,HAtest on node1.txt。

5 用群集管理器,将组移动到node3。下图为正在移动组,状态为联机挂起。

6 组成功的移动到了node3上面。所有者为node3,状态都是联机。

7在node3上,可以找到node1上建立的文件。在Q上建立测试文件,HAtest on node3.txt。

8 再将组切换回node1。可以发现在node3上创建的文件,和先前在node1上创建的文件。

六 安装并配置Redhat Linux AS4U2 iSCSI Initiator客户端

1 在node4上安装Redhat AS4U2,并用netconfig命令为linux中的网卡设置固定IP。

2 在WinTarget服务器的Hosts里面,将NODE4的IQN改为其IP,192.168.122.40。

3 Redhat AS4U2已经自带iSCSI驱动,还需要安装iSCSI-initiator-utils包。

4 装好包后,运行命令”modprobe iscsi_sfnet”,加载module到kernel。

5运行命令”lsmod | grep iscsi’,发现iscsi_sfnet和scsi_transport_iscsi已经加载成功。

6运行命令” vi /etc/iscsi.conf’,编辑配置文件。

7 在Network Category中,修改如下行:

Subnet=192.168.122.0/24

在Discovery Address Category中,修改如下行:

DiscoveryAddress=192.168.122.130:3260

在Target Name Category中,修改如下行:

TargetName=https://www.wendangku.net/doc/693560105.html,.stringbeansoftware:node3-node4-target

在Enable/Disable Target中,修改如下行:

Enable=yes

在Continuous Discovery Settings中,修改如下行:

Continuous=yes

8 修改后,运行’’service iscsi start’,启动iscsi服务,会检查iscsi配置,加载iscsi驱动,并启动守护进程iscsid,最终发现服务器上的iscsi共享磁盘,见下图,为sdb,空间1G。

9 运行” parted /dev/sdb”,并用”list”可以发现sdb已经有了一个分区,且文件系统为ntfs,是因为之前在windows做过分区。

10 退出parted后,运行”mkfs -t ext3 /dev/sdb1”,格式化为ext3文件系统。

11 运行”mount /dev/sdb1 /mnt/”将其挂载到本地,运行”df -lh”显示其容量,为996M。

12 运行”iscsi-ls -l”显示,显示连接的LUN信息。

13 运行”dd if=/dev/zero of=/mnt/test bs=1024 count=409600”,创建一个400M的测试文件。如下图,会通过网卡将文件存储到iscsi服务器。

14 测试完成。为了今后每次启动linux时都能自动挂载网络上的iscsi硬盘,按如下步骤:

a 运行”vi /etc/rc.modules”,添加modprobe iscsi_sfnet,再运行”chmod ugo+x /etc/rc.modules”, 从而每次启动linux时,自动加载iscsi module。

b 运行”chkconfig --level 345 iscsi on”, 从而每次启动linux时,自动启动iscsi服务。

c 运行”vi /etc/fstab”,添加/dev/sdb1 /mnt ext3 _netdev 0 0,自动挂载设备。

15 若要停止iscsi设备,则要先umount,再service iscsi stop,即可。

七 关于iSCSI Multhpath的补充说明

This release of iSCSI include support for establishing redundant paths for sending I/O from the initiator to the target. Setting up redundant paths properly is important to ensure high availability of the target disk. Ideally the PC would have the paths use separate NIC cards and/or iSCSI HBA, separate network infrastructure (cables, switches, routers, etc) and separate target ports. There are two mechanisms that this release of iSCSI supports for high availability and fail over: multiple connections per session (MCS) and Microsoft MPIO support.

Multiple connections per session (MCS) support is defined in the iSCSI RFC to allow multiple TCP/IP connections from the initiator to the target for the same iSCSI session. In this way I/O can be sent over either TCP/IP connection to the target. If one connection fails another connection can continue processing I/O without interruption to the application. Note that not all iSCSI targets support MCS. The MS iSCSI initiator kernel mode driver supports a set of load balance policies that determine how I/O is allocated among the different connections.

Microsoft MPIO support allows the initiator to login multiple sessions to the same target and aggregate the duplicate devices into a single device exposed to Windows. Each session to the target can be established using different NICs, network infrastructure and target ports. If one session fails then another session can continue

processing I/O without interruption to the application. Note that the iSCSI target must support multiple sessions to the same target. The Microsoft iSCSI MPIO DSM support supports a set of load balance policies that determine how I/O is allocated among the different sessions. Microsoft MPIO is supported on Windows 2000 Server platforms, Windows Server 2003 platforms, and future Windows Server platforms. Microsoft MPIO is not supported on Windows XP or Windows 2000 Professional.

For MCS the load balance policies apply to connections in a session and apply to all LUNs exposed in the session. For Microsoft MPIO the load balance policies apply to each LUN individually.

The Microsoft iSCSI DSM assumes that all targets are active/active and can handle IO on any path at any time. There does not exist a mechanism within the iSCSI protocol to determine whether a target is active/active or active/passive, therefore, the UI will always show all load balance policies as available to be configured for a target even if the target does not support them or if the target is active/passive. In this case, you should contact your iSCSI target vendor for an appropriate DSM that works with their target.

MCS supports all of the load balance policies detailed below on Windows 2000, XP and 2003. Microsoft MPIO support for iSCSI supports all of the policies on Windows 2003 and failover only on Windows 2000 Server.

?Fail Over Only: No load balancing is performed. There is a single active path and the rest of the paths are standby paths. The active path is used for sending all I/O. If the active path fails

then one of the standby paths is used When the formally active path is reconnected it will

become active and the standby path that was activated would return to standby.

?Round Robin: All paths are active paths and they will be used for sending I/O in a round robin fashion.

?Round Robin with a subset of paths: A set of paths are configured as active and a set of paths are configured as standby. I/O is sent in a round robin fashion over the active paths. If

all of the active paths fail then one of the standby paths is used. If any of the formerly active

paths become available again then the formerly active paths are used and the standby path

that was activated becomes a standby path again.

?Weighted Path: Each path is assigned a weight and I/O will be sent on the path with the lowest weight. If the path with the lowest weight fails then the path with the next lowest weight

will be used.

?Least Queue Depth: This is only supported by MCS. The path that has the fewest number of requests queued is the one where the I/O is sent.

There are a number of things to consider when choosing to use MCS or Microsoft MPIO for multipathing.

z If your configuration uses hardware HBA then Microsoft MPIO should be used.

If your target does not support MCS then Microsoft MPIO should be used.

z

If your target does support MCS and you are only using the Microsoft software initiator driver then MCS is z

likely the best option. There may be some cases where you want a consistent management interface among multipathing solutions and already have other Microsoft MPIO solutions installed that may make Microsoft MPIO an alternate choice in this configuration.

If you need to specify different load balance policies for different LUNs then Microsoft MPIO should be z

used.

LINUXISCSITarget服务器搭建与windows客户端连接

Linux ISCSI 服务器搭建与客户机ISCSI 连接 ISCSI 简介: iSCSI 技术是一种由IBM 公司研究开发的,是一个供硬件设备使用的可以在IP 协议的上层运行的SCSI 指令集,这种指令集合可以实现在IP 网络上运行SCSI 协议,使其能够在诸如高速千兆以太网上进行路由选择。iSCSI 技术是一种新储存技术,该技术是将现有SCSI 接口与以太网络(Ethernet)技术结合,使服务器可与使用IP 网络的储存装置互相交换资料。 网络拓扑: CentOS 6.3 ISCSI Server Target IP:192.168.2.54 ISCSI Initiator IP:192.168.2.55ISCSI Initator IP:192.168.2.230 实验环境: ISCSI Target: CentOS 6.3 IP:192.168.2.54 ISCSI Initator: CentOS 6.3 IP:192.168.2.55 windows server 2012 IP :192.168.2.230 一. ISCSI Target 的搭建: 1. 在ISCSI target 服务器上添加一块新的硬盘,用于ISCSI Target 存储。

2.创建LVM。在此具体操作略掉。操作结果如下图: 分别为linux iscsi initator,Windows server 2012创建LV.逻辑卷lvlinux和lvwindows ,大小都为2GB的容量。

3.在CentOS上安装iscsi target,在这里我采用YUM的安装方式。 4.修改ISCSI TARGET的配置文件,配置文件为/etc/tgt/targets.conf,使用vim工具修改 配置文件:分别为linux 客户端和windows server 2012客户端建立两个target (linux-target,windows-target),将两个target 关联到之前创建的LV上,并且配置用户名和密码认证(用户名和密码都为test),同时限制只有相应IP地址的客户端才能访问iscsi target.如图: 添加target:

iscsi总结

1iscsi工作原理与服务器搭建 1.1概念 iSCSI是因特网小型计算机系统接口(internet Small Computer System Interface)的简称,其是IETF制订的一项标准,用于将SCSI数据块映射为以太网数据包。从根本上来说,它是一种基于IP Storage 理论的新型存储技术。简单的说,iSCSI就是在IP网络上运行SCSI 协议的一种网络存储技术。 一个可以用于存储数据的iSCSI磁盘阵列或者具有iSCSI功能的设备都可以称为“iSCSI Target”。目前大部分iSCSI Target 都是收费的,例如DataCoreSoftware,FalconStor Software的iSCSI Server for Windows等,这些都是支持Windows平台的。不过在linux平台下也存在iSCSI Target软件,例如iSCSI Enterprise Target,而这也是我们KMJ 所使用的,后面则会重点介绍该软件。 1.2iSCSI的工作原理 首先客户端Initiator发出请求建立SCSI CDB(命令描述块),并将其传给iSCSI层。而iSCSI 层则对SCSI的CDB进行封装,完成SCSI到TCP/IP的协议的映射。TCP/IP层则对IP报文进行路由转发,并且提供端到端的透明可靠的传输。 1.3搭建iSCSI Target服务器

1寻找一台linux服务器,搭建好yum源,我们一般使用kylin 3.1.8或kylin3.2.2操作系统。 2安装iSCSI Target 包 yum–y install scsi-target-utils 3在该服务器上添加一块空闲分区或者硬盘作为存储盘,比如将/dev/sdb作为映射存储。 4修改配置文件vi /etc/tgt/targets.conf

Linux 下iSCSI Target和Initiator安装与操作步骤详解

Linux 下iSCSI Target和Initiator安装与操作步骤详解iSCSI Target 编译安装过程 1. 解压:tarzxvf iscsitarget-1.4.18.t ar.gz 2. cd iscsitarget-1.4.18 3. Linux2.6.32的内核太新了最新的iSCSI Target版本1. 4.18还没有支持,网上有高手做 了相应的补丁,于是打上补丁patch -p1 安装 不同的操作系统对应各自的iSCSI initiator,以CentOS 6.5为例。 安装方法有两种: 1)直接使用“yum install iscsi*”进行安装; 2)到网上下载 iscsi-initiator-utils-devel-6.2.0.873-10.el6.x86_64 iscsi-initiator-utils-6.2.0.873-10.el6.x86_64 使用“ rpm -ivh iscsi-initiator…”命令进行安装。 安装完成后,启动iscsi守护进程 [root@CentOS1 桌面]#service iscsid start 将iscsid添加到系统启动 [root@CentOS1 桌面]#chkconfig iscsid on [root@CentOS1 桌面]#chkconfig iscsid --list (查看ISCSI启动状态) 挂载iSCSI主要用到的工具叫“iscsiadm”,iscsiadm是基于命令行的iscsi管理工具,提供了对iscsi节点、会话、连接以及发现记录的操作。 iscsiadm的使用说明可以查看sr/share/doc/iscsi-initiator-utils-6.2.0.873/README,也可以运行man iscsiadm 或iscsiadm --help 使用 首先要在存储设备上做好RAID,设置好iSCSI 目标方(target)。由于只是做实验,我就使用了一个开源软件来模拟iSCSI存储设备,软件名称叫openfiler,可以使用虚拟机来安装,详细可以查阅相关的教程。 下面来讲一下连接iscsi设备的步骤: 1)发现目标 默认情况下,iscsi发起方和目标方之间通过端口3260连接。假设已知iscsi的目标方IP是10.10.13.3,运行下列命令: [root@CentOS1 桌面]#iscsiadm -m discovery -t sendtargets -p 10.10.13.3:3260 (若端口是默认端口,IP后面 一、确认存储具备iSCSI连接功能。存储上的iSCSI IP地址已配置,iSCSI接口 与服务器网卡已能够通讯。可以在服务器端通ping命令检验。 二、在服务器端检查/安装iSCSI 发起程序(以redhat为例) 检查iscsi发起程序的rpm package是否安装 rpm -qa |grep open-iscsi 在命令行下输入iscsiadm,看是否有此命令 Iscsiadm 安装iscsi发起程序 挂载linux系统安装盘,用rpm –ivh 命令安装open-iscsi包、或者iscsi-initator 包。 三、打开iscsi服务 chkconfig --list open-iscsi chkconfig --level 0123456 open-iscsi vi /etc/iscsi/iscsid.conf 编辑(或确认)是否已禁用node.startup = manual 行。 编辑(或确认)是否已禁用node.startup = automatic行。这将在引导时自动启动该服务。重启后,iscsi存储即为挂载状态。 四、确保iscsi服务已经运行 /etc/init.d/open-iscsi start 五、挂载iscsi存储 发现iscsi目标 iscsiadm -m discovery -t sendtargets -p P4000实验—Windows下iSCSI多链路冗余实验 实验目的:了解Windows系统下P4000网卡绑定以及多路径设置实验设备:DL380 G7 + P4500 G2+Windows Server 2003 实验步骤: 一、配置主机和存储之间的链路冗余--------------------------------------------------------------2~18 二、单个物理节点环境中链路冗余状态----------------------------------------------------------19~22 三、多个物理节点环境中链路冗余状态----------------------------------------------------------23~36 一、配置主机和存储之间的链路冗余 首先连接键盘和显示器,进入P4000的SAN/IQ设置物理节点的IP地址为192.168.1.100 设置主机3号网卡IP地址为:192.168.1.10,4号网卡IP地址为192.168.1.20,然后确认主机网卡和物理节点通信正常 在服务器上安装CMC后,开始查找系统 点击添加,输入物理节点的IP地址,开始查找节点 找点节点后,左边菜单出现可用系统 先点击节点下面的TCP/IP,然后选中两个网卡,右键点击新建绑定 如无特殊需求,一般建议选择ALB模式(即可以实现冗余,又可以实现负载均衡) 点击确定开始绑定 绑定后重新查找一下节点 找到后,再次查看物理节点网卡状态,多出一个bond0(即绑定的虚拟网卡) 在主机上安装Windows iSCSI Initator,然后把主机的IQN复制下来 1.1 连接ISCSI Iscsi包:iscsi-initiator-utils-6.2.0.742-0.5.el5.i386.rpm(Open-iSCS提供https://www.wendangku.net/doc/693560105.html,/) 1.1.1 安装rpm包Linux心得https://www.wendangku.net/doc/693560105.html, 将iscsi包cp到本地盘,并在该包所在的目录下运行命令 运行此命令后,会生成一个目录/etc/iscsi,该目录下有两个文件: Initiatorname.iscsi和iscsid.conf 1.1.2 启动ISCSI服务 安装完iscsi服务默认是关闭的,需要手工启动,并将iscsi服务设置成系统启动时启动 1.1.3 搜寻盘阵Linux学习https://www.wendangku.net/doc/693560105.html, 运行以下命令搜寻target,即目标端:7612i存储 以上IP即是7612i的iscsi口的IP,其它固定。 1.1.4 显示盘阵 显示存储端target name 显示结果与在7612i串口iscsi m a nagement→iscsi node名字相同 1.1.5 登陆盘阵 target登陆 其中targetnam e即是步骤4中结果。(注:横杆是中杠) (注:3,4,5实施中是在/etc/iscsi下运行,是否可以在别的路径执行,可自行测试。以上3个命令格式是从man iscsiad m查出) 1.1.6 设置自动启动盘阵服务 经过以上几步,fdisk –l就可以看到所挂接分区了,为确保重启后也能看到,再修改一下/etc/iscsi/iscsid.conf,将第5步的命令iscsiadm --m ode node --targetnam e targetnam e --portal 192.168.1.221:3260 --login 添加到该文件中的开始部分 ***************** # Startup settings #***************** 这个栏下面即可。 其实这个文件大多数内容处于被注释状态,该命令添加位置应该影响不大.然后重启电脑后直接fdisk –l 依然可以看到所挂接的分区。至此iscsi所有操作完成,但挂载的分区不是linux 所识别,必须使用FDISK进行磁盘分区。 1.2 设置分区 1.使用多块磁盘建立raid Freenas的raid级别定义 raid 0 ------------------------ stripe raid 1 ------------------------mirror raid 5 ----------------------- RAID-Z raid 10 \ raid 6 ------------RAID-Z2 UFS Volume manager(UFS卷管理)模式下,只能建立raid 0,1,3 ZFS Volume manager(动态文件系统卷管理)模式下,可以建立raid 0,1,5,6,1+0,还可以将磁盘设为备份模式 现在使用ZFS模式,利用4块硬盘建立一个raid 5 这个raid5建好了,少了30G的空间,也就是1.5块磁盘空间(理论上是只少一块盘的空间) 2.在新建的raid磁盘上建立2个目录,其中nfs目录等下做NFS共享,cifs目录等下做CIFS共享给windows 3.发布NFS共享 选择NFS共享的目录路径/mnt/raid-5/nfs,然后点击确定 发布出去的NFS共享如下图 由于nfs目录没有给other用户增加写入权限,所以客户端连接过来后是不能写入数据的,需要更改目录权限 4.使用esxi进行挂载 成功挂载,如下图 进行写入测试 5.发布CIFS共享给windows客户端 发布出去的CIFS共享如下图 由于cifs目录没有给other用户增加写入权限,所以客户端连接过来后是不能写入数据的,需要更改目录权限 6.在win 7上进行访问测试 写入测试 7.发布iscsi共享存储 小知识: iSCSI的主要功能是在TCP/IP 网络上的主机系统(启动器initiator)和存储设备(目标器target)之间进行大量数据封装和可靠传输。此外,iSCSI在IP网络封装SCSI 命令,且运行在TCP上。 虚拟化系列-Windows server 2012 存储管理目前发布的 Windows Server 2012 是有史以来最强大最灵活的平台。因此 Windows Server 2012 对每个人都能提供收益。计划内和计划外的停机时间可以大幅减少。新增和改进的功能提供了成本低廉,可长时间持续运行的 IT 服务。Windows Server 2012 在设计上可以减少甚或避免对用户服务的中断。同时还提供了很多强大的新功能,在本节存储章节中主要讲解4个部分的内容:1、VHDX磁盘介绍与创建、2、NFS共享服务。3、SCSI Software Target Server,为其他使用业界标准 iSCSI 的应用程序服务器提供高可用的块存储。4、重复数据删除。通过重复数据删除技术可充分利用存储投资并降低成本,该技术可通过找出并删除重复的数据,减少存储空间用量,提升存储效率。 一、VHDX简介 Hyper-V虚拟机存储包括有多种,其中最主要的是以微软VHD虚拟磁盘作为介质的存储,其使用串流技术来传送高性能、高弹性、可扩展性的虚拟磁盘到用户端。通过这种新一代Hyper-V存储的集中管理、分散运算的架构,可在管理端实现磁盘及软件的安装、更新、备份、还原及杀毒等操作,同时用户端保留个人计算机使用习惯,并能充分利用本机运算能力。微软的VHD文件格式是一种虚拟机磁盘(virtual machine hard disk) , VHD格式文件可以被压缩成单个文件存放在宿主机器的文件系统上,这种格式文件主要指虚拟机启动所需系统文件。Hyper-V 可以离线操作VHD,使得管理员可以通过一个VHD文件安全进入系统,管理员可以访问虚拟文件(VHD)和执行一些离线的管理任务。 而VHDX(虚拟磁盘格式),由微软推出,Windows server 2012将支持VHDX文件,VHDX 是Windows Server 2012 中Hyper-V 默认用于取代VHD 的新格式。这一新格式在设计上主要用于代替老旧的VHD 格式,可提供更多高级特性,使其更适合用作以后的虚拟化负载所需的虚拟磁盘格式。新的VHDX格式能支持16TB空间,是当前的VHD格式的2TB空间限制的8倍,由于VHDX技术是新推出的磁盘格式,微软对其技术参数严格保密。与旧的 VHD 格式相比,VHDX 具有更大的存储容量。它还在电源故障期间提供数据损坏保护并且优化动态磁盘和差异磁盘的结构对齐方式,以防止在新的大型扇区物理磁盘上性能降级。 一、存储端的设置。 初始ip地址:192.168.128.101(控制器A)192.168.128.102(控制器B) 用户名密码:admin/Admin@storage 1.做好RAID,划分好LUN。做好热备盘。顺序读写磁盘选择64kb分条,随机读写磁 盘选择32kb。控制器选择一般均匀分布。 2.添加主机端口访问IP,根据网线插入的端口给访问端口添加IP,一般每个控制器接 入一个访问IP。H4口是管理口,H0-H3是主机访问端口。H5是维护网口。 3.添加主机组,或者使用默认主机组。 4.添加主机,LUN卷要分给多少主机,就必须添加多少个主机。 5.添加映射,可以添加给主机组和主机,作为主机作为集群应用时才把LUN映射给主机组。选择主机右键添加lun映射。 选择要添加的LUN。 二、服务器端设置 1、在linux机器上 rpm -qa |grep iscsi yum –y install iscsi* rpm -qa |grep iscsi iscsi-initiator-utils-6.2.0.872-41.el6.x86_64 已经安装了,所有就不用在安装!!! 如果没有就需要安装 安装iscsi-initiators yum -y install iscsi-initiator-utils* 4.2 启动服务,并让其下次开机生效 service iscsi start; chkconfig iscsi on chkconfig --list iscsi iscsi 0:off 1:off 2:on 3:on 4:on 5:on 6:off 2、配置服务器ip地址和存储器的访问口ip同一网段。 #ifconfig eth0 ipadd netmask 3、配置服务器端iSCSi启动器。 #vi /etc/iscsi/initiatorname.iscsi InitiatorName=initiator002 #initiator002是服务器端提交给存储的启动器名。 #iscsiadm –m discovery –t st -p 10.0.0.0.11 #发现ip地址为10.0.0.11的存储器。 #iscsiadm –m node –p 10.0.0.11 -l #登录目标存储。 #vi /etc/iscsi/iscsid.conf 输入:node.startup=automatic #重新启动后自动建立连接 #etc/init.d/iscsi restart #重启服务 #iscsiadm –m node #查询已经登录的目标存储 三、存储器端添加启动器到主机。 选择启动器,右键添加到主机。 目录 基于Linux后端的iSCSI配置与使用 一、? iSCSI简介 1. NAS 2. SAN 3. iSCSI架构 二、?配置Linux存储服务器为iSCSI-target 1. iscsi-target-enterprise安装 2. 配置与启动 三、?配置Windows为iSCSI-initiator 1. 微软iSCSI-initiator安装 2. 配置与启动 四、?配置Linux为iSCSI-inititor 1. 安装 2. 配置与启动 五、?总结 一、? iSCSI简介 提到iSCSI,这里需要首先介绍一下目前应用最为广泛的两种数据存储设备:NAS与SAN。 1. NAS NAS的全称是Network-attached storage,即网络连接存储设备。NAS设备通常是一个完整的服务器架构,包含了CPU、?内存、?网卡、?磁盘,其上安装通用操作系统或者精简的专用操作 系统,并通过扩展接口连接了大量存储阵列。NAS的访问形式是通过TCP/IP网络进行远程访问,NAS自身的操作系统上运行着相应的网络服务程序,比如 Windows文件共享服务、?Linux Samba文件共享服务、?Linux/Unix的NFS文件系统等。需要访问NAS的设备,通过TCP/IP网络,在远程使用客户端软件来访问。 Windows文件共享是操作系统自身已经包含,Linux则需要安装Samba客户端或者NFS客户端来访问NAS设备。 NAS主要用途是大容量存储,并带有一定的冗余功能,侧重点在于容量和相对较低的实施成本,对于吞吐量、?并发数、?冗余性能等通常要求不高。此外,由于 NAS的访问形式是文件共享式的访问,操作系统只能将NAS设备挂载成一个网络共享设备,而一些操作系统原生特性是无法在网络共享文件系统上实现的,例如 磁盘配额、?格式化磁盘、?组件磁盘阵列等都不能在远程上实现,这也给NAS的应用造成了一定的局限性。 如图,在远程的Windows系统中挂载NAS提供的网络驱动器。 连接磁盘阵列的方法 ——在RedHat linux系统下一、redhat 将磁盘阵列与主机连接 在PC机的网卡上挂载与磁盘阵列相同网段的IP,保证PC机能ping 通盘阵上提供的IP。 如果没有安装iscsi-initiator首先要下载适合系统内核的iscsi-initiator-utils [root@localhost ~]# yum install iscsi-initiator-utils 下载安装好后可寻找iscsi设备,结果显示为找到的设备 [root@localhost ~]# iscsiadm -m discovery -t st -p 192.168.144.197 192.168.144.197:3260,1 https://www.wendangku.net/doc/693560105.html,rtrend:raid.sn7051919.00 设备ip后加上为上面查到的设备iqn号 [root@localhost ~]# iscsiadm -m node -p 192.168.144.197 -T iqn.2002-https://www.wendangku.net/doc/693560105.html,rtrend:raid.sn7051919.00 -l 重启iscsi服务 [root@localhost ~]#/etc/init.d/iscsi restart 或者service iscsid restart Stopping iSCSI initiator service: [ OK ] Starting iSCSI initiator service: [ OK ] 查看磁盘和iscsi设备 [root@localhost ~]# fdisk -l Disk /dev/hda: 60.0 GB, 60011642880 bytes 255 heads, 63 sectors/track, 7296 cylinders Units = cylinders of 16065 * 512 = 8225280 bytes Device Boot Start End Blocks Id System /dev/hda1 * 1 1020 8193118+ 7 HPFS/NTFS /dev/hda2 1021 6665 45343462+ f W95 Ext'd (LBA) 各种操作系统下iscsi存储设备挂载方法???(ip san架构)在discovery里面add添加的是存储上定义好的iscsi口的ip 地址。 这样就服务器方面就设置好了。剩下的就是对存储的具体配置了。我就不多说了。 下面是我找的一点关于这个软件的使用 几种常用的操作系统下iSCSI Initiator的使用 本文是我在研制固态iSCSI服务器软件时所做的一些实验的总结,都没有涉及身份验证功能的使用,如需要了解如何使用身份验证功能,请参考相应软件的帮助文件或在线man文档。 WindowxXP、 Windows2000、 Windows2003 RedHat Enterpris Linux 5 Fedora core 6 、Fedora 7 FreeBSD5.4、FreeBSD6.2 Open Solaris WindowxXP、 Windows2000、 Windows2003 安装 可用于windows2000、windowsXP、windows2003的较新版本iscsi-initiator 程序是Initiator-2.04-build3273,下载该程序后安装。 用法 安装成功后产生程序组Microsoft iSCSI Initiator, 桌面也有相应图标。基本操作如下: 点击 Microsoft iSCSI Initiator—>Discovery—>Add—>输入target的IP地址和端口号 点击 Microsoft iSCSI Initiator—>Targets—>Refresh, 发现当前可用的Target 点击 Microsoft iSCSI Initiator—>Targets—>选中target—>Logon—>OK, 建立连接 点击控制面板—>管理工具—>计算机管理—>磁盘管理,可以看见映射到本机的逻辑磁盘。然后可以与本地磁盘一样进行分区格式化操作。 点击 Microsoft iSCSI Initiator—>Targets—>选中已经连接的 target—>Details—>勾选相应的任务项目—>Logoff, 断开连接。 RedHat Enterpris Linux 5 编译安装软件 以root身份登录系统,下载initiator软件包Open-iscsi-2.0.865.tar.gz到/root目录。 [可以在它官网上下载:https://www.wendangku.net/doc/693560105.html,/] 解压缩软件 [root@RedHat5 ~]# tar xvzf Open-iscsi-2.0.865.tar.gz 在/root下生成目录Open-iscsi-2.0.86,进入该目录进行编译和安装 [root@RedHat5 ~]# cd Open-iscsi-2.0.86 [root@RedHat5 Open-iscsi-2.0.86]# make [root@RedHat5 Open-iscsi-2.0.86]# make install [root@RedHat5 Open-iscsi-2.0.86]# cd ~ 编译安装完成后生成必要的驱动程序模块、守护进程和管理程序iscsiadm 用法 启动Open-iscsi [root@RedHat5 ~]# service open-iscsi start 如果希望在启动机器时自动加载,执行下面命令 [root@RedHat5 ~]# chkconfig --level 3 open-iscsi on 这里的参数3是运行级别,如果是图形界面要改为5。 Windows系统下Initiator使用指导书 1 安装环境: 1.1 应用系统信息 操作系统版本:Windows XP, Windows 2000 Professional SP4; Windows 2000 Server SP4, Windows 2003 Server SP1 Initiator版本:MS iscsi initiator 2.0.8 2 Initiator安装过程 2.1 软件安装步骤 1、下载或拷贝MS initiator 2.0.8安装文件到windows 机器上 提示:MS initiator安装文件可以从Microsoft的网站上下载 提示:initiator的版本分X86, AMD64和IA64,使用与你的机器类型相匹配的版本 2、双击initiator 2.0.8安装文件,按提示操作即可,都用缺省选项。 3、重启机器 2.2 软件卸载步骤 1、Windows控制面板–>添加或删除程序 2、选中MS iSCSI Initiator,点击删除按钮 3、重启机器 2.3 软件配置过程 1.确认microsoft iscsi 服务已启动: 开始菜单->控制面板->管理工具->服务,在窗口的右栏中查看“Microsoft iSCSI Initiator Service”的状态是否显示“已启动”(一般该服务默认状态为启动)。若没有,则选中它并单击鼠标右键,选择“启动”,并将启动类型设为“自动”。 安装成功后产生程序组Microsoft iSCSI Initiator, 桌面也有相应图标。基本操作如下:点击 Microsoft iSCSI Initiator—>Discovery—>Add—>输入target的IP地址和端口号点击 Microsoft iSCSI Initiator—>Targets—>Refresh, 发现当前可用的Target 点击 Microsoft iSCSI Initiator—>Targets—>选中target—>Logon—>OK, 建立连接点击控制面板—>管理工具—>计算机管理—>磁盘管理,可以看见映射到本机的逻辑磁盘。然后可以与本地磁盘一样进行分区格式化操作。点击 Microsoft iSCSI Initiator —>Targets—>选中已经连接的target—>Details—>勾选相应的任务项目—>Logoff, 断开连接。 2.启动initiator配置工具: 开始菜单->控制面板,双击iSCSI Initiator图标,如下图: windows 2008+Oracle 10g R2 故障转移群集配置完整版 一. 故障转移群集环境介绍: 1.1 逻辑拓扑图 1.2 服务器A OS:win 2008 entprise sp1 ServerName:node1 Pubic_IP:192.168.200.1/24 DNS:192.168.200.1 Heartbeat_IP:10.10.10.10/24 1.2 服务器B OS:win 2008 entprise sp1 ServerName:node2 Public_IP:192.168.200.2/24 DNS:192.168.200.1 Heartbeat_IP:10.10.10.20/24 1.3 群集cluster DomainName:https://www.wendangku.net/doc/693560105.html, ClusterName:cluster Cluster_IP:192.168.200.3/24(属于群集的总IP,不是对应群集节点的公共IP) 二、准备工作: 2.1 服务器A、B网卡的设置 (1)网卡优先级:“Heartbeat”网卡置顶 (2)修改服务器A和B的“Heartbeat”网卡属性 2.2 分别在本地host文件添加各自的记录 (C:\windows\system32\drivers\etc\hosts) A: 192.168.200.2 node2 (node2对应填计算机名) 192.168.200.3 cluster 192.168.200.200 BackupServer B: 192.168.200.1 node1 (node1对应填计算机名) 192.168.200.3 cluster 192.168.200.200 BackupServer 2.3 A和B防火墙设置:把两片网卡勾去掉,不然彼此不能正常通信 1.如果Linux客户机没有安装iscsi-initiator的软件,要先来安装iscsi-initiator。这个软件在Linux系统光盘中的server目录下(linux版本不同,后面版本号不一样)。全部安装的时候也会安装上这个软件。 2.使用rpm -ivh来安装iscsi-initiator。 3.查看安装的iscsi-initiator的iqn号。“cat /etc/iscsi/initiatorname.iscsi” 4、建议重启一下iscsi服务service iscsi restart。 5.如果存储端没有把硬盘映射给此服务器,也就是没有资源发布出来,此时输入查寻target 的问题后没有报错,不过什么也找不到。 6.在linux中使用“iscsiadm -m discovery -t sendtargets -p 10.0.0.101”可以看到存储上面发布的target(10.0.0.101是lefthand的虚拟IP,如果是MSA2300i盘柜则是盘柜的iscsi口IP)。 7.使用“iscsiadm -m node -T https://www.wendangku.net/doc/693560105.html,.microsoft:hp-f700ce27cc14-wh-target -p 10.0.0.101:3260 -l”来登录lefthand发布的target. 需要注意的是这个命令每次重启后都要打,如果不希望每次都手动输入,那么需要用vi /etc/rc.local这个文件,把下图的命令添加到文件的最后一行,保存即可。 8、使用fdisk –l 能看到Linux客户端上又多了一个新的硬盘“sdb”。 注:-T参数是logon, -u参数是来logoff 可以使用“iscsiadm -m node -u https://www.wendangku.net/doc/693560105.html,.microsoft:hp-f700ce27cc14-wh-target” RHEL系统带有iSCSI initiator软件,下面描述如何配置iSCSI Initiator实现对ISCSI卷的访问1.Linux iscsi 介绍(这一条介绍了linux iscsi的基本原理和相关命令,具体配置时可略过) 在Linux内核中提供了iscsi驱动,iSCSI 驱动(driver)使主机拥有了通过IP网络访问存储的能力,驱动在主机(Initiator)和服务端(Target)间使用iSCSI协议在TCP/IP 网上传输SCSI请求和响应,在构建上,iSCSI驱动与TCP/IP栈、网络驱动和网络接口卡(NIC)结合,其等同于SCSI或光纤通道卡适配器驱动对主机总线卡(HBA)的作用。驱动采用采用模块的方式,具体模块包括iscsi_tcp, libiscsi, libiscsi_tcp。 Initiator守护进程介绍: /etc/iscsi/iscsid.conf --initiator配置文件 /sbin/iscsiadm --initiator管理工具 open-iscsi包括两个守护进程iscsid和iscsi,其中iscsid是主进程,iscsi进程则主要负责根据配置,在系统启动时进行发起端(Initiator)到服务端(target)的登录,建立发起端与服务端的会话,使主机在启动后即可使用通过iSCSI提供服务的存储设备。iscsid 进程实现iSCSI协议的控制路径以及相关管理功能。例如守护进程(指iscsid)可配置为在系统启动时基于持久化的iSCSI数据库内容,自动重新开始发现(discovery)目标设备。 Initiator配置介绍(前提是已经安装iSCSI initiator) 1> iSCSI initiator 名称设置 initiator名称用来唯一标识一个iSCSI Initiator端。保存此名称的配置文件为 /etc/iscsi/initiatorname.iscsi,命名规则可采用iqn-type格式,利用 iscsi-iname命令可产出一个名称,将此名称输入到initiatorname.iscsi配置文件即可。 2> iSCSI Initiator配置iSCSI Initiator的配置文件为/etc/iscsi/iscsid.conf,在iSCSI initiator 的scsid进程启动和执行iscsiadm命令时,将读取这个配置文件的内容,获取与SCSI目标进行交互的相关信息,主要的配置内容包括: CHAP Settings 组 本组下的各个设置项主要用来指定Initiator与target验证方式及相关信息 设置节点会话的验证模式 node.session.auth.authmethod = CHAP CHAR(Challenge Handshake Authentication Protocol ),默认为不验证(none) 设置会话target验证initiator的CHAR用户名及对应的密码 https://www.wendangku.net/doc/693560105.html,ername = scott node.session.auth.password = tiger 设置会话initiator验证target的用户名及其对应的密码 #https://www.wendangku.net/doc/693560105.html,ername_in = username_in #node.session.auth.password_in = password_in 设置initiator发现target的验证模式,默认为不验证(none) discovery.sendtargets.auth.authmethod = CHAP 实验报告 实验人:辛中强 实验名称:IP存储--iSCSI技术 实验目的:掌握在Linux、unix和windows平台中实现iSCIS 的initiator(发起端)和target(目标端)的方法。 实验过程: 根据这个拓扑结构我首先来做Linux下的iscsi的实现。我这里有两台Linux虚拟机,①发起端②目标端 不管在什么操作系统下做iSCIS实验,我们都要先从目标端开始着手。 好,我们首先在Linux下的target端安装两个关于target的包。 下面是iscsi-target的主配置文件存放的位置; 我们进入主配置文件后要将第28行复制一行然后再把第28行注销掉。在对第29行做如下修改。 其实上面的Lun不是随便写的,这是根据发起端上的利用IQN规则名称访问点到节点后,显示在Initiator主机中显示出这块可操作磁盘。(这有点类似于向主机中添加“物理”磁盘,只不过这些所谓的“物理”磁盘是存在在远程的target 端主机内部的一块或几块磁盘罢了) 这两块磁盘则分别对应于Target主机中的/dev/sdc1和/dev/sdc2设备。 完成后,启动服务:如果执行不成功请执行如下命令FATAL: Module iscsi_trgt not found. #mkdir /lib/modules/`uname -r`/kernel/iscsi #find / -name "iscsi_trgt.ko" #cp iscsi_trgt.ko /lib/modules/`uname -r`/kernel/iscsi #depmod -aq 然后,我在添加硬盘,划分分区sdc1、sdc2.其实你大可不用分区区,直接添加一块磁盘eg:sdb、sde等。不用划分区,因为我们在发起端早晚要重新划分分区的。 第五步:使新磁盘中的文件系统在系统启动时自动被挂载。 然后我们再在发起端安装软件: 我们安装完软件首先使用命令启动服务。 步骤二:检测Target端的可用接点。(如果用户应经清楚节点的具体名称,则可以跳过此步骤。) 后面跟的IP地址是目标端的IP地址。输入正确后,下面会出现节点名。Linux 挂载 iSCSI 存储

Linux服务器连接iSCSI存储配置文档

P实验—Windows下iSCSI多链路冗余实验

linux_配置ISCSI客户端(LINUX)

FreeNas发布共享存储的三种方法

Windows server 2012 存储管理

linux下连接iscsi存储

基于Linux后端的iSCSI配置与使用

linux下连接iscsi盘阵的方法

各种操作系统下iscsi存储设备挂载方法ip san架构

Windows系统下iscsi使用

(双机热备-windows)windows 2008+Oracle 10g(含补丁包) R2 故障转移群集配置完整版

linux下iscsi initiator的连接

linux多路径连接iScsi存储_重启自动连接

ip存储网络--iSCIS的实现

- linux下iscsi initiator的连接

- Linux下iscsi target配置全过程

- Redhat linux挂载IP-SAN(iSCSI)

- Linux 下iSCSI Target和Initiator安装与操作步骤详解

- IBM v3500存储linux环境下的iSCSI功能配置

- 基于Linux后端的iSCSI配置与使用

- Linux系统下实现iscsi挂载

- Linux配置iSCSI方法

- Linux环境下的HP P2000 G3 iscsi存储连接与存储挂载汇编

- linux_配置ISCSI客户端(LINUX)

- linux iscsi initiator 安装配置

- LINUX ISCSI Target 服务器搭建与windows 客户端连接

- ISCSI简介及linux下实现

- linux下配置iscsi多路径具体步骤

- LINUXISCSITarget服务器搭建与windows客户端连接

- Linux下iSCSI initiator的安装和设置

- linux下连接iscsi存储

- Windows和Linux下iSCSI客户端的使用

- Linux挂载存储及命令

- Linux下iscsi连接