集群服务器系统负载均衡原理的分析与实现

文章编号!"##$%&’($)*##$+#’%##,$%#$

集群服务器系统负载均衡原理的分析与实现

-

李长志

)涪陵师范学院计算机科学系.重庆$#,##/+

摘

要!随着计算机网络技术的不断发展和光纤技术的不断应用.线路传输速度得到了极大提高.这使得

服务器慢慢地成为网络中的瓶颈.集群技术正是解决这一问题的主要手段0通过对123系统的分析.讨论在14567环境下采用589:4;98<功能框架实现单一局域网络集群负载均衡的方法0关键词!集群服务器=单一局域局=负载均衡

中图分类号!>?/(/@#/文献标识码!A

B 引

言

在计算机硬件价格下降和计算机网络拓扑发展的情况下.

分布式计算机系统给用户提供了一个丰富的资源集合0人们在研究分布式系统时就注意到这样一个问题!在一个由网络连接起来的多计算机环境中.在某一时刻.一些计算机的负载过重.而另外一些计算机的负载较轻0平衡各计算机之间的负载是任务分配与调度的一个主要目标.它能够提高整个系统的性能0

为了改善系统的性能.通过在多台计算机之间合理地分配负载.使各台计算机的负载基本达到均衡.这种计算能力共享的形式通常被称为负载平衡或负载共享0

C D E 层负载均衡调度的解决方法

由于F ?G $中F ?地址空间的日益紧张和安全方面的原因.很多网络使用保留F ?地址)"#H #H #H #I *&&H #H #H #."J *H "’H #H #I *&&H "*,H #H #."(*H "’,H #H

#I *&&H *&&H #H #+K ’$.’&.’’L 0这些地址不在F 598<589上使用.而是专门为内部网络预留的0当内部网络的主机要访问F 598<589或被F 598<589访问时.就需要采用网络地址转换)M A >!589N O

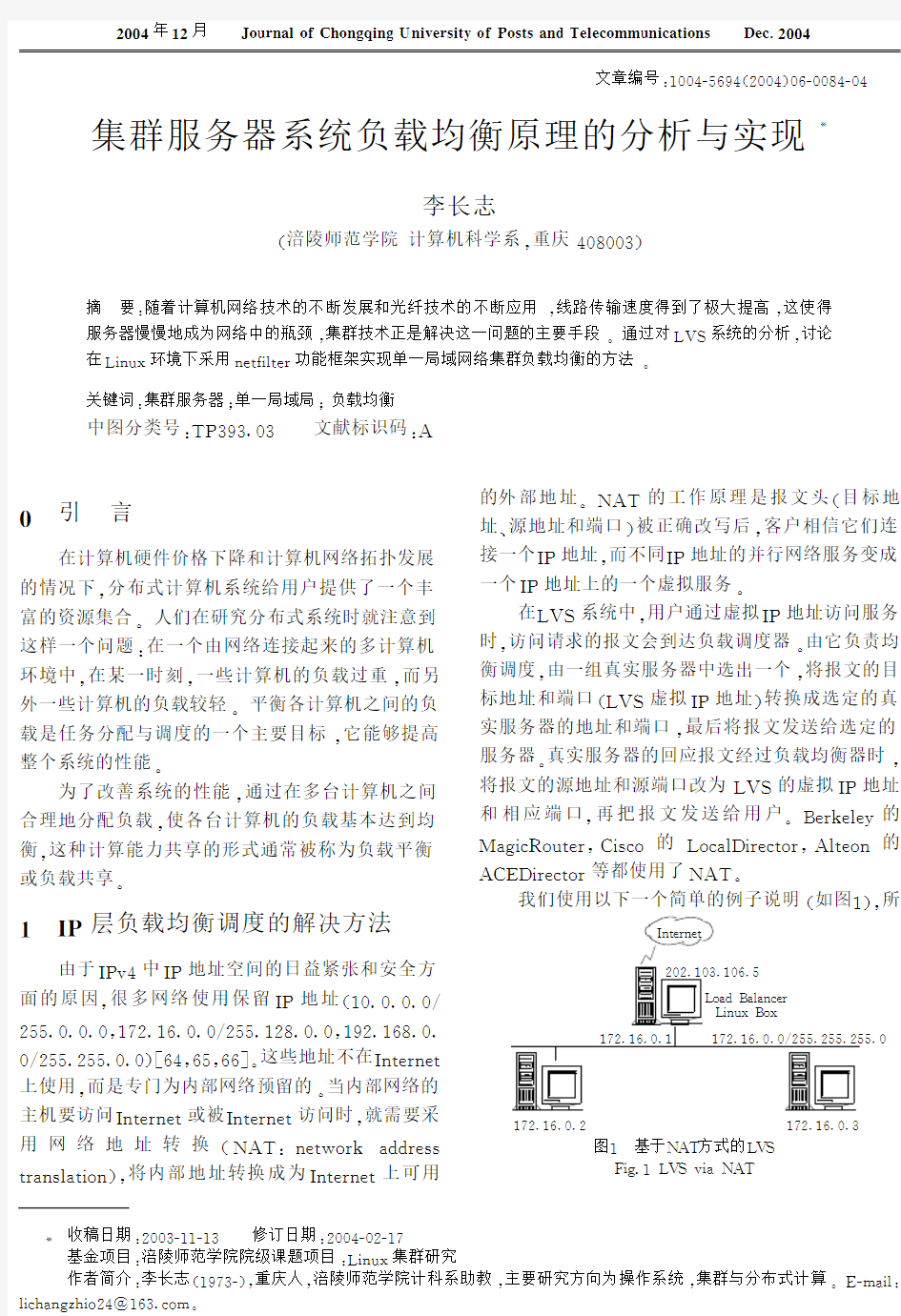

9 上可用的外部地址0M A >的工作原理是报文头)目标地址T 源地址和端口+被正确改写后.客户相信它们连接一个F ?地址.而不同F ?地址的并行网络服务变成一个F ?地址上的一个虚拟服务0 在123系统中.用户通过虚拟F ?地址访问服务时.访问请求的报文会到达负载调度器0由它负责均衡调度.由一组真实服务器中选出一个.将报文的目标地址和端口)123虚拟F ?地址+转换成选定的真实服务器的地址和端口.最后将报文发送给选定的服务器0真实服务器的回应报文经过负载均衡器时. 将报文的源地址和源端口改为123的虚拟F ?地址和相应端口.再把报文发送给用户0U 8 A []\4<8Y 9O < 等都使用了M A >0我们使用以下一个简单的例子说明)如图"+. 所图"基于M A >方式的123 ^4X H "123G 4QM A > F 598<589 1O Q RU Q ;Q 5Y 8< 14567U O 7 *#*H "#/H "#’H & "J *H "’H #H " "J *H "’H #H #I *&&H *&&H *&&H # "J *H "’H #H / "J *H "’H #H *第C _卷第_期重庆邮电学院学报 ‘a b H C _c a H _ d B B e 年C d 月 f a g h i j b a k l m a i n o p i n q i p r s h t p u va k E a t u t j i wx y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y y s b s z a {{g i p z j u p a i t |s z H d B B e - 收稿日期!*##/%""%"/修订日期!*##$%#*%"J 基金项目!涪陵师范学院院级课题项目!14567集群研究作者简介!李长志)"(J /%+.重庆人.涪陵师范学院计科系助教.主要研究方向为操作系统.集群与分布式计算0]%}Q 4; !;4Y ~Q 5X !~4O *$""’/H Y O }0 有到!"地址为#$#%&$’%&$(%)*+$的流量都被负载均衡器,-./01/2-/23456调度到真实服务器&7#%&(%$%#*+$和&7#%&(%$%’*+$$$上8目标地址为#$#%&$’%&$(%)*#&的报文被转移到&7#%&(%$%’*#&上9到其他端口的报文将被拒绝9 :负载调度器结构 ;<=负载调度器由以下’部分构成*!"包处理 模块>负载调度算法和系统配置和管理模块9:%?@A 包处理 包处理使用的就是;B 2C D #%E 内核的F 4G H B -G 45框架完成的I 一个数据包通过F 4G H B -G 45框架的过程如图#所示J J J J J K K K K K 9 图#F 4G H B -G 45F L M 包处理过程N B O %#F 4G H B -G 45F L M P /3Q 4G P 5.34R R 本地进程 S F L M F N T !"T ;U V L ;T ! F 输出包路由 =F L M F N T !"T N U W XL W S 进入包路由S F L M 在!"层代码中I 有一些带有Y N Z Y U U [宏的语 句I 如!"的转发函数中有* \T B P H .5].50%3B P T H .5]/50 ,6T^F N T Y U U [,P H T B 24G I F N T !"T N U W XL W S I R Q 1I R Q 1T ^04_I 04_#I B P T H .5]/50T H B 2B R ‘68a a 其中F N T Y U U [宏的定义基本如下*b Ta B 23-C 04a -B 2C D a 24G H B -G 45%‘Tc d B H 04H V U F N !e T F f M N !;M f W d 04H B 24F N T Y U U [,P H I ‘..Q I R Q 1I B 204_I .C G 04_I .Q H 2 6g ,-B R G T 4h P G i ,j 2H T ‘..Q k ,P H 6l k ,‘..Q 6lg m ,.Q H 26,R Q 16*2H T ‘..Q T R -.],,P H 6I ,‘..Q 6I ,R Q 16I ,B 204_6I ,.C G 04_6I ,.Q H 2 66d 4-R 4 d 04H B 24F N T Y U U [,P H I ‘..Q I R Q 1I B 204_I .C G 04_I .Q H 26,B .Q H 26,R Q 1 6d 420B H 如果在编译内核时没有配置24G H B -G 45时I 就相当于调用最后一个参数I 此例中即执行B P T H .5]/50T H B 2B R ‘函数8否则进入Y U U [点I 执行通过2H T 54O B R G 45T ‘..Q ,6登记的功能,即进入2H T ‘..Q T R -.],6函数I 再由它执行登记的函数69F N T Y U U [宏的参数都是在内核中定义好的I 具体解释在参考文献k &l 中有详细说明9对于检测点进行的处理是可以由用户自行指定的I F 4G H B -G 45的许多功能如*P /3Q 4G H B -G 45I F L M I 3.2243G B .2G 5/3Q 这些功能I 也是以这种方式提供的9正如F 4G H B -G 45当初的设计目标nn 提供一个完善灵活的框架I 为扩展功能提供方便9如果我们想加入自己的代码I 可以用2H T 54O B R G 45T ‘..Q 函数I 其函数原型为* B 2G 2H T 54O B R G 45T ‘..Q ,R G 5 C 3G 2H T ‘..Q T .P R o 54O 6R G 5C 3G 2H T ‘..Q T .P R 的结构如下R G 5C 3G 2H T ‘..Q T .P R p 2H T ‘..Q H 2o ‘..Q 8B 2G P H 8B 2G ‘..Q 2C h 8B 2G P 5B .5B G i 8q 8类似;<=的做法是生成一个R G 5C 3G 2H T ‘..Q T .P R 的实例I 并用F N T W f e !=M f W T Y U U [函数对其注册9其中的-B R G 项要初始化为,F r ;; I F r ;;68由于一般在!"层工作I P H 总是"N T ! F f M 8‘..Q 2C h 就是‘..Q 点I 一个‘..Q 点可以挂接多个处理函数I 其处理的顺序则由其优先级决定I F 4 G H B -G 45T ! P _E %‘中用一个枚举类型指定了内置的处理函数的优先级9‘..Q 指针是指提供的处理函数I 也就是我们的主要工作I 其原型为* C 2R B O 240B 2G 2H T ‘..Q H 2,C 2R B O 240B 2G ‘..Q 2C h 8 R G 5C 3G R Q T 1C H H o o R Q 183.2R G R G 5C 3G 24G T 04_B 34o B 283.2R G R G 5C 3G 24G T 04_B 34o .C G 8B 2G ,o .Q H 26,R G 5C 3G R Q T 1C H H o 668它的)个参数将由F N T Y U U [宏传进去9以上是F 4G H B -G 45编写自己模块的基本方法I ;<=处理的方式可以参见图’和表J J J J J K K K K K & 9图’;<=负载调度器程序结构N B O %’;<=-./01/2-/2345P /34Q 4G P 5.34R R 本地进程 Y U U [)Y U U [# 输出包路由 Y U U [E Y U U [’ 进入包路由Y U U [&表&钩子函数说明M /1%&Y ..QH C 23G B .2R ‘.] Y U U [&F N T !"T "W f T W U r M !F e Y U U [#F N T !"T ;U V L ;T !F Y U U [’F N T !"T N U W XL W S Y U U [E F N T !"T "U =M T W U r M !F e Y U U [) F N T !"T ;U V L ;T U r M ;<=将负载调度程序设计成;B 2C D 可加载模块 !"<=9模块的初始化函数B P T _R T B 2B G ,6注册了F N T s #s 重庆邮电学院学报,自然科学版6#$$E 年第(t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t t 期 !"#$%&’$#!()(*#!"#*%+,’+-)(*#!"#"%./#+%0/!(1钩子函数用于处理进出的数据包2 34356#789:7#; 5处理过程如果用户向虚拟服务器<=.>发起请求?数据包经过(*#$%&’$#!(@A %%B C D 由函数E F #G H #E I <>处理J 如果传入的是!&K"包?则调用E F #G H #E I # E L M F <>J 否则继续判断是不是N L F O E F 包?如果不是?钩子函数返回(*#’&&P "/<让内核继续处理该数据包>J 余下情况就是如何处理N L F O E F 包了2 首先?调用E F #G H #Q R S T R U #L Q R L V <>检查报头?如果异常?则函数返回(*#-+%"<丢弃该数据包>2而后?调用E F #G H #L W I I #E I #X R N <>去E F #G H #L W I I #N S Y 表中查找是否存在这样的联接Z 即它的客户机和虚拟服务器的!"地址和端口号以及协议类型均与数据包中的相应信息一致2 如果不存在相应的联接?则意味着联接尚未建立?此时如果数据包为/&"的.[(&报文或者0-"数据包?则查找相应的虚拟服务器J 如果相应虚拟服务器存在但是已经满负荷?则返回(*#-+%"J 如果相应服务器存在并且没有满负荷?那么调用E F #G H #H L Q R T \]R <>?调度一个+.并创建一个新的联接?如果调度失败?则调用E F #G H #]R S G R <>继续传递或者丢弃数据包2 如果存在相应联接?首先判断联接上的+.是否仍旧可用?如果不可用?则处理相关信息后返回(*#-+%" 2找到已存在的联接或者建立新的联接后?修改系统记录的相关信息?如传入的数据包的个数等2如果这个联接再创建时绑定了特定的数据包传输函数?调用这个函数传输数据包?否则返回(*#’&&P "/2 !F #G H #E I <>调用的函数E F #G H #H L Q R T \]R <>为虚拟服务器调度可用的+.并建立相应的联接2它将根据虚拟服务器绑定的调度算法分配一个+.?如果成功?则调用E F #G H #L W I I #I R ^<>建立联接2E F #G H #L W I I #I R ^<>将进行一系列的初始化操作Z 设置联接的协议)E F 地址)端口号?协议超时信息?绑定S F F ]E L S N E W IQ R ]F R U ?+.和数据包传输函数2最后调用E F #G H #L W I I #Y S L V <>将这个联接插入哈希表E F #G H #L W I I #N S Y 中2一个联接绑定的数据包传输函数依据!"=.工作方式可分为E F #G H #I S N #_M E N <>?E F #G H #N \I I R ]#_M E N <>?E F #G H #T U #_M E N <>2例如E F #G H #I S N #_ M E N <>的主要操作信息是Z 修改报文的目的地址和目的端口为+.信息?重新计算并设置校验和?调用E F #H R I T <> 发送修改后的数据包234‘56#;a #6 8b c:b d 处理过程数据包进入(*#!"#* %+,’+-@A %%B e D 后?将进入E F #G H #W \N <>进行处理2这个函数只在(’/方式下被调用2 它首先判断数据包类型?如果是!&K"包则直接调用E F #G H #W \N #E L M F <>J 其次判断是否为N L F O \T F 数据包?如果不是这二者?则返回(*#’&&P "/2余下的就是N L F O \T F 数据包的处理2 首先?调用E F #G H #Q R S T R U #L Q R L V <>检查报头?如果异常则返回(*#-+%"2其次?调用E F #G H #L W I I #W \N #X R N <>判断是否存在相应的联接2 如果不存在相应联接?调用E F #G H #]W W V \F # U R S ]#H R U G E L R <>去哈希表中查找发送数据包的+.是否仍然存在?如果+.存在且报文是/&"非复位报文或\T F 报文?则调用E L M F #H R I T <>给+.发送目的地不可达!&K"报文并返回(*#./%$P (J 其余情况均返回(*#’ &&P "/2若存在相应联接Z 检查数据包的校验和2如果错误?返回(*#-+%"?如果正确?修改数据包?将源地址修改为虚拟服务器E F 地址?源端口号修改为虚拟服务器端口号?重新计算校验和?并返回(*#’&&P "/2 E F #G H #W \N #E L M F <>的流程与E F #G H #E I #E L M F <>类似?只是修改数据报时有所区别Z E F 报头的源地址和差错信息中\T F 或N L F 报头的目的地址均修改为虚拟服务器地址?差错信息中\T F 或N L F 报头的目的端口号修改为虚拟服务器的端口号234f 56#;a #a 8g h #b 8i h ;5j 处理过程(*#!"#"%./#+%0/!(1钩子函数只在(’/方式下使用2 数据报进入(*#!"#"%./#+%0/!(1后?由E F #G H #F W H N #U W \N E I X <>进行处理2它首先判断数据报是否经过!"=.?如果未经过则返回(*#’&&P "/J 否则立刻传输数据报?函数返回(*# ./%$P (?防止数据报被E F N S Y ]R 的规则修改2‘7k g 系统配置与管理 !"=.模块初始化时注册了H R N H W L V W F N O X R N H W L V W F N <>2E F G H S T M 命令调用这两个函数向 !"=.内核模块传递E F #G H #U \]R #\ H R U 结构的系统配l e l 李长志Z m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m m 集群服务器系统负载均衡原理的分析与实现 置数据!完成系统的配置!实现虚拟服务器和"#地址的添加$ 修改$删除操作%系统通过这些操作完成对虚拟服务器和"#链表的管理% 虚拟服务器的添加操作由&’()*(+,,(*-.)&/-01 完成!该函数根据哈希算法向虚拟服务器哈希表添加一个新的节点!查找用户设定的调度算法并将此算法绑定到该节点2虚拟服务器的修改由&’()*( -,&3(*-.)&/-01完成!此函数修改指定服务器的调度算法2虚拟服务器的删除由&’()*(,-4(*-.)&/-01完成!在删除一个虚拟服务器之前!必须先删除此虚拟服务器所带的所有"# !并解除虚拟服务器所绑定的调度算法%与之类似!"#的添加$修改$删除操作分别由&’()*(+,,(,-*301!&’()*(-,&3(,-*301和&’()*(-,&3(* -.)-.01完成%5负载均衡调度算法和服务器状态检测 前面已经提到!用户在添加一个虚拟服务时要绑定调度算法!这由&’()*(6&7,(* /8-,94-.01完成!调度算法的查找则由&’()*(*/8-,94-.(:-301完成%&’()*(*/8-,94-.(: -301根据调度算法的名字!调用&’()*(*/8-,(:-36;7+<-01从调度算法队列中查找此调度算法! 如果没找到则加载相应调度算法模块再查找!最后返回查找结果%目前系统有八种负载均衡调度算法!具体的算法这里不再叙述负载调度算法需要动态地获取每台"#的状态!服务器状态检测包括服务器状态信息的获取和聚集!在信息获取程序中!我们可以建立一个数据结构来保存这些信息0包括设备=>!?>@!内存使用情况和其他与进程运行状态相关的信息1!这些信息可以通过读取A &79B 中的C ’.D / 文件系统中的文件来完成%信息聚集程序可以利用获取的所有真实服务器的状态信息形成一个状态链表!依次向负载算法程序提供调度算法程序所需的参数% E 结束语 在研究以F -3G &43-.框架为基础的A H #负载调度器的同时!作者本人对集群系统的其他关键技术如进程迁移也做更进一步的了解!并使用I 台>J 系列的>?机和"-,8+3K L M 实现了一个简单的以A H #为基础的N-6服务器%在F O P 方式下工作的A H #系统对运行A H #负载调度器的机器的稳定性要求很高!并不能完全达到集群系统所要求的高可靠性的要求!A H #系统的其他两种工作方式=>隧道和直接路由技术在一定程度上解决了A H #负载调度器的负担%除了A H #以外!其他许多的集群产品也已经越来越多的被应用在服务器领域%虽然对于大多数的人而言!基于4&79B 的集群系统配置仍然较为复杂!且存在安全问题!但其高可用性及灵活的伸缩性! 尤其是它的性价比使它可以在今后的西部信息网络建设中扮演非常重要的角色%参考文献Q R S T 博加科技L A &79B 防火墙技术探密R U T L 北京Q 国防工业出版社!M V V M L R M T 陈莉君L 深入分析A &79B 内核源代码R U T L 北京Q 人民邮电出版社!M V V M L R I T 许广斌L 基于A &79B 集群系统R W X C Y A T L 833’Q C C ,-)-4D ’-.L Z D .[* L R \T 章文嵩L A &79B 集群服务器系统R W X C Y A TL 833’Q C C ,-)-4D ’-.ND .[* L R ]T 武威!朱春梅L 下一代网络业务提供中的关键问题R ^ T L 重庆邮电学院学报0自然科学版1!M V V I !S ]0S 1Q K K _‘S L R a T 杨朝军!李世畅!陶洋L A &79B 嵌入式系统的优 化R ^ T L 重庆邮电学院学报0自然科学版1!M V V M !S \0\1Q a S _a \L 编辑Q 龙能芬1b c d e f g h g d c ii j g h k cl m e l d in d e d c o j h cg j p q j p o e r g s j p A =?8+7:_t 8& 0u v w x L y z{y |w }x v ~!{"v #{v !$}%"#&’y ~|(%)y %%v &v !)*y #&+"#&\V ‘V V I !,L -L )*"#( 1b n g s p d o s Q N&38/D 73&79D 9*,-)-4D ’<-73D G 7-3Z D .[3-/87D 4D :;+7,’-.G D .<+7/-&<’.D )-<-73D G ,&:&3+4G &6-._D ’3&/3.+7*<&**&D 7!*-.)-.&*6-/D <&7:+64D /[+:-3D 38-7-3Z D .[!*D /49*3-.&*+.-4-)+73*D 493&D 73D 38&*L =738&*’+’-.38-<-38D ,3D &<’4-<-7397&_,D <+&77-3Z D .[*-.)-./49*3-.4D +,6+4+7/-97,-.4&79BZ &387-3G &43-.&*,&*/9**-,)&++7+4;t &7:38-A H #L .j f /l p i g Q *-.)-./49*3-.2*&7:4-4D /+47-3Z D .[24D +,6+4+7/- \0重庆邮电学院学报0自然科学版1M V V \年第a 1 111111111111111111111111111111111111111111111111111111111111111111期 广域网负载均衡 多链路广域网负载均衡 (1)Inbound多链路负载均衡算法策略:RTT+Topology+RoundRobin 具体描述: 当外部用户访问九州梦网网站时,首先由F5的3DNS对客户端的LDNS进行RTT(Round Trip Time)探测,对比从两条链路返回的探测结果(可以从统计列表中看到),选择一条返回值小的链路IP地址返回给客户端,从而客户端再发起访问请求;当F5的3DNS探测不到客户端的LDNS(由于LDNS安全防护等原因)时,F5的3DNS自动启用Topology算法,来静态匹配客户端的LDNS地理位置,从而根据客户端的来源,返回正确的A记录;当探测不到的LDNS又不在地址列表中时,F5 3DNS自动启用Global Availability 算法作为默认算法,将所有无法计算结果并且不在Topology范围之内的LocalDNS请求,定义到系统的默认线路上。 F5 的3DNS具备二十多种Inbound算法,可以根据需要进行组合。 ①RTT算法运行机制: 通过3DNS的RTT就近性算法会自动运算生成一个ldns就近分布表,通过这个动态的表,每个客户上来都会提供一个最快速的链路进行访问,由于站点有ISP1和ISP2的两条广域网线路。在3DNS上会针对站点服务器(以https://www.wendangku.net/doc/802171390.html, 为例)解析ISP1和ISP2的两个不同的公网地址。 对应于https://www.wendangku.net/doc/802171390.html,域名,在3DNS上配置wideip:https://www.wendangku.net/doc/802171390.html,,对应两个Virtual Server:VS1:202.106.83.177,VS2:219.17.66.100。分别属于ISP1和ISP2两条线路分配的IP地址段。在3DNS内部,同时定义两个DataCenter分别与ISP1和ISP2相对应。 用户的访问流程如下: 实用标准文案 NLB 、HA、HPC集群、双机、负载均衡、 1.1什么是集群)就是一组计算机,它们作为一个整体向用户cluster 简单的说,集群()。一提供一组网络资源。这些单个的计算机系统就是集群的节点(node她们看/个理想的集群是,用户从来不会意识到集群系统底层的节点,在他来,集群是一个系统,而非多个计算机系统。并且集群系统的管理员可以随意增加和删改集群系统的节点。集群系统的主要优点:1.2 高可扩展性:(1):集群中的一个节点失效,它的任务可传递给其他节点。可高可用性HA(2) 以有效防止单点失效。 高性能:负载平衡集群允许系统同时接入更多的用户。(3) 高性价比:可以采用廉价的符合工业标准的硬件构造高性能的系统。(4) 集群系统的分类2.1 虽然,根据集群系统的不同特征可以有多种分类方法,但是一般把集群系统 分为两类:集群。,、高可用(High Availability)集群简称HA(1) 这类集群致力于提供高度可靠的服务。就是利用集群系统的容错性对外提供 小时不间断的服务,如高可用的文件服务器、数据库服务等关键应用。7*24负载均衡集群:使任务可以在集群中尽可能平均地分摊不同的计算机进行处 精彩文档. 实用标准文案 理,充分利用集群的处理能力,提高对任务的处理效率。以提供更加高效稳 定的服务。在实际应用中这几种集群类型可能会混合使用, 高就会包含高可用的网络文件系统、如在一个使用的网络流量负载均衡集群中,可用的网络服务。集群,也HPC(High Perfermance Computing)集群,简称(2)、性能计算称为科学计算集群。 在这种集群上运行的是专门开发的并行应用程序,它可以把一个问题的数据 从而可以分布到多台的计算机上,利用这些计算机的共同资源来完成计算任务,解决单机不能胜任的工作(如问题规模太大,单机计算速度太慢)。 如天气预报、这类集群致力于提供单个计算机所不能提供的强大的计算能力。石油勘探与油藏模拟、分子模拟、生物计算等。(HA) 3.1 什么是高可用性和可维护(reliability)计算机系统的可用性(availability)是通过系统的可靠性 来度量系统(MTTF)来度量的。工程上通常用平均无故障时间性(maintainability)于是可用性被定义)来度量系统的可维护性。,用平均维修时间(MTTR的可靠性MTTF/ (MTTF+MTTR)*100% 为:负载均衡服务器的高可用性主服务器和备份机上都需要建立一个备份机。为了屏蔽负载均衡服务器的失效,”这样的信息来监I am alive监控程序,通过传送诸如“运行High Availability它就接管当备份机不能在一定的时间内收到这样的信息时,控对方的运行状况。I am 并继续提供服务;当备份管理器又从主管理器收到“主服务器的服务IP精彩文档.实用标准文案 地址,这样的主管理器就开开始再次进IPalive”这样的信息是,它就释放服务行集群管理的工作了。为在主服务器失效的情况下系统能正常工作,我们在主、备份机之间实现负载集群系统配置信息的同步与备份,保持二者系统的基本一 F5 Application Management Products 服务器负载均衡原理 F5 Networks Inc 1.服务器负载平衡市场需求 (3) 2.负载平衡典型流程 (4) 2..1 通过VIP来截获合适的需要负载平衡的流量 (4) 2.2 服务器的健康监控和检查 (5) 2.3 负载均衡和应用交换功能,通过各种策略导向到合适的服务器 (6) 1.服务器负载平衡市场需求 随着Internet的普及以及电子商务、电子政务的发展,越来越多的应用系统需要面对更高的访问量和数据量。同时,企业对在线系统的依赖也越来越高,大量的关键应用需要系统有足够的在线率及高效率。这些要求使得单一的网络服务设备已经不能满足这些需要,由此需要引入服务器的负载平衡,实现客户端同时访问多台同时工作的服务器,一则避免服务器的单点故障,再则提高在线系统的服务处理能力。从业界环境来说,如下的应用需求更是负载均衡发展的推动力: ?业务系统从Client-Server转向采用Browser-Server 系统结构,关键系统需要高可用性 ?电子商务系统的高可用性和高可靠性需要 ?IT应用系统大集中的需要(税务大集中,证券大集中,银行大集中) ?数据中心降低成本,提高效率 负载均衡技术在现有网络结构之上提供了一种廉价、有效、透明的方法,来扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性。它有两方面的含义:首先,大量的并发访问或数据流量分担到多台节点设备上分别处理,减少用户等待响应的时间;其次,单个重负载的运算分担到多台节点设备上做并行处理,每个节点设备处理结束后,将结果汇总,返回给用户,系统处理能力得到大幅度提高。 BIG/IP利用定义在其上面的虚拟IP地址来为用户的一个或多个应用服务器提供服务。因此,它能够为大量的基于TCP/IP的网络应用提供服务器负载均衡服务。BIG/IP 连续地对目标服务器进行L4到L7合理性检查,当用户通过VIP请求目标服务器服务时,BIG/IP根椐目标服务器之间性能和网络健康情况,选择性能最佳的服务器响应用户的请求。 下图描述了一个负载平衡发生的流程: Tomcat集群与负载均衡(转载) 在单一的服务器上执行WEB应用程序有一些重大的问题,当网站成功建成并开始接受大量请求时,单一服务器终究无法满足需要处理的负荷量,所以就有点显得有点力不从心了。另外一个常见的问题是会产生单点故障,如果该服务器坏掉,那么网站就立刻无法运作了。不论是因为要有较佳的扩充性还是容错能力,我们都会想在一台以上的服务器计算机上执行WEB应用程序。所以,这时候我们就需要用到集群这一门技术了。 在进入集群系统架构探讨之前,先定义一些专门术语: 1. 集群(Cluster):是一组独立的计算机系统构成一个松耦合的多处理器系统,它们之间通过网络实现进程间的通信。应用程序可以通过网络共享内存进行消息传送,实现分布式计算机。 2. 负载均衡(Load Balance):先得从集群讲起,集群就是一组连在一起的计算机,从外部看它是一个系统,各节点可以是不同的操作系统或不同硬件构成的计算机。如一个提供Web服务的集群,对外界来看是一个大Web服务器。不过集群的节点也可以单独提供服务。 3. 特点:在现有网络结构之上,负载均衡提供了一种廉价有效的方法扩展服务器带宽和增加吞吐量,加强网络数据处理能力,提高网络的灵活性和可用性。集群系统(Cluster)主要解决下面几个问题: 高可靠性(HA):利用集群管理软件,当主服务器故障时,备份服务器能够自动接管主服务器的工作,并及时切换过去,以实现对用户的不间断服务。 高性能计算(HP):即充分利用集群中的每一台计算机的资源,实现复杂运算的并行处理,通常用于科学计算领域,比如基因分析,化学分析等。 负载平衡:即把负载压力根据某种算法合理分配到集群中的每一台计算机上,以减轻主服务器的压力,降低对主服务器的硬件和软件要求。 目前比较常用的负载均衡技术主要有: 1. 基于DNS的负载均衡 通过DNS服务中的随机名字解析来实现负载均衡,在DNS服务器中,可以为多个不同的地址配置同一个名字,而最终查询这个名字的客户机将在解析这个名字时得到其中一个地址。因此,对于同一个名字,不同的客户机会得到不同的地址,他们也就访问不同地址上的Web服务器,从而达到负载均衡的目的。 2. 反向代理负载均衡(如Apache+JK2+Tomcat这种组合) 使用代理服务器可以将请求转发给内部的Web服务器,让代理服务器将请求均匀地转发给多台内部Web服务器之一上,从而达到负载均衡的目的。这种代理方式与普通的代理方式有所不同,标准代理方式是客户使用代理访问多个外部Web服务器,而这种代理方式是多个客户使用它访问内部Web服务器,因此也被称为反向代理模式。 3. 基于NAT(Network Address Translation)的负载均衡技术(如Linux Virtual Server,简称LVS) 大家都知道一台服务器的处理能力,主要受限于服务器自身的可扩展硬件能力。所以,在需要处理大量用户请求的时候,通常都会引入负载均衡器,将多台普通服务器组成一个系统,来完成高并发的请求处理任务。 之前负载均衡只能通过DNS来实现,1996年之后,出现了新的网络负载均衡技术。通过设置虚拟服务地址(IP),将位于同一地域(Region)的多台服务器虚拟成一个高性能、高可用的应用服务池;再根据应用指定的方式,将来自客户端的网络请求分发到 服务器池中。网络负载均衡会检查服务器池中后端服务器的健康状态,自动隔离异常状态的后端服务器,从而解决了单台后端服务器的单点问题,同时提高了应用的整体服务能力。 网络负载均衡主要有硬件与软件两种实现方式,主流负载均衡解决方案中,硬件厂商以F5为代表目前市场占有率超过50%,软件主要为NGINX与LVS。但是,无论硬件或软件实现,都逃不出基于四层交互技术的“转发”或基于七层协议的“代理”这两种方式。四层的转发模式通常性能会更好,但七层的代理模式可以根据更多的信息做到更智能地分发流量。一般大规模应用中,这两种方式会同时存在。 2007年F5提出了ADC(Application delivery controller)的概念为传统的负载均衡器增加了大量的功能,常用的有:SSL卸载、压缩优化和TCP连接优化。NGINX也支持很多ADC的特性,但F5的中高端型号会通过硬件加速卡来实现SSL卸载、压缩优化这一类CPU密集型的操作,从而可以提供更好的性能。 F5推出ADC以后,各种各样的功能有很多,但其实我们最常用的也就几种。这里我也简单的总结了一下,并和LVS、Nginx对比了一下。 双节点数据库负载均衡解决方案 问题的提出? 在SQL Server数据库平台上,企业的数据库系统存在的形式主要有单机模式和集群模式(为了保证数据库的可用性或实现备份)如:失败转移集群(MSCS)、镜像(Mirror)、第三方的高可用(HA)集群或备份软件等。伴随着企业的发展,企业的数据量和访问量也会迅猛增加,此时数据库就会面临很大的负载和压力,意味着数据库会成为整个信息系统的瓶颈。这些“集群”技术能解决这类问题吗?SQL Server数据库上传统的集群技术 Microsoft Cluster Server(MSCS) 相对于单点来说Microsoft Cluster Server(MSCS)是一个可以提升可用性的技术,属于高可用集群,Microsoft称之为失败转移集群。 MSCS 从硬件连接上看,很像Oracle的RAC,两个节点,通过网络连接,共享磁盘;事实上SQL Server 数据库只运行在一个节点上,当出现故障时,另一个节点只是作为这个节点的备份; 因为始终只有一个节点在运行,在性能上也得不到提升,系统也就不具备扩展的能力。当现有的服务器不能满足应用的负载时只能更换更高配置的服务器。 Mirror 镜像是SQL Server 2005中的一个主要特点,目的是为了提高可用性,和MSCS相比,用户实现数据库的高可用更容易了,不需要共享磁盘柜,也不受地域的限制。共设了三个服务器,第一是工作数据库(Principal Datebase),第二个是镜像数据库(Mirror),第三个是监视服务器(Witness Server,在可用性方面有了一些保证,但仍然是单服务器工作;在扩展和性能的提升上依旧没有什么帮助。 F5负载均衡原理 一负载均衡基本概念 1、什么是负载均衡? 负载均衡技术在现有网络结构之上提供了一种廉价、有效、透明的方法,来扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性。它有两方面的含义:首先,大量的并发访问或数据流量分担到多台节点设备上分别处理,减少用户等待响应的时间;其次,单个重负载的运算分担到多台节点设备上做并行处理,每个节点设备处理结束后,将结果汇总,返回给用户,系统处理能力得到大幅度提高。 BIG/IP利用定义在其上面的虚拟IP地址来为用户的一个或多个应用服务器提供服务。因此,它能够为大量的基于TCP/IP的网络应用提供服务器负载均衡服务。BIG/IP 连续地对目标服务器进行L4到L7合理性检查,当用户通过VIP请求目标服务器服务时,BIG/IP根椐目标服务器之间性能和网络健康情况,选择性能最佳的服务器响应用户的请求。 下图描述了一个负载平衡发生的流程: 1. 客户发出服务请求到VIP 2. BIGIP接收到请求,将数据包中目的IP地址改为选中的后台服务器IP地址,然后将数据包发出到后台选定的服务器 3. 后台服务器收到后,将应答包按照其路由发回到BIGIP 4. BIGIP收到应答包后将其中的源地址改回成VIP的地址,发回客户端,由此就完成了一个标准的服务器负载平衡的流程。 2.负载平衡典型流程 ●通过VIP来截获合适的需要负载平衡的流量 ●服务器监控和健康检查,随时了解服务器群的可用性状态 ●负载均衡和应用交换功能,通过各种策略导向到合适的服务器 2.1 通过VIP来截获合适的需要负载平衡的流量 在BIGIP上通过设置VIP来截获需要进行负载平衡的流量,这个VIP地址可以是一个独立的主机地址和端口的组合(例如:202.101.112.115:80)也可以是一个网络地址和端口的组合(例如:202.101.112.0:80),当流量经过BIGIP的时候,凡是命中VIP 的流量都将被截获并按照规则进行负载平衡。 2.2 服务器的健康监控和检查 服务器 (Node) - Ping (ICMP) BIGIP可以定期的通过ICMP包对后台服务器的IP地址进行检测,如果在设定的时间内能收到该地址的ICMP的回应,则认为该服务器能提供服务 服务 (Port) – Connect BIGIP可以定期的通过TCP包对后台服务器的服务端口进行检测,如果在设定的时间内能收到该服务器端口的回应,则认为该服务器能提供服务 扩展内容查证(ECV: Extended Content Verification)—ECV ECV是一种非常复杂的服务检查,主要用于确认应用程序能否对请求返回对应的数据。如果一个应用对该服务检查作出响应并返回对应的数据,则BIG/IP控制器将该服务器标识为工作良好。如果服务器不能返回相应的数据,则将该服务器标识为宕机。宕机一旦修复,BIG/IP就会自动查证应用已能对客户请求作出正确响应并恢复向该服务器传送。该功能使BIG/IP可以将保护延伸到后端应用如Web内容及数据库。BIG/ip的ECV 功能允许您向Web服务器、防火墙、缓存服务器、代理服务器和其它透明设备发送查询,然后检查返回的响应。这将有助于确认您为客户提供的内容正是其所需要的。 扩展应用查证(EAV: Extended Application Verification) EAV是另一种服务检查,用于确认运行在某个服务器上的应用能否对客户请求作出响应。为完成这种检查,BIG/IP控制器使用一个被称作外部服务检查者的客户程序,该程序为BIG/IP提供完全客户化的服务检查功能,但它位于BIG/IP控制器的外部。例如,该外部服务检查者可以查证一个Internet或Intranet上的从后台数据库中取出数据并在HTML网页上显示的应用能否正常工作。EAV是BIG/IP提供的非常独特的功能,它提供管理者将BIG/IP客户化后访问各种各样应用的能力,该功能使BIG/IP在提供标准的可用性查证之外能获得服务器、应用及内容可用性等最重要的反馈。 集群的负载均衡技术综述 摘要:当今世界,无论在机构内部的局域网还是在广域网如Internet上,信息处理量的增长都远远超出了过去最乐观的估计,即使按照当时最优配置建设的网络,也很快会感到吃不消。如何在完成同样功能的多个网络设备之间实现合理的业务量分配,使之不致于出现一台设备过忙、而别的设备却未充分发挥处理能力的情况,负载均衡机制因此应运而生。本组在课堂上讲解了《集群监控与调度》这一课题,本人在小组内负责负载均衡部分内容,以及PPT的制作。 关键词:负载均衡集群网络计算机 一、前言 负载均衡建立在现有网络结构之上,它提供了一种廉价有效的方法扩展服务器带宽和增加吞吐量,加强网络数据处理能力,提高网络的灵活性和可用性。它主要完成以下任务:解决网络拥塞问题,服务就近提供,实现地理位置无关性;为用户提供更好的访问质量;提高服务器响应速度;提高服务器及其他资源的利用效率;避免了网络关键部位出现单点失效。 其实,负载均衡并非传统意义上的“均衡”,一般来说,它只是把有可能拥塞于一个地方的负载交给多个地方分担。如果将其改称为“负载分担”,也许更好懂一些。说得通俗一点,负载均衡在网络中的作用就像轮流值日制度,把任务分给大家来完成,以免让一个人累死累活。不过,这种意义上的均衡一般是静态的,也就是事先确定的“轮值”策略。 与轮流值日制度不同的是,动态负载均衡通过一些工具实时地分析数据包,掌握网络中的数据流量状况,把任务合理分配出去。结构上分为本地负载均衡和地域负载均衡(全局负载均衡),前一种是指对本地的服务器集群做负载均衡,后一种是指对分别放置在不同的地理位置、在不同的网络及服务器群集之间作负载均衡。 服务器群集中每个服务结点运行一个所需服务器程序的独立拷贝,诸如Web、FTP、Telnet或e-mail服务器程序。对于某些服务(如运行在Web服务器上的那些服务)而言,程序的一个拷贝运行在群集内所有的主机上,而网络负载均衡则将工作负载在这些主机间进行分配。对于其他服务(例如e-mail),只有一台主机处理工作负载,针对这些服务,网络负载均衡允许网络通讯量流到一个主机上,并在该主机发生故障时将通讯量移至其他主机。 二、负载均衡技术实现结构 在现有网络结构之上,负载均衡提供了一种廉价有效的方法扩展服务器带宽和增加吞吐量,加强网络数据处理能力,提高网络的灵活性和可用性。它主要完成以下任务: 1.解决网络拥塞问题,服务就近提供,实现地理位置无关性 2.为用户提供更好的访问质量 3.提高服务器响应速度 负载均衡器部署方式和工作原理 2011/12/16 小柯信息安全 在现阶段企业网中,只要部署WEB应用防火墙,一般能够遇到负载均衡设备,较常见是f5、redware的负载均衡,在负载均衡方面f5、redware的确做得很不错,但是对于我们安全厂家来说,有时候带来了一些小麻烦。昨日的一次割接中,就遇到了国内厂家华夏创新的负载均衡设备,导致昨日割接失败。 在本篇博客中,主要对负载均衡设备做一个介绍,针对其部署方式和工作原理进行总结。 概述 负载均衡(Load Balance) 由于目前现有网络的各个核心部分随着业务量的提高,访问量和数据流量的快速增长,其处理能力和计算强度也相应地增大,使得单一的服务器设备根本无法承担。在此情况下,如果扔掉现有设备去做大量的硬件升级,这样将造成现有资源的浪费,而且如果再面临下一次业务量的提升时,这又将导致再一次硬件升级的高额成本投入,甚至性能再卓越的设备也不能满足当前业务量增长的需求。 负载均衡实现方式分类 1:软件负载均衡技术 该技术适用于一些中小型网站系统,可以满足一般的均衡负载需求。软件负载均衡技术是在一个或多个交互的网络系统中的多台服务器上安装一个或多个相应的负载均衡软件来实现的一种均衡负载技术。软件可以很方便的安装在服务器上,并且实现一定的均衡负载功能。软件负载均衡技术配置简单、操作也方便,最重要的是成本很低。 2:硬件负载均衡技术 由于硬件负载均衡技术需要额外的增加负载均衡器,成本比较高,所以适用于流量高的大型网站系统。不过在现在较有规模的企业网、政府网站,一般来说都会部署有硬件负载均衡设备(原因1.硬件设备更稳定,2.也是合规性达标的目的)硬件负载均衡技术是在多台服务器间安装相应的负载均衡设备,也就是负载均衡器来完成均衡负载技术,与软件负载均衡技术相比,能达到更好的负载均衡效果。 3:本地负载均衡技术 1、Linux集群主要分成三大类( 高可用集群,负载均衡集群,科学计算集群)(下面只介绍负载均衡集群) 负载均衡集群(Load Balance Cluster) 负载均衡系统:集群中所有的节点都处于活动状态,它们分摊系统的工作负载。一般Web服务器集群、数据库集群和应用服务器集群都属于这种类型。 负载均衡集群一般用于相应网络请求的网页服务器,数据库服务器。这种集群可以在接到请求时,检查接受请求较少,不繁忙的服务器,并把请求转到这些服务器上。从检查其他服务器状态这一点上看,负载均衡和容错集群很接近,不同之处是数量上更多。 2、负载均衡系统:负载均衡又有DNS负载均衡(比较常用)、IP负载均衡、反向代理负载均衡等,也就是在集群中有服务器A、B、C,它们都是互不影响,互不相干的,任何一台的机器宕了,都不会影响其他机器的运行,当用户来一个请求,有负载均衡器的算法决定由哪台机器来处理,假如你的算法是采用round算法,有用户a、b、c,那么分别由服务器A、B、C来处理; 3、分布式是指将不同的业务分布在不同的地方。 而集群指的是将几台服务器集中在一起,实现同一业务。 分布式中的每一个节点,都可以做集群。 而集群并不一定就是分布式的。 举例:就比如新浪网,访问的人多了,他可以做一个群集,前面放一个响应服务器,后面几台服务器完成同一业务,如果有业务访问的时候,响应服务器看哪台服务器的负载不是很重,就将给哪一台去完成。 而分布式,从窄意上理解,也跟集群差不多,但是它的组织比较松散,不像集群,有一个组织性,一台服务器垮了,其它的服务器可以顶上来。 分布式的每一个节点,都完成不同的业务,一个节点垮了,哪这个业务就不可访问了。 服务器集群方案 LVS项目简介 LVS--Linux Virtual Server(Linux虚拟服务器)。针对高可伸缩、高可用网络服务的需求,LVS采用了基于IP层和基于内容请求分发的负载平衡调度解决方法,并在Linux内核中实现了这些方法,将一组服务器构成一个实现可伸缩的、高可用网络服务的虚拟服务器。一组服务器通过高速的局域网或者地理分布的广域网相互连接,在它们的前端有一个负载调度器。负载调度器能无缝地将网络请求调度到真实服务器上,从而使得服务器集群的结构对客户是透明的,客户访问集群系统提供的网络服务就像访问一台高性能、高可用的服务器一样。客户程序不受服务器集群的影响不需作任何修改。系统的伸缩性通过在服务机群中透明地加入和删除一个节点来达到,通过检测节点或服务进程故障和正确地重置系统达到高可用性。二、IP虚拟服务器软件IPVS 在调度器的实现技术中,IP负载均衡技术是效率最高的。在已有的IP负载均衡技术中有通过网络地址转换(Network Address Translation)将一组服务器构成一个高性能的、高可用的虚拟服务器,称之为VS/NAT技术(Virtual Server via Network Address Translation),大多数商品化的IP负载均衡调度器产品都是使用此方法,如Cisco的LocalDirector、F5的Big/IP和 Alteon的ACEDirector。在分析VS/NAT的缺点和网络服务的非对称性的基础上,LVS提供通过IP隧道实现虚拟服务器的方法VS/TUN (Virtual Server via IP Tunneling),和通过直接路由实现虚拟服务器的方法VS/DR (Virtual Server via Direct Routing),它们可以极大地提高系统的伸缩性。所以,IPVS软件实现了这三种IP负载均衡技术,它们的大致原理如下: 1、Virtual Server via Network Address Translation(VS/NAT)通过网络地址转换,调度器重写请求报文的目标地址,根据预设的调度算法,将请求分派给后端的真实服务器;真实服务器的响应报文通过调度器时,报文的源地址被重写,再返回给客户,完成整个负载调度过程。 2、Virtual Server via IP Tunneling(VS/TUN)采用NAT技术时,由于请求和响应报文都必须经过调度器地址重写,当客户请求越来越多时,调度器的处理能力将成为瓶颈。为了解决这个问题,调度器把请求报文通过IP隧道转发至真实服务器,而真实服务器将响应直接返回给客户,所以调度器只处理请求报文。由于一般网络服务应答比请求报文大许多,采用 VS/TUN技术后,集群系统的最大吞吐量可以提高10倍。 用双机高可用集群还是使用负载均衡集群 北京麒麟博峰科技有限公司 2010年11月 1 目录 第一章问题描述 (1) 第二章基本的技术知识 (1) 2.1.HA高可用集群 (1) 2.2.Load Balance负载均衡集群 (2) 第三章该使用哪种集群 (3) I 第一章问题描述 系统工程师通常会对如何使用HA高可用集群,即“双机”,和负载均衡集群,比如KYLIN Netsphere等负载均衡设备,产生疑惑不解,通常在构筑服务器集群的时候,不合理的设计造成系统的整体效率不高、设备浪费或者维护的不便利,本文试图用最简单的方式解惑。 要解决这些问题,不惑者需要正确自我解答以下问题: 1.系统的并发是否是考虑的主要问题之一? 2.以后并发用户会不会急剧增长? 3.运营的软件是否是一个标准的三级架构或者多级架构(N-Tier)? 4.运营的软件的端口是否对应不同的业务? 5.不同的业务软件是否运行在不同的服务器设备上? 6.资金是否成为问题? 第二章基本的技术知识 2.1 HA高可用集群 HA(单字母发音, H A 不是“哈”)高可用集群主要是为了“保护”“特定资源”所开发的一种集群技术,这里所说的“特定资源”包含以下内容: 1)进程; 如果进程被杀死,即从系统角度上看,该进程没有了,那么,HA可以及时发现,并在 另外一个地方将部署好的进程启动;如果该进程僵死,即不工作了,可能由于软件设计 的不好,出现了死循环或者其他原因,但该进程还存在,这时HA是不能发现的,所以,有时候即使进程不响应了,HA并没有切换; 解决这个问题,只能依靠应用软件提供监控接口,并将该接口公布给HA开发商。我们 在市场中发现有些厂商的基于数据库的特别好使,有些公司的产品出现同样状况时却像 傻子一样,这个可能是不同的HA厂商和数据库厂商合作的深浅度有关。 2)网卡; 如果网卡完全挂掉,HA是可以发现并采用行动,但是工作的不正常,这种情况HA可 能不能发现,尤其是抖动的情况发生; 3)存储; 1 服务器集群技术方案 集群(Cluster)技术是发展高性能计算机的一项技术。它是一组相互独立的计算机,利用高速通信网络组成一个单一的计算机系统,并以单一系统的模式加以管理。其出发点是提供高可靠性、可扩充性和抗灾难性。一个集群包含多台拥有共享数据存储空间的服务器,各服务器通过内部局域网相互通信。当一台服务器发生故障时,它所运行的应用程序将由其它服务器自动接管。在大多数模式下,集群中所有的计算机拥有一个共同的名称,集群内的任一系统上运行的服务都可被所有的网络客户使用。采用集群系统通常是为了提高系统的稳定性和网络中心的数据处理能力及服务能力。 当前主流的集群方式包括以下几种: 1.服务器主备集群方式 服务器主-备方式由一台服务器在正常运行状态提供对外服务,其它集群节点作为备份机,备份机在正常状态下不接受外部的应用请求,实时对生产机进行检测,当生产机停机时才会接管应用服务,因此设备利用率最高可达50%。主备方式集群如下图所示,节点2为正常提供服务的服务器,运行多个应用(pkgA,pkgB..),节点1平时只监控节点2的状态,不对外提供服务,当节点2出现故障时,节点1将把两个应用接管过来,并对外提供服务。 图表错误!文档中没有指定样式的文字。-1主备方式集群 2.服务器互备份集群方式 多台服务器组成集群,每台服务器运行独立的应用,同时作为其它服务器的备份机,当主应用中断,服务将被其它集群节点所接管,接管服务的节点将运行 自身应用和故障服务器的应用,这种方式各集群节点的硬件资源均可被应用于对外服务。互备方式集群如下图所示,节点1和节点2分别运行1个或多个不同的应用,但只对外提供本地的主应用,两个节点之间互相进行监控,集群中任何一个节点出现故障后,另一个节点把故障节点的主应用接管过来,所有应用服务由一台服务器完成。 图表错误!文档中没有指定样式的文字。-2互备份方式集群这种方式的主要缺点在于: 由于需要重新启动数据库核心进程,无法保证数据库系统连续不间断地 运行 在系统切换的过程中,客户端与服务器之间的数据库连接会中断,需要 重新进行数据库的连接和登录工作 由于数据库系统只能在一台服务器上运行,另一台服务器无法分担系统 的负载,实际上造成了客户投资的浪费。在有些系统中,为了解决双机 负载分担的问题,将应用系统人为分割为两个数据库系统,分别在两台 服务器上运行。这种方式在一定程度上解决了负载分担的问题,但给系 统管理、统计分析等业务处理带来了很多额外的复杂性 3.服务器并行集群方式 集群有多台服务器构成,同时提供相同的应用,可以实现多台服务器之间的负载均衡,提供大访问量的应用需求,如Web访问及数据库等应用,服务器并行集群方式一般由应用系统自身(如OracleRAC、中间件负载均衡等)或外部专用服务器负载均衡设备实现。 集群和负载均衡的概念 什么是集群(Cluster) 所谓集群是指一组独立的计算机系统构成的多处理器系统,每台服务器都具有等价的地位,它们之间通过网络实现进程间的通信。应用程序可以通过网络共享内存进行消息传送,实现分布式计算机。集群也是指多台计算机共同协作运行一个应用。 可分为以下几种: (1)高可靠性(HA)。利用集群管理软件,当主服务器故障时,备份服务器能够自动接管主服务器的工作,并及时切换过去,以实现对用户的不间断服务。 (2)高性能计算(HP)。即充分利用集群中的每一台计算机的资源,实现复杂运算的并行处理,通常用于科学计算领域。 (3)负载平衡(Load Balance)。负载均衡就是集群功能其中的一种。即把负载压力根据某种算法合理分配到集群中的每一台计算机上,以减轻主服务器的压力,降低对主服务器的硬件和软件要求。 负载均衡是指将计算请求分配到集群中以使集群中的计算机的计算负载均衡。 负载均衡有两方面的含义: 1:大量的并发访问或数据流量分担到多台节点设备上分别处理,减少用户等待响应的时间。 2:单个重负载的运算分担到多台节点设备上做并行处理,每个节点设备处理结束后,将结果汇总,返回给用户,系统处理能力得到大幅度提高。实现起来可分为: (1)基于服务器软件的集群负载均衡。(在服务器上实现。) (2)NAT的集群负载均衡(在放火墙上,或在交换机上实现。) (3)基于DNS的集群负载均衡(在DNS服务器上实现。) (4)也可以用ISA放火墙实现集群负载均衡,但是需要有ISA服务器本人认为可行性不大。 基于服务器软件的集群负载均衡 microsoft的产品4种集群技术: 1:microsoft 集群服务(MSCS) 2:网络负载均衡(NLB) 3:组件负载均衡(CLB) 4:application center(应用负载均衡) linux 的集群技术:LVS(Linux VirtualServer) LVS对Linux的kernel进行了修改和增加所以要重新编译linux 内核。包名linux-2.4.20-ipvs-*.*.*.patch.gz 基与nat的集群负载均衡(在放火墙上,或在交换机上实现。) NAT(Network Address Translation 网络地址转换)简单地说就是将一个IP地址转换为另一个IP地址。一般用于内部地址与合法的转换。适用于解决Internet IP地址紧张、不想让网络外部知道内部网络结构等的场合下。 NAT负载均衡将一个外部IP地址映射为多个内部IP地址,对每次连接请求动态地转换为一个内部服务器的地址,将外部连接请求引到转换得到地址的那个服务器上,从而达到负载均衡的目的。 基于DNS的集群负载均衡(在DNS服务器上实现。) DNS负载均衡技术是在DNS服务器中为同一个主机名配置多个IP地址,在应答DNS查询时,DNS服务器对每个查询将以DNS文件中主机记录的IP地址按顺序返回不同的解析结果,将客户端的访问引导到不同的机器上去,使得不同的客户端访问不同的服务器,从而达到负载均衡的目的。 Apache+Tomcat+mod_jk实现负载均衡方案 一、概述: 原理图: 提高系统可用性,对系统性能影响较小。对于一台服务器Down机后,可自动切换到另 最少需要两台机器,Tomcat1 和Tomcat2可在同一台服务器上。若条件允许最好是各用一台服务器。 二、详细配置步骤: 1、Apache http Server安装 32位的按照提示操作即可。 64位系统的不是安装包。 64位安装配置: 以管理员身份运行cmd 执行:httpd -k install 若无法运行并提示配置错误,请先安装vcredist_x64.exe后再执行。 安装后在Testing httpd.conf...时会报错,不影响。 httpd -k start 启动Apache、httpd -k shutdown 停止Apache 、httpd -k restart重启测试Apache: 在IE中输入:127.0.0.1 打开网页显示It work就OK 2、将Mod_jk的压缩包解压,找到mod_jk.so 复制到Apache目录下modules目录下 64位的下载mod_jk1.2.30_x64.zip 32位的下载tomcat-connectors-1.2.35-windows-i386-httpd-2.0.x.zip 3、修改Apache conf目录下的httpd.conf文件 在最后增加:Include conf/extra/mod_jk.conf 4、在conf/extra 下创建mod_jk.conf文件 增加如下: #load module mod_jk.so LoadModule jk_module modules/mod_jk.so #mod_jk config #load workers JkWorkersFile conf/workers.properties #set log file JkLogFile logs/mod_jk.log #set log level JkLogLevel info #map to the status server #mount the status server JkMount /private/admin/mystatus mystatus JkMount /* balance 5.在conf目录下创建workers.properties文件 增加:worker.tomcat1 中的tomcat1和tomcat2必须和Tomcat中的配置相同。Tomcat配置下面介召 worker.list=balance,mystatus #first worker config worker.tomcat1.type=ajp13 worker.tomcat1.host=192.168.8.204 worker.tomcat1.port=8009 #Tomcat的监听端口 worker.tomcat1.lbfactor=1 worker.tomcat1.socket_timeout=30 worker.tomcat1.socket_keepalive=1 #second worker config worker.tomcat2.type=ajp13 worker.tomcat2.host=192.168.8.204 worker.tomcat2.port=8010 #Tomcat的监听端口实验是在同一机器上做的,所以两个不同 为了提高服务器的性能和工作负载能力,天互云计算通常会使用DNS服务器、网络地址转换等技术来实现多服务器负载均衡,特别是目前企业对外的互联网Web 网站,许多都是通过几台服务器来完成服务器访问的负载均衡。 目前企业使用的所谓负载均衡服务器,实际上它是应用系统的一种控制服务器,所有用户的请求都首先到此服务器,然后由此服务器根据各个实际处理服务器状态将请求具体分配到某个实际处理服务器中,对外公开的域名与IP地址都是这台服务器。负载均衡控制与管理软件安装在这台服务器上,这台服务器一般只做负载均衡任务分配,但不是实际对网络请求进行处理的服务器。 一、企业实现Web服务器负载均衡 为了将负载均匀的分配给内部的多个服务器上,就需要应用一定的负载均衡策略。通过服务器负载均衡设备实现各服务器群的流量动态负载均衡,并互为冗余备份。并要求新系统应有一定的扩展性,如数据访问量继续增大,可再添加新的服务器加入负载均衡系统。 对于WEB服务应用,同时有几台机器提供服务,每台机器的状态可以设为regular(正常工作)或backup(备份状态),或者同时设定为regular状态。负载均衡设备根据管理员事先设定的负载算法和当前网络的实际的动态的负载情况决定下一个用户的请求将被重定向到的服务器。而这一切对于用户来说是完全透明的,用户完成了对WEB服务的请求,并不用关心具体是哪台服务器完成的。 二、使用网络地址转换实现多服务器负载均衡 支持负载均衡的地址转换网关中可以将一个外部IP地址映射为多个内部IP地址,对每次TCP连接请求动态使用其中一个内部地址,达到负载均衡的目的。很多硬件厂商将这种技术集成在他们的交换机中,作为他们第四层交换的一种功能来实现,一般采用随机选择、根据服务器的连接数量或者响应时间进行选择的负载均衡策略来分配负载。然而硬件实现的负载控制器灵活性不强,不能支持更优化的负载均衡策略和更复杂的应用协议。 基于网络地址转换的负载均衡器可以有效的解决服务器端的CPU和磁盘I/O负载,然而负载均衡器本身的性能受网络I/O的限制,在一定硬件条件下具有一定的带宽限制,但可以通过改善算法和提高运行负载均衡程序的硬件性能,来提高这个带宽限制。不同的服务类型对不同的服务器资源进行占用,我们使用的负载衡量策略是使用同一个负载进行评估,这对于大多数条件是适合的,然而最好的办法是针对不同的资源,如CPU、磁盘I/O或网络I/O 等,分别监视服务器负载,由中心控制器选择最合适的服务器分发客户请求。 三、使用DNS服务器实现负载均衡 Web服务器集群负载均衡技术的应用与研究 侯秀杰祝永志孔令鑫 (曲阜师范大学计算机科学学院,山东日照 276826 ) 摘要为了提高集群系统对用户的快速响应与整体吞吐量,必须采取一定的策略将Web访问均衡地分配到集群中的每一个服务器。基于此思想本文针对传统的单机思想给出了一种多机三层结构的负载均衡系统。实验结果表明了它在负载均衡方面的优越性。 关键词负载均衡;均衡策略;调度算法;Web服务器集群模型 1 引言 Internet的快速增长,特别是电子商务应用的发展,使Web应用成为目前最重要最广泛的应用,Web 服务器动态内容越来越流行。目前,网上信息交换量几乎呈指数增长,需要更高性能的Web服务器提供更多用户的Web服务,因此,Web服务器面临着访问量急剧增加的压力,对其处理能力和响应能力等带来更高的要求,如果Web 服务器无法满足大量Web访问服务,将无法为用户提供稳定、良好的网络应用服务。 由于客观存在的服务器物理内存、CPU 处理速度和操作系统等方面的影响因素,当大量突发的数据到达时,Web服务器无法完全及时处理所有的请求,造成应答滞后、请求丢失等,严重的导致一些数据包因延时而重发,使传输线路和服务器的负担再次增加。传统的方法是提高Web 服务器的CPU 处理速度和增加内存容量等硬件办法但无论如何增加Web 服务器硬件性能,均无法满足日益增加的对用户的访问服务能力。 面对日渐增加的Web 访问服务要求,必须对Web 服务器按一定策略进行负载分配。利用负载均衡[1]的技术,按照一定策略将Web 访问服务分配到几台服务器上,负载处理对用户透明,整体上对外如同一台Web 服务器为用户提供Web服务。 2 Web负载均衡结构 2.1 负载均衡 负载是一个抽象的概念,是表示系统繁忙程度,系统在一段时间空闲,该系统负载轻,系统在一段时间空忙,该系统负载重,影响系统负载的各种因数较多如果存在很多的数据包同时通过网络连向一台Web 服务器,也就是网络的速度比网络所连接的设备速度快的情况下,系统负载不断增加,直到最大。 目前提高Web 服务器性能,使其具有较强负载能力,主要有两种处理思想[2]: 1)单机思想 不断升级服务器硬件性能,每当负载增加,服务器随之升级。这随之将带来一些问题,首先,服务器向高档升级,花费资金较多;其次,升级频繁,机器切换造成服务中断,可能会导致整个服务中断;最后,每种架构的服务器升级总有一个极限限制。 2)多机思想 使用多台服务器提供服务,通过一定机制使它们共同分担系统负载,对单一的服务器没有太高的性能要求,系统负载增加,可以多增加服务器来分担。对用户而言,整个系统仿佛是一台单一的逻辑服务器,这样的系统能够提供较强的可扩展性和较好的吞吐性能。 为了适应当前急剧增长的Web访问,有别于传统的单机思想,解决单机思想带来的一系列问题,本文提出了一种基于权值的策略分配负载。 2.2 负载均衡实现设备[2]广域网负载均衡原理简单介绍

集群HA负载均衡技术

F5负载均衡基本原理

Tomcat集群与负载均衡

负载均衡的基础原理说明

数据库负载均衡解决方案

F5负载均衡原理

集群的负载均衡技术综述

负载均衡器部署方式和工作原理

分布式与集群的区别

服务器负载均衡

用双机高可用集群还是使用负载均衡集群

服务器集群技术方案

集群和负载均衡的概念

负载均衡方案及详细配置

实现服务器负载均衡常见的四种方法

Web服务器集群负载均衡技术的应用与研究