决策树论文

决策树ID3算法在学生成绩中的应用

摘要:介绍了数据挖掘中决策树的分类方法和概念,以及著名的ID3算法,同时也介绍了ID3算法在学生成绩中的应用.

关键词:数据挖掘;知识发现;分类;决策树;ID3算法

引言:

随着数据库管理系统在教学工作中的应用,数据库积累的数据越来越多,特别是学生的成绩数据库,数据量过于庞大,但目前对这些数据的处理还只是简单的备份、查询与统计,并没有对大量的成绩数据进行深入的分析,加以捕捉有利于教学工作的信息.因此如何快速而又准确地从浩瀚的成绩数据库中提取出所需信息,就需要一种新的数据分析技术加以处理,数据挖掘技术正是解决这个问题的可行而有效的方法.

1基本原理

1.1数据挖掘基本概念

数据挖掘(Data Mining,简称DM)就是从大量的、不完全的、有噪声的、模糊的、随机的数据中,提取隐含在其中的、人们事先不知道的、但又有潜在的有用信息和知识的过程[1],是数据库中的知识发现(Knowledge Discovery in Databases,简称KDD)的核心.它是涉及数据库、人工智能、机械学、统计学、人工神经网络等的交叉学科.目前,常用的数据挖掘分析方法有:关联规则分析、序列模式分析、分类分析、聚类分析几种,本文选择了分类技术中的决策树用于学生成绩中的数据挖掘.

1.2决策树的分类方法和概念

决策树是通过一系列规则对数据进行分类的过程.它提供一种在什么条件下会得到什么值的类似规则的方法【2 J.它采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较,并根据不同的属性值从该节点向下分支,叶节点是要学习划分的类,从根节点到叶节点的一条路径就对应着一条分类规则,整个决策树就对应着一组析取表达式规则.

1.3ID3算法介绍

决策树归纳的基本算法是贪心算法,它以自顶向下递归的方法构造决策树.著名的决策树归纳算法ID3算法的基本策略如下:

(1)树以代表训练样本的单个节点开始.

(2)如果样本都在同一个类中,则这个节点成为树叶节点,并用该类标记.

(3)否则,算法使用称为信息增益的基于熵的度量作为启发信息,选择能够最好的将样本分类的属性,该属性成为该节点的“测试”或“判定”属性.

(4)对测试属性的每个已知的值创建一个分支,并据此划分样本.

(5)算法使用类似的方法,递归地形成每个划分上的样本决策树.一旦一个属性出现在一个节点上。就不必在该节点的后代上考虑这个属性.属性选择采用信息增益的方法来确定.通过选择具有最高信息增益的属性作为当前节点的测试属性,这样保证分类时所需信息最小,从而产生的决策树最为简单.几个重要的公式:任意样本分类的期望m信息:I(s。,s:,?,S。)=一.∑.pi姗:(Pi),其中,数据集为S,m为S分类数目,Pi=Si/S是任意一个数据t S上?上q对象属于类别Ci的概率.利用属性A划分样本集合所需要的信息(熵):E(A)=五』二1二二巫I(s。j,J2JJ?,SⅢi).信息增益:Gain(A)=I(S。,S:,?,S,)一E(A).当决策树创建时,由于数据中的噪声和孤立点,许多分枝反映的是训练中的异常,因此还要对决策树进行剪枝.有两种常用的剪枝方法,先剪枝方法和后剪枝方法.最后要从决策树提取分类规则,并用if?tIlen的形式表示出来.

2 ID3算法在学生成绩中的应用

2.1数据预处理

2.1.1数据转换

数据转换主要是对数据进行规格化操作,将数据变成统一的格式.

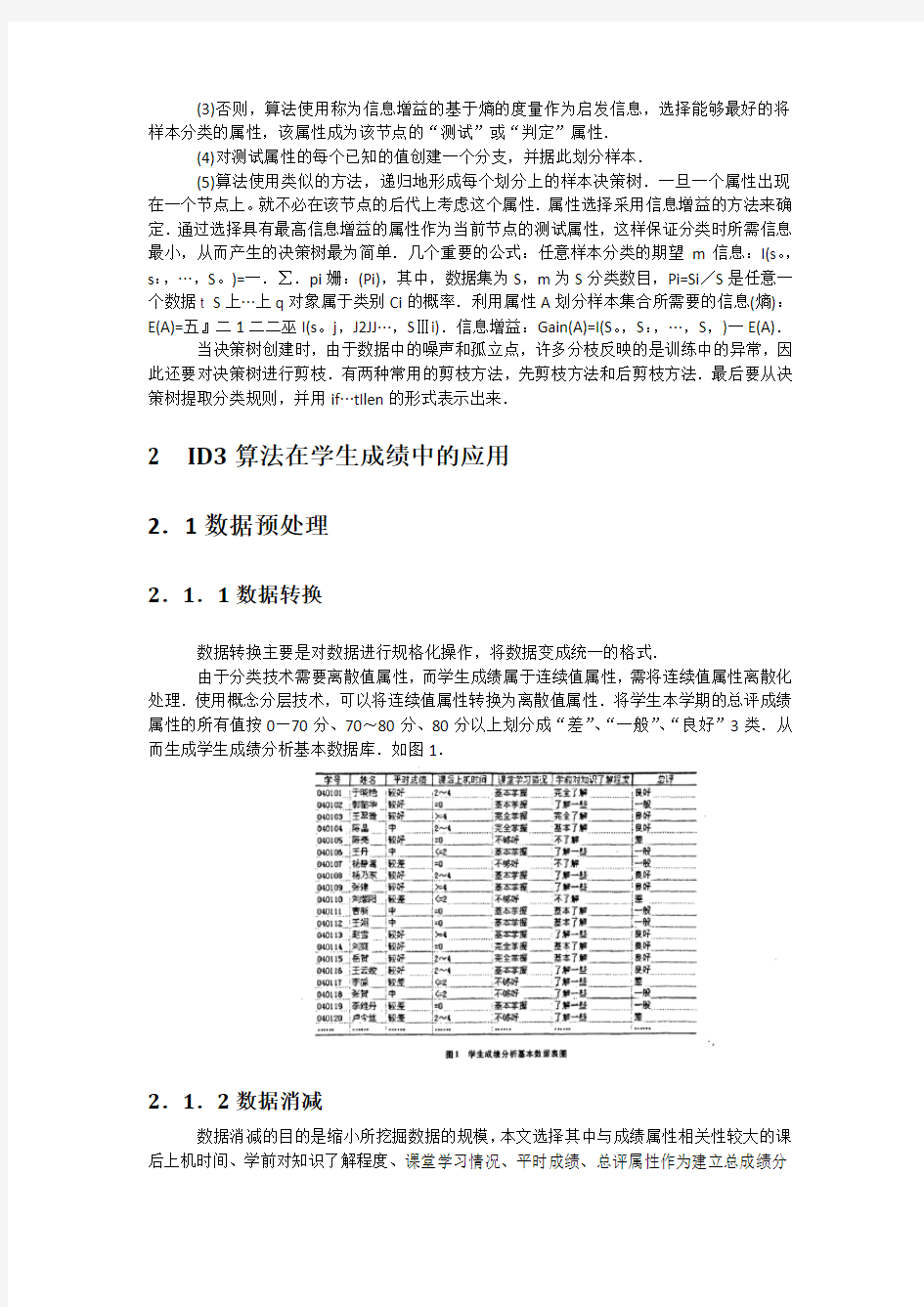

由于分类技术需要离散值属性,而学生成绩属于连续值属性,需将连续值属性离散化处理.使用概念分层技术,可以将连续值属性转换为离散值属性.将学生本学期的总评成绩属性的所有值按0—70分、70~80分、80分以上划分成“差”、“一般”、“良好”3类.从而生成学生成绩分析基本数据库.如图1.

2.1.2数据消减

数据消减的目的是缩小所挖掘数据的规模,本文选择其中与成绩属性相关性较大的课后上机时间、学前对知识了解程度、课堂学习情况、平时成绩、总评属性作为建立总成绩分

类决策树模型的依据,并且为了重点分析成绩良好的原因,将“总评”字段转化为“是否优良”字段,选择“是否优良”为类别属性,有两个类“Yes”和“No”,从而生成用于对成绩是否优良进行分类的基本数据表,如图2.

2.2ID3算法的实现与应用

这里将重点说明是否优良决策树模型的生成.从训练集中选取252个样本,其中类“是”有85个样本,类“否”有167个样本.计算对给定样本分类所需的信息熵:t(s?S)=I(85,167)=一爰l。g:簧一墨l。g:墨=o.922

2

首先计算“平时成绩”属性,该属性有3个属性值,需对每个属性所划分的子集计算信息熵:

对于“平时成绩”=“较好”,类“Yes”有52个样本,类“No”有37个样本,由公式计算出:I(su,S:。)

=0.979 4

对于“平时成绩”=“中”,类“Yes”有32个样本,类“No”有81个样本,由公式计算出:I(SmS笠)=

0.859 8

对于“平时成绩”=“差”,类“Yes”有1个样本,类“No”有49个样本,由公式计算出:I(SmS∞)=

0.141 4

按平时成绩划分给定样本所需的期望信息为:E(平时成绩):丽89 I(s¨,$21)+黑I(S。:,S篮)+罴I

(SmS∞)=O.759 5,则Gain(平时成绩)=I(s。,S:)一E(平时成绩)=0.162 7.同理:Gain(课后上机

时问)三0.081 2,Gain(课堂学习情况)=0.089,Gain(学前对知识了解程度)=0.035 3.由于“平时成绩”属性具有最高增益信息,它被选作测试属性.

创建一个节点,用“平时成绩”标记,并对每个属性值,引出一个分支,样本以此划分.其它分支节点的划分也按此方法.算法返回的决策树如图3所示.这是一棵完全生长的决策树,过于“枝繁叶茂”,为了使得到的决策树所蕴含的规则具有普遍意义,必须对决策树进行修剪,以提高今后分类识别的速度和分类识别新数据的能力.本文采用事后修剪的方法,首先计算出一个充分生长的决策树的错误率,由用户指定一个最大的允许错误率.当剪

枝达到某个深度时,计算出的错误率高于允许的最大值时,立即停止剪枝,否则可以继续剪枝.图4为剪枝后的成绩是否优良分类决策树.

决策树最大的优点就是可以直接提取分类规则.由于本例中希望了解影响学生学习成绩优良的因素,因此,所提取的规则主要考虑分类为“Yes”的百分比规则.所生成的成绩为优良的分类规则如下:

IF平时成绩=“较好”AND课堂学习=。完全掌握”THEN成绩优良的比率=100%

IF平时成绩=“较好”AND课堂学习=“基本掌握”THEN成绩优良的比率=72%

IF平时成绩=“较好”AND课堂学习=“不够好”AND上机时间=“>=4”THEN成绩优良的比率=67%

IF平时成绩=“较好”AND课堂学习=“不够好”AND上机时间=“2—4”THEN成绩优良的比塞=71%

一.2) t17.3y

田4剪枝后的成绩是否优良决策树

IF平时成绩=“较好”AND课堂学习=“不够好”AND上机时间=“<=2”THEN成绩优良的比率=18%

IF平时成绩=“较好”AND课堂学习=“不够好”AND上机时间=“=O”THEN成绩优良的比率=O%

IF平时成绩=“较好”AND课堂学习=“不好”THEN成绩优良的比率=0%

IF平时成绩=“中”AND课堂学习=“完全掌握”THEN成绩优良的比率=100%

IF平时成绩=“中”AND课堂学习=“基本掌握”THEN成绩优良的比率=32%

IF平时成绩=“中”AND课堂学习=“不够好”THEN成绩优良的比率=22%

IF平时成绩=“中”AND课堂学习=“不好”THEN成绩优良的比率=O%

IF平时成绩=“较差”THEN成绩优良的比率=2%

3结论

数据挖掘是深层次的数据信息分析方法,将数据挖掘技术应用于对学生成绩的分析无疑是非常有益的,它可以全面地分析考试结果与各种因素之间隐藏的内在联系,可以挖掘出很多意想不到的知识,从而会促进教学质量的进一步提高,科学地指导教学.相信随着数据挖掘在教学上越来越广泛的应用,必将会给我国的教育事业带来质的飞跃.

参考文献:

1]张儒良,玉翰虎.论数据挖掘优化教学管理[J].贵州民族学院学报,2004,(2):133—135.

[2]马秀红,宋建社,董晟飞.数据挖掘中决策树的探讨[J].计算机工程与应用,2004,(1):185.

[3]Jiawei Hart,MichellneKamber.数据挖掘概念与技术[M].范明。孟小峰译.北京:机械工业出版社,2001.

[4]张伟. 数据挖掘中的ID3算法研究与实现[J]. 软件导刊, 2010,(5) .

数据挖掘算法综述

数据挖掘方法综述 [摘要]数据挖掘(DM,DataMining)又被称为数据库知识发现(KDD,Knowledge Discovery in Databases),它的主要挖掘方法有分类、聚类、关联规则挖掘和序列模式挖掘等。 [关键词]数据挖掘分类聚类关联规则序列模式 1、数据挖掘的基本概念 数据挖掘从技术上说是从大量的、不完全的、有噪声的、模糊的、随机的数据中提取隐含在其中的、人们事先不知道的、但又是潜在的有用的信息和知识的过程。这个定义包括好几层含义: 数据源必须是真实的、大量的、含噪声的、发现的是用户感兴趣的知识, 发现的知识要可接受、可理解、可运用, 并不要求发现放之四海皆准的知识, 仅支持特定的发现问题, 数据挖掘技术能从中自动分析数据进行归纳性推理从中发掘出潜在的数据模式或进行预测, 建立新的业务模型帮助决策者调整策略做出正确的决策。数据挖掘是是运用统计学、人工智能、机器学习、数据库技术等方法发现数据的模型和结构、发现有价值的关系或知识的一门交叉学科。数据挖掘的主要方法有分类、聚类和关联规则挖掘等 2、分类 分类(Classification)又称监督学习(Supervised Learning)。监

督学习的定义是:给出一个数据集D,监督学习的目标是产生一个联系属性值集合A和类标(一个类属性值称为一个类标)集合C的分类/预测函数,这个函数可以用于预测新的属性集合(数据实例)的类标。这个函数就被称为分类模型(Classification Model),或者是分类器(Classifier)。分类的主要算法有:决策树算法、规则推理、朴素贝叶斯分类、支持向量机等算法。 决策树算法的核心是Divide-and-Conquer的策略,即采用自顶向下的递归方式构造决策树。在每一步中,决策树评估所有的属性然后选择一个属性把数据分为m个不相交的子集,其中m是被选中的属性的不同值的数目。一棵决策树可以被转化成一个规则集,规则集用来分类。 规则推理算法则直接产生规则集合,规则推理算法的核心是Separate-and-Conquer的策略,它评估所有的属性-值对(条件),然后选择一个。因此,在一步中,Divide-and-Conquer策略产生m条规则,而Separate-and-Conquer策略只产生1条规则,效率比决策树要高得多,但就基本的思想而言,两者是相同的。 朴素贝叶斯分类的基本思想是:分类的任务可以被看作是给定一个测试样例d后估计它的后验概率,即Pr(C=c j︱d),然后我们考察哪个类c j对应概率最大,便将那个类别赋予样例d。构造朴素贝叶斯分类器所需要的概率值可以经过一次扫描数据得到,所以算法相对训练样本的数量是线性的,效率很高,就分类的准确性而言,尽管算法做出了很强的条件独立假设,但经过实际检验证明,分类的效果还是

《C4.5算法概述》

目录 1 决策树算法 (2) 1.1 具体应用场景和意义 (2) 1.2 现状分析 (3) 2 C4.5算法对ID3算法的改进 (4) 3 C4.5算法描述 (7) 3.1 C4.5算法原理 (7) 3.2 算法框架 (8) 3.3 C4.5算法伪代码 (9) 4 实例分析 (9) 5 C4.5算法的优势与不足 (12) 5.1 C4.5算法的优势 (12) 5.2 C4.5算法的不足: (12) 参考文献 (12)

C4.5算法综述 摘要 最早的决策树算法是由Hunt等人于1966年提出的CLS。当前最有影响的决策树算法是Quinlan于1986年提出的ID3和1993年提出的C4.5。ID3只能处理离散型描述属性,它选择信息增益最大的属性划分训练样本,其目的是进行分枝时系统的熵最小,从而提高算法的运算速度和精确度。ID3算法的主要缺陷是,用信息增益作为选择分枝属性的标准时,偏向于取值较多的属性,而在某些情况下,这类属性可能不会提供太多有价值的信息。C4.5是ID3算法的改进算法,不仅可以处理离散型描述属性,还能处理连续性描述属性。C4.5采用了信息增益比作为选择分枝属性的标准,弥补了ID3算法的不足。 C4.5算法在ID3算法的基础上进行了改进,对于预测变量的缺值处理、剪枝技术、派生规则等方面作了较大的改进,既适合于分类问题,又适合于回归问题,是目前应用最为广泛的归纳推理算法之一,在数据挖掘中收到研究者的广泛关注。 1 决策树算法 1.1具体应用场景和意义 决策树(Decision Tree)是用于分类和预测的主要技术,它着眼于从一组无规则的事例推理出决策树表示形式的分类规则,采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较,并根据不同属性判断从该节点向下分支,在决策树的叶节点得到结论。因此,从根节点到叶节点就对应着一条合理规则,整棵树就对应着一组表达式规则。基于决策树算法的一个最大的优点是它在学习过程中不需要使用者了解很多背景知识,只要训练事例能够用属性即结论的方式表达出来,就能使用该算法进行学习。 决策树算法在很多方面都有应用,如决策树算法在医学、制造和生产、金融分析、天文学、遥感影像分类和分子生物学、机器学习和知识发现等领域得到了广泛应用。 决策树技术是一种对海量数据集进行分类的非常有效的方法。通过构造决策树模型,提取有价值的分类规则,帮助决策者做出准确的预测已经应用在很多领

基于决策树的鸢尾花分类

科技论坛 0 引言 图像识别技术,要运用目前流行的机器学习算法,而目前流行的机器学习算法就有十几种,比如支持向量机、神经网络、决策树。机器学习是人工智能发展的重要一部分,它涉及的学科很多,应用也相当广泛,它通过分析、研究、设计让计算机学习知识,从而提高完善自身的性能。但是神经网络学习的速度较慢,传统的支持向量机则不能解决分类多的问题。 本文针对鸢尾花的特征类别少以及种类少的特点,采用决策树算法对课题进行展开,对比与其他人利用支持向量机、神经元网络模型来进行研究,该系统具有模型简单、便于理解、计算方便、消耗资源少的优点。 1 决策树模型和学习 本文采用决策树算法对鸢尾花进行分类,先建立决策树的模型并进行学习训练,在决策树的训练过程中采用是信息论的知识进行特征选择,对选定的特征采用分支的处理,然后再对分支过后的数据集如此反复的递归生成决策树,在一颗决策树生成完后对决策树进行剪枝,以减小决策树的拟合度,来达到一个对鸢尾花较高的分类准确率。 要对鸢尾花进行分类首先需要大量的鸢尾花数据集作为本文的实验数据,本文采用的数据集是来自加州大学欧文分校UCI数据库中的鸢尾花数据集。该数据集中鸢尾花的属性有四个,分别是花萼长度、花萼宽度、花瓣长度和花瓣宽度,鸢尾花的类别则有三种,分别是Iris Setosa,Iris Versicolour,Iris Virginica,用简写Se、Ve和Vi表示这三种花,具体数据如图1所示。 ■1.1 信息论 美贝尔电话研究所的数学家香农是信息论的创始人,1948年香农发表了《通讯的数学理论》,成为信息论诞生的标志。信息论的诞生对信息技术革命以及科学技术的发展起到重要作用。信息论中有两个概念信息增益及信息增益率,都是用于衡量原始数据集在按照某一属性特征分裂之后整体信息量的变化值。这样,本文就可以通过这种指标寻找出最优的划分属性,数据集在经过划分之后,节点的“纯度”越来越高,这里的纯度值得是花朵的类别,当某一节点中花朵全为一类时,该节点已经达到最纯状态,无需再进行划分, 反之继续划分。 图1 鸢尾花数据集 1.1.1 信息熵 信息熵用于描述信源的不确定性。即发生每个事件都有不确定性,为了使不确定性降低,我们需要引入一些相关的信息进行学习,引入信息越多,那么得到的准确率越高,信息熵越高,信源越不稳定。例如一束鸢尾花,它可能是Se,可能是Vi,也有可能是Ve,我们利用数据库中的各种鸢尾花的花瓣长度、花瓣宽度、花萼长度和花萼宽度来预测鸢尾花的类别,引入的鸢尾花种类越多,信息熵就越高。 样本集合D的信息熵Ent(D)以下面的公式进行计算,其中集合里第k类样本所占的比例是k p,k的取值范围是从1到y,y值得是总共有y类样本,通过式(1)可以计算得到原始样本集的信息熵。 ()21 Ent D y k k k p log p = =?∑(1) 1.1.2 信息增益 信息增益即在一个条件下,信源不确定性减少的程度。信息增益用于度量节点的纯度。信息增益对可取值数目较多的属性有所偏好。在鸢尾花数据集的D集合中,属性a取到某一取值情况的概率乘该取值情况的信息熵得到的值记为v D,其中V指的是该属性a可以取值的个数,则属性a 的信息增益为: ()()() 1 Gain D,a Ent D V v v v D Ent D D = =?∑(2) 基于决策树的鸢尾花分类 徐彧铧 (浙江省衢州第二中学,浙江衢州,324000) 摘要:针对传统手工分类的不足,满足不了人们对图片分类的需求,本文利用机器学习算法中的决策树算法进行研究。通过模型简单、便于理解、计算方便、消耗资源少的决策树算法模型,并利用现成的数据库,运用图像识别技术对鸢尾花进行分类,以求方便简单快速地识别出不同类别的鸢尾花。在此过程中,学习到图像识别的一些基本分类操作,为我们实现更复杂的模型提供了帮助。 关键词:决策树信息论特征选择;C4.5算法;CART算法 www ele169 com | 99

决策树学习研究综述

科技论坛 决策树学习研究综述 叶萌 (黑龙江电力职工大学,黑龙江哈尔滨150030) 1概述 决策树是构建人工智能系统的主要方法之一,随着数据挖掘技术在商业智能等方面的应用,决策树技术将在未来发挥越来越强大的作用[1]。自从Quinlan 在1979年提出构造决策树ID3算法以来,决策树的实现已经有很多算法,常见的有:CLS (concept learning system )学习算法,ID4、ID5R 、C4.5算法,以及CART 、C5.0、FuzzyC4.5、0C1、QUEST 和CAL5等[2]。 现在,许多学者在规则学习与决策树学习的结合方面,做了大量的研究工作。Brako 等的ASSISTANT ,将AQ15中的近似匹配方法引入决策树中。Clark 等的CN2,将ID3算法和AQ 算法编织在一起,用户可选择其中任何一种算法使用。Utgoff 等的ID5R 算法,不要求一次性提供所有的训练实例,训练实例可以逐次提供,生成的决策树逐次精化,以支持增量式学习。洪家荣教授结合实际应用问题对ID3算法作了一些改进,提出了两个ID3和AQ 结合的改进算法,IDAQ 和AQID ,此外,还陆续出现了处理大规模数据集的决策树算法,如SLIQ ,SPRINT 等等[3]。 2决策树算法研究2.1构造决策树算法 决策树学习是从无次序、无规则的样本数据集中推理出决策树表示形式、逼近离散值目标函数的分类规则方法。它采用自顶向下的递归方式,在决策树的内部结点进行属性值的比较并根据不同的属性值判断从该结点向下的分支,在决策树的叶结点得到结论,因此从根结点到叶结点的一条路径就对应着一条规则,整棵决策树就对应着一组表达式规则。我们可将决策树看成是定义布尔函数的一种方法。其输入是一组属性描述的对象,输出为yes/no 决策。决策树代表一个假设,可以写成逻辑公式。决策树的表达能力限于命题逻辑,该对象的任一个属性的任一次测试均是一个命题。在命题逻辑范围内,决策树的表达能力是完全的。一棵决策树可以代表一个决定训练例集分类的决策过程,树的每个结点对应于一个属性名或一个特定的测试,该测试在此结点根据测试的可能结果对训练例集进行划分。划分出的每个部分都对应于相应训练例集子空间的一个分类子问题,该分类子问题可以由一棵决策树来解决。因此,一 棵决策树可以看作是一个对目标分类的划分和获取策略[4] 。 2.2处理大规模数据集的决策树算法 ID3或者C4.5算法都是在建树时将训练集一次性装载入内存的。但当面对大型的有着上百万条纪录的数据库时,就无法实际应用这些算 法。针对这一问题, 前人提出了不少改进方法,如数据采样法、连续属性离散化法或将数据分为若干小块分别建树然后综合成一个最终的树,但这些改进都以降低了树的准确性为代价。直到M etha,Agrawal 和Ris-sane 在1996年提出了SLIQ 方法,以及在此基础上进行改进得到的SPRINT [6]方法。 3决策树学习的常见问题3.1过度拟合 在利用决策树归纳学习时,需要事先给定一个假设空间,且必须在这个假设空间中选择一个,使之与训练实例集相匹配。我们知道任何一个学习算法不可能在没有任何偏置的情况下学习。如果事先知道所要学习的函数属于整个假设空间中的一个很小的子集,那么即使训练实例不完整,也有可能从已有的训练实例集中学习到有用的假设,使它对未来的实例进行正确的分类。当然,我们往往无法事先知道所要学习的函数属于整个假设空间中的哪个很小的子集,即使是知道,我们还是希望有一个大的训练实例集。因为训练实例集越大,关于分类的信息就越多。这时,即使随机地从与训练实例集相匹配的假设集中选择一个,它也能对未知实例的分类进行预测。相反,如果训练实例集与整个假设空间相比 过小,即使在有偏置的情况下,仍有过多的假设与训练实例集相匹配,这 时作出假设的泛化能力将很差。当有过多的假设与训练实例集相匹配,便称为过度拟合(overfit )。 3.2树剪枝 对决策树进行修剪可以控制决策树的复杂程度,避免决策树过于复 杂和庞大。此外, 还可以解决过度拟合的问题。修剪决策树有多种算法,通常分为这样五类。最为常用的是通过预 剪枝(pre-pruning )和后剪枝(post-pruning )完成,或逐步调整树的大小;其次是扩展测试集方法,首先按特征构成是数据驱动还是假设驱动的差别,将建立的特征组合或分割,然后在此基础上引进多变量测试集。第三类方法包括选择不同的测试集评价函数,通过改善连续特征的描述或修改搜索算法本身实现;第四类方法使用数据库约束,即通过削减数据库或实例描述特征集来简化决策树;第五类方法是将决策树转化成另一种数据结构。这些方法通常可以在同另一种算法相互结合中,增强各自的功能。 4决策树在工程中的应用 决策树在工程中的诸多领域获得了非常广泛的应用,主要有以下几个方面: 4.1决策树技术应用于机器人导航 E.Swere 和D .J.M ulvaney 将决策树技术应用于移动机器人导航并取得了一定的成功。 4.2决策树技术应用于地铁中的事故处理 法国的Brezillon 等人成功地将决策树技术应用于地铁交通调度智能系统。他们根据决策树的基本思想开发出上下文图表来帮助驾驶员针对事故做出正确的处理。 4.3决策树技术应用于图像识别 决策树技术应用于包括图像在内的科学数据分析。如利用决策树对上百万个天体进行分类,利用决策树对卫星图像进行分析以估计落叶林和针叶林的基部面积值。 4.4决策树应用于制造业 决策树技术已经成功应用于焊接质量的检测以及大规模集成电路 的设计,它不仅可以规划印刷电路板的布线, 波音公司甚至将它用于波音飞机生产过程的故障诊断以及质量控制。 5决策树技术面临的问题和挑战发展至今,决策树技术面临的问题和挑战表现在以下几个方面:5.1决策树方法的效率亟待提高 数据挖掘面临的数据往往是海量的,对实时性要求较高的决策场所,数据挖掘方法的主动性和快速性显得日益重要。应用实时性技术、主动数据库技术和分布并行算法设计技术等现代计算机先进技术,是数据挖掘方法实用化的有效途径。 5.2适应多数据类型、容噪的决策树挖掘方法随着计算机网络和信息的社会化,数据挖掘的对象已不是关系数据库模型,而是分布、异构的多类型数据库,数据的非结构化程度、噪声等现象越来越突出,这也是决策树技术面临的困难问题。 6结论 决策树技术早已被证明是利用计算机模仿人类决策的有效方法,已经得到广泛的应用,并且已经有了许多成熟的系统。但是,解决一个复杂的数据挖掘问题的任何算法都要面临以下问题:从错误的数据中学习、从分布的数据中学习、从有偏的数据中学习、学习有弹性的概念、学习那些抽象程度不同的概念、整合定性与定量的发现等,因此,还有很多未开 发的课题等待研究。若将决策树技术与其他新兴 摘要:决策树分类学习算法是使用广泛、实用性很强的归纳推理方法之一,在机器学习、数据挖掘等人工智能领域有相当重要的理 论意义与实用价值。在详细阐述决策树技术的几种典型算法以及它的一些常见问题后, 介绍了它在工程上的实际应用,最后提出了它的研究方向以及它所面临的问题和挑战。 关键词:决策树;决策树算法;ID3;C4.5;SLIQ ;SPRINT (下转156页)22··

决策树论文

决策树在学生成绩分析中的应用 摘要:在学校管理工作中,特别是对学生的成绩管理工作中,普遍存在的问题是学生成绩数据量过于庞大,但对这些数据的处理还停留在初级的数据备份、查询及简单统计阶段,并没有对大量的成绩数据进行深入地分析,加以捕捉有利于教学管理工作的信息,这是对教学信息资源极大的浪费。数据挖掘技术正是解决这个问题的可行而有效的方法。 关键词:决策树,学生成绩,数据挖掘 The Application of decision tree in student performance analysis Abstract:In school management, especially for student performance management work, the common problem is the student score data quantity is too big, but for the processing of the data still in the primary stage of data backup, query and simple statistics, not a lot of analysis of performance data, tries to capture is advantageous to the teaching management information, this is a great waste of teaching information resource. Data mining technique is feasible and effective method to solve the problem. Key words:The decision tree, student achievement, data mining

决策树算法分析报告

摘要 随着信息科技的高速发展,人们对于积累的海量数据量的处理工作也日益增重,需发明之母,数据挖掘技术就是为了顺应这种需求而发展起来的一种数据处理技术。 数据挖掘技术又称数据库中的知识发现,是从一个大规模的数据库的数据中有效地、隐含的、以前未知的、有潜在使用价值的信息的过程。决策树算法是数据挖掘中重要的分类方法,基于决策树的各种算法在执行速度、可扩展性、输出结果的可理解性、分类预测的准确性等方面各有千秋,在各个领域广泛应用且已经有了许多成熟的系统,如语音识别、模式识别和专家系统等。本文着重研究和比较了几种典型的决策树算法,并对决策树算法的应用进行举例。 关键词:数据挖掘;决策树;比较

Abstract With the rapid development of Information Technology, people are f acing much more work load in dealing with the accumulated mass data. Data mining technology is also called the knowledge discovery in database, data from a large database of effectively, implicit, previou sly unknown and potentially use value of information process. Algorithm of decision tree in data mining is an important method of classification based on decision tree algorithms, in execution speed, scalability, output result comprehensibility, classification accuracy, each has its own merits., extensive application in various fields and have many mature system, such as speech recognition, pattern recognition and expert system and so on. This paper studies and compares several kinds of typical decision tree algorithm, and the algorithm of decision tree application examples. Keywords: Data mining; decision tree;Compare

分类算法综述

《数据挖掘》 数据挖掘分类算法综述 专业:计算机科学与技术专业学号:S2******* 姓名:张靖 指导教师:陈俊杰 时间:2011年08月21日

数据挖掘分类算法综述 数据挖掘出现于20世纪80年代后期,是数据库研究中最有应用价值的新领域之一。它最早是以从数据中发现知识(KDD,Knowledge Discovery in Database)研究起步,所谓的数据挖掘(Data Mining,简称为DM),就从大量的、不完全的、有噪声的、模糊的、随机的、实际应用的数据中提取隐含在其中的、人们不知道的但又有用的信息和知识的过程。 分类是一种重要的数据挖掘技术。分类的目的是根据数据集的特点构造一个分类函数或分类模型(也常常称作分类器)。该模型能把未知类别的样本映射到给定类别中的一种技术。 1. 分类的基本步骤 数据分类过程主要包含两个步骤: 第一步,建立一个描述已知数据集类别或概念的模型。如图1所示,该模型是通过对数据库中各数据行内容的分析而获得的。每一数据行都可认为是属于一个确定的数据类别,其类别值是由一个属性描述(被称为类别属性)。分类学习方法所使用的数据集称为训练样本集合,因此分类学习又可以称为有指导学习(learning by example)。它是在已知训练样本类别情况下,通过学习建立相应模型,而无指导学习则是在训练样本的类别与类别个数均未知的情况下进行的。 通常分类学习所获得的模型可以表示为分类规则形式、决策树形式或数学公式形式。例如,给定一个顾客信用信息数据库,通过学习所获得的分类规则可用于识别顾客是否是具有良好的信用等级或一般的信用等级。分类规则也可用于对今后未知所属类别的数据进行识别判断,同时也可以帮助用户更好的了解数据库中的内容。 图1 数据分类过程中的学习建模 第二步,利用所获得的模型进行分类操作。首先对模型分类准确率进行估计,例如使用保持(holdout)方法。如果一个学习所获模型的准确率经测试被认为是可以接受的,那么就可以使用这一模型对未来数据行或对象(其类别未知)进行分类。例如,在图2中利用学习获得的分类规则(模型)。对已知测试数据进行模型

利用决策树方法对数据进行分类挖掘毕业设计论文

目录 摘要 (3) Abstract (iii) 第一章绪论 (1) 1.1 数据挖掘技术 (1) 1.1.1 数据挖掘技术的应用背景 (1) 1.1.2数据挖掘的定义及系统结构 (2) 1.1.3 数据挖掘的方法 (4) 1.1.4 数据挖掘系统的发展 (5) 1.1.5 数据挖掘的应用与面临的挑战 (6) 1.2 决策树分类算法及其研究现状 (8) 1.3数据挖掘分类算法的研究意义 (10) 1.4本文的主要内容 (11) 第二章决策树分类算法相关知识 (12) 2.1决策树方法介绍 (12) 2.1.1决策树的结构 (12) 2.1.2决策树的基本原理 (13) 2.1.3决策树的剪枝 (15) 2.1.4决策树的特性 (16) 2.1.5决策树的适用问题 (18) 2.2 ID3分类算法基本原理 (18) 2.3其它常见决策树算法 (20) 2.4决策树算法总结比较 (24) 2.5实现平台简介 (25) 2.6本章小结 (29) 第三章 ID3算法的具体分析 (30) 3.1 ID3算法分析 (30) 3.1.1 ID3算法流程 (30) 3.1.2 ID3算法评价 (33) 3.2决策树模型的建立 (34) 3.2.1 决策树的生成 (34) 3.2.2 分类规则的提取 (377) 3.2.3模型准确性评估 (388) 3.3 本章小结 (39)

第四章实验结果分析 (40) 4.1 实验结果分析 (40) 4.1.1生成的决策树 (40) 4.1.2 分类规则的提取 (40) 4.2 本章小结 (41) 第五章总结与展望 (42) 参考文献 (44) 致谢 (45) 附录 (46)

模式识别--决策树算法报告

决策树算法综述 摘要:决策树是用于分类和预测的一种树结构。本文介绍了决策树算法的基本概念,包括决策树的基本原理、分类方法,发展过程及现状等。详细介绍了基于决策树理论的分类方法,包括ID3算法的基本思想,属性选择度量等。在分析传统的决策树算法的基础之上,引入了属性关注度,提出了一个基于属性选择度量改进的算法。 关键词:决策树;ID3;属性关注度 1.决策树的基本概念 1.1决策树的基本原理 决策树是用于分类和预测的一种树结构。决策树学习是以实例为基础的归纳学习 算法。它着眼于从一组无次序、无规则的实例中推理出决策树表示形式的分类规则。它采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较并根据不同的属 性判断从该节点向下的分支,在决策树的叶节点得到结论。所以从根节点就对应着一 条合取规则,整棵树就对应着一组析取表达式规则。 一棵决策树是一棵有向无环树,它由若干个节点、分支、分裂谓词以及类别组成。节点 是一棵决策树的主体。其中,没有父亲节点的节点称为根节点,没有子节点的节点称为叶子节点,一个节点按照某个属性分裂时,这个属性称为分裂属性。决策树算法构造决策树来 发现数据中蕴涵的分类规则。如何构造精度高、规模小的决策树是决策树算法的核心 内容。决策树构造可以分两步进行。 第一步,决策树的生成。决策树采用自顶向下的递归方式:从根节点开始在每个 节点上按照给定标准选择测试属性,然后按照相应属性的所有可能取值向下建立分枝,划分训练样本,直到一个节点上的所有样本都被划分到同一个类,或者某一节点中的 样本数量低于给定值时为止。这一阶段最关键的操作是在树的节点上选择最佳测试属性,该属性可以将训练样本进行最好的划分。最佳测试属性的选择标准有信息增益、基尼指数、以及基于距离的划分等。 第二步,决策树的剪技。构造过程得到的并不是最简单、紧凑的决策树,因为许 多分枝反映的可能是训练数据中的噪声或孤立点。树剪枝过程试图检测和去掉这种分枝,以提高对未知数据集进行分类时的准确性。树剪枝方法主要有先剪枝和后剪枝。树剪枝方法的剪枝标准有最小描述长度(MDL)和最小期望错误率等。前者对决策树进 行二进位编码,最佳剪枝树就是编码所需二进位最少的树;后者计算某节点上的子树 被剪枝后出现的期望错误率,由此判断是否剪枝。决策树的构造过程如下图所示。

分类算法综述

分类算法综述 1 分类算法分类是数据挖掘中的一个重要课题。分类的目的是学会一个分类函数或分类模型(也常常称作分类器),该模型能把数据库中的数据项映射到给定类别中的某一个。分类可用于提取描述重要数据类的模型或预测未来的数据趋势。分类可描述如下:输入数据,或称训练集(Training Set),是一条条的数据库记录(Record)组成的。每一条记录包含若干个属性(Attribute),组成一个特征向量。训练集的每条记录还有一个特定的类标签(Class Label)与之对应。该类标签是系统的输入,通常是以往的一些经验数据。一个具体样本的形式可为样本向量:(v1,v2,…, vn ;c)。在这里vi表示字段值,c表示类别。分类的目的是:分析输入数据,通过在训练集中的数据表现出来的特性,为每一个类找到一种准确的描述或者模型。这种描述常常用谓词表示。由此生成的类描述用来对未来的测试数据进行分类。尽管这些未来的测试数据的类标签是未知的,我们仍可以由此预测这些新

数据所属的类。注意是预测,而不能肯定,因为分类的准确率不能达到百分之百。我们也可以由此对数据中的每一个类有更好的理解。也就是说:我们获得了对这个类的知识。 2 典型分类算法介绍解决分类问题的方法很多,下面介绍一些经典的分类方法,分析 各自的优缺点。 2.1 决策树分类算法决策树(Decision Tree)是一种有向无环图(Directed Acyclic Graphics,DAG)。决策树方法是利用信息论中 的信息增益寻找数据库中具有最大信息量的属性字段,建立决策树的一个结点,在根据该属性字段的 不同取值建立树的分支,在每个子分支子集中重复 建立树的下层结点和分支的一个过程。构造决策树 的具体过程为:首先寻找初始分裂,整个训练集作 为产生决策树的集合,训练集每个记录必须是已经 分好类的,以决定哪个属性域(Field)作为目前最 好的分类指标。一般的做法是穷尽所有的属性域, 对每个属性域分裂的好坏做出量化,计算出最好的 一个分裂。量化的标准是计算每个分裂的多样性(Diversity)指标。其次,重复第一步,直至每个叶 节点内的记录都属于同一类且增长到一棵完整的树。

决策树论文

决策树ID3算法在学生成绩中的应用 摘要:介绍了数据挖掘中决策树的分类方法和概念,以及著名的ID3算法,同时也介绍了ID3算法在学生成绩中的应用. 关键词:数据挖掘;知识发现;分类;决策树;ID3算法 引言: 随着数据库管理系统在教学工作中的应用,数据库积累的数据越来越多,特别是学生的成绩数据库,数据量过于庞大,但目前对这些数据的处理还只是简单的备份、查询与统计,并没有对大量的成绩数据进行深入的分析,加以捕捉有利于教学工作的信息.因此如何快速而又准确地从浩瀚的成绩数据库中提取出所需信息,就需要一种新的数据分析技术加以处理,数据挖掘技术正是解决这个问题的可行而有效的方法. 1基本原理 1.1数据挖掘基本概念 数据挖掘(Data Mining,简称DM)就是从大量的、不完全的、有噪声的、模糊的、随机的数据中,提取隐含在其中的、人们事先不知道的、但又有潜在的有用信息和知识的过程[1],是数据库中的知识发现(Knowledge Discovery in Databases,简称KDD)的核心.它是涉及数据库、人工智能、机械学、统计学、人工神经网络等的交叉学科.目前,常用的数据挖掘分析方法有:关联规则分析、序列模式分析、分类分析、聚类分析几种,本文选择了分类技术中的决策树用于学生成绩中的数据挖掘. 1.2决策树的分类方法和概念 决策树是通过一系列规则对数据进行分类的过程.它提供一种在什么条件下会得到什么值的类似规则的方法【2 J.它采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较,并根据不同的属性值从该节点向下分支,叶节点是要学习划分的类,从根节点到叶节点的一条路径就对应着一条分类规则,整个决策树就对应着一组析取表达式规则. 1.3ID3算法介绍 决策树归纳的基本算法是贪心算法,它以自顶向下递归的方法构造决策树.著名的决策树归纳算法ID3算法的基本策略如下: (1)树以代表训练样本的单个节点开始. (2)如果样本都在同一个类中,则这个节点成为树叶节点,并用该类标记.

数据挖掘决策树算法概述

决策树是分类应用中采用最广泛的模型之一。与神经网络和贝叶斯方法相比,决策树无须花费大量的时间和进行上千次的迭代来训练模型,适用于大规模数据集,除了训练数据中的信息外不再需要其他额外信息,表现了很好的分类精确度。其核心问题是测试属性选择的策略,以及对决策树进行剪枝。连续属性离散化和对高维大规模数据降维,也是扩展决策树算法应用范围的关键技术。本文以决策树为研究对象,主要研究内容有:首先介绍了数据挖掘的历史、现状、理论和过程,然后详细介绍了三种决策树算法,包括其概念、形式模型和优略性,并通过实例对其进行了分析研究 目录 一、引言 (1) 二、数据挖掘 (2) (一)概念 (2) (二)数据挖掘的起源 (2) (三)数据挖掘的对象 (3) (四)数据挖掘的任务 (3) (五)数据挖掘的过程 (3) (六)数据挖掘的常用方法 (3) (七)数据挖掘的应用 (5) 三、决策树算法介绍 (5) (一)归纳学习 (5) (二)分类算法概述 (5) (三)决策树学习算法 (6) 1、决策树描述 (7) 2、决策树的类型 (8) 3、递归方式 (8) 4、决策树的构造算法 (8) 5、决策树的简化方法 (9) 6、决策树算法的讨论 (10) 四、ID3、C4.5和CART算法介绍 (10) (一)ID3学习算法 (11) 1、基本原理 (11) 2、ID3算法的形式化模型 (13) (二)C4.5算法 (14) (三)CART算法 (17) 1、CART算法理论 (17) 2、CART树的分支过程 (17) (四)算法比较 (19) 五、结论 (24) 参考文献...................................................................................... 错误!未定义书签。 致谢.............................................................................................. 错误!未定义书签。

决策树在购房中的应用(论文)

决策树在购房中的应用 作者:张科 摘要:决策树是一种广泛用于数据分类的方法,也是数据挖掘中常用的方法。而C4.5是决策树算法中最为经典的算法,它与经典的ID3算法相比,将ID3的信息增益改为信息增益比,增加了对连续属性的处理。本文将深入的研究此算法,将此算法应用于购房中的数据挖掘,对收集来的购房数据进行挖掘,得到购房的决策树,实现科学、直观购房的决策。论文以PHP和MySQL实现此数据挖掘。 关键词:决策树;数据挖掘;购房 The Decision Tree application in the purchase house Author:Ke Zhang Abstract:Decision Tree is widely used in the method of data classification,and is commonly used in the method of Data Mining.however, C4.5 Decision Tree algorithm is the most classical algorithm, comparing it with classic ID3 algorithm,will modifies the information gain as the information gain ratio,and increases the processing of the continuous attributes. This article will in-depth researches this algorithm, will apply this algorithm to the Data Mining of the purchase, mines the collected purchase datas,gets the decision tree of the purchase, realizes science, accomplishes the decision of the purchase.This article realizes the Data Mining with PHP and MySQL. Keywords: Decision Tree;DataMining;purchase house. 1问题描述 1.1课题背景及研究意义 近些年来,房地产市场不断升温,房价也是节节攀升。据统计,海南海口住房2006年均价2500元每平方米,2007年上升到3500元每平方米,2008达到平均4300元每平方米,2009年升至5500元每平方米,2010年更是攀升至6700元每每平米的高价。对于普通家庭来说购买一套合适的住房可能是一生中最大的投资,仓促的做出购房决策可能会影响到家庭将来的生活质量与幸福。因此,对于很多家庭来说购房不得不慎重的考虑购房问题,再加上现在房地产市场也在不

C4.5算法概述讲解学习

C4.5算法概述

目录 1 决策树算法 (3) 1.1 具体应用场景和意义 (3) 1.2 现状分析 (5) 2 C4.5算法对ID3算法的改进 (6) 3 C4.5算法描述 (9) 3.1 C4.5算法原理 (9) 3.2 算法框架 (11) 3.3 C4.5算法伪代码 (12) 4 实例分析 (13) 5 C4.5算法的优势与不足 (15) 5.1 C4.5算法的优势 (15) 5.2 C4.5算法的不足: (16) 参考文献 (16)

C4.5算法综述 摘要 最早的决策树算法是由Hunt等人于1966年提出的CLS。当前最有影响的决策树算法是Quinlan于1986年提出的ID3和1993年提出的C4.5。ID3只能处理离散型描述属性,它选择信息增益最大的属性划分训练样本,其目的是进行分枝时系统的熵最小,从而提高算法的运算速度和精确度。ID3算法的主要缺陷是,用信息增益作为选择分枝属性的标准时,偏向于取值较多的属性,而在某些情况下,这类属性可能不会提供太多有价值的信息。C4.5是ID3算法的改进算法,不仅可以处理离散型描述属性,还能处理连续性描述属性。C4.5采用了信息增益比作为选择分枝属性的标准,弥补了ID3算法的不足。 C4.5算法在ID3算法的基础上进行了改进,对于预测变量的缺值处理、剪枝技术、派生规则等方面作了较大的改进,既适合于分类问题,又适合于回归问题,是目前应用最为广泛的归纳推理算法之一,在数据挖掘中收到研究者的广泛关注。 1 决策树算法 1.1具体应用场景和意义 决策树(Decision Tree)是用于分类和预测的主要技术,它着眼于从一组无规则的事例推理出决策树表示形式的分类规则,采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较,并根据不同属性判断从该节点向下分支,在决策树的叶节点得到结论。因此,从根节点到叶节点就对应着一条合理规则,整棵树就对应着一组表达式规则。基于决策树算法的一个最大的优点是

决策树实例计算

计算题 一 1.为生产甲产品,小行星公司设计了两个基本方案:一是建大工厂,二是建小工厂。如果销路好,3年以后考虑扩建。建大工厂需投资300万元,建小工厂需投资160万元,3年后扩建另需投资140万元。扩建后可使用7年,其年度损益值与大工厂相同。每种自然状态的预测概率及年度损益值如下表: 前 3 年 后 7 年 根据上述资料试用决策树法做出决策。 四、计算题(15分)

答:建大厂收益=581-300=281 建小厂收益=447-160=287 所以应选择建小厂方案。 二 山姆公司的生产设备已经落后,需要马上更新。公司有人认为,目前产品销路增长,应在更新设备的同时扩大再生产的规模。但也有人认为,市场形势尚难判断,不如先更新设备,3年后再根据形势变化考虑扩大再生产的规模问题。这样,该公司就面临着两个决策方案。决策分析的有关资料如下: A、现在更新设备,需投资35万元, 3年后扩大生产规模,另需投资40万元。 B、现在更新设备的同时扩大再生产的规模,需投资60万元。 C、现在只更新设备,在销售情况良好时,每年可获利6万元;在销售情况不好时,每年可获利4、5万元。 D、如果现在更新与扩产同时进行,若销售情况好,前3年每年可获利12万元;后7年每年可获利15万元;若销售情况不好,每年只获利3万元。 E、每种自然状态的预测概率如下表

前 3 年 后 7 年 根据上述资料试用决策树法做出决策。 答案:

结点7收益值=0、85×7 × 15+0、15 ×7 ×3=92、4(万元) 结点8收益值=0、85×7 ×6+0、15 ×7 ×4、5=40、4(万元) 结点9收益值=0、1×7 × 15+0、9 ×7 ×3=29、4(万元) 结点10收益值=0、1×7 × 6+0、9 ×7 ×4、5=32、6(万元) 结点1收益值=0、7×[52、4+(3 × 6)]+0、3 ×[32、6+(3 × 4、5)]=63、1(万元) 结点2收益值=0、7×[92、4+(3 × 12)]+0、3 ×[29、4+(3 × 3)]=101、4(万元) 答:用决策树法进行决策应选择更新扩产方案,可获得收益41、4万元。 三 某厂准备生产Y种新产品,对未来的销售前景预测不准,可能出现高需求、中需求、低需求三种自然状态。组织有三个方案可供选择:新建一个车间;扩建原有车间;对原有车间的生产线进行局部改造。三个方案在5年内的经济效益见下表(单位:万元): 0 1 请分别用悲观决策法、乐观决策法、最大最小后悔决策法做出决策。 悲观决策法指当存在几种自然状态的情况下,宁可把情况估计得坏一 些,从中选择一个收益最大的方案,决策稳妥可靠。按此准则,在低需求的自然状态下,5年内新建方案亏损160万,扩建方案保本,改造方案获利80万。改造方案最佳。 乐观决策法: 新建E=(0、7X600)+(1-0、7)X(-160)=372(万元) 扩建E=(0、7X400)+ (1-0、7)X0=280 (万元) 改造E=(0、7X300)+ (1-0、7)X80=234 (万元) 比较结果,新建方案最佳。 最大最小后悔决策,是用后悔值计算表进行计算的: 后悔值计算表

数据挖掘论文数据集决策树分类器论文

数据挖掘论文数据集决策树分类器论文 摘要:本文针对现有的决策树分类算法中,存在若干影响运行效率的因素对避免这种重复等问题进行了探讨,提出了一种基于数据集决策树分类算法,算法使用了扫描一遍数据构建属性统计表组的方法,减小了由于连续属性值过多而使avc过大导致无法放于内存的问题。实验验证测试了本文提出的改进后算法的有效性,从而降低了算法的时间复杂性关键词:数据挖掘;分类器;决策树 research based on data sets and decision tree classifier yang peng (guangzhou panyu polytechnic,school of information engineering,guangzhou511483,china) abstract:this paper first discussed the data-browsing-repetition problem during getting the data statistical information in the stage of building decision tree classifier.based on some new published classifier algorithms,we gave out an ameliorated solution,and realized a decision tree classifier which could be applied to large scale dataset.then some actual simulation testing validated the solution’s