超分辨率算法综述

图像超分辨率算法综述

摘要:介绍了图像超分辨率算法的概念和来源,通过回顾插值、重建和学习这3个层面的超分辨率算法,对图像超分辨率的方法进行了分类对比,着重讨论了各算法在还原质量、通用能力等方面所存在的问题,并对未来超分辨率技术的发展作了一些展望。

关键词:图像超分辨率;插值;重建;学习;

Abstract:This paper introduced the conception and origin of image super resolu- tion technology. By reviewing these three kinds of methods(interpolation,reconstruct, study), it contrasted and classified the methods of image super-resolution,and at last, some perspectives of super-resolution are given.

Key words: image super-resolution;interpolation;reconstruct;study;

1 引言

1.1 超分辨率的概念

图像超分辨率率(super resolution,SR)是指由一幅低分辨率图像(low resolution,LR)或图像序列恢复出高分辨率图像(high resolution,

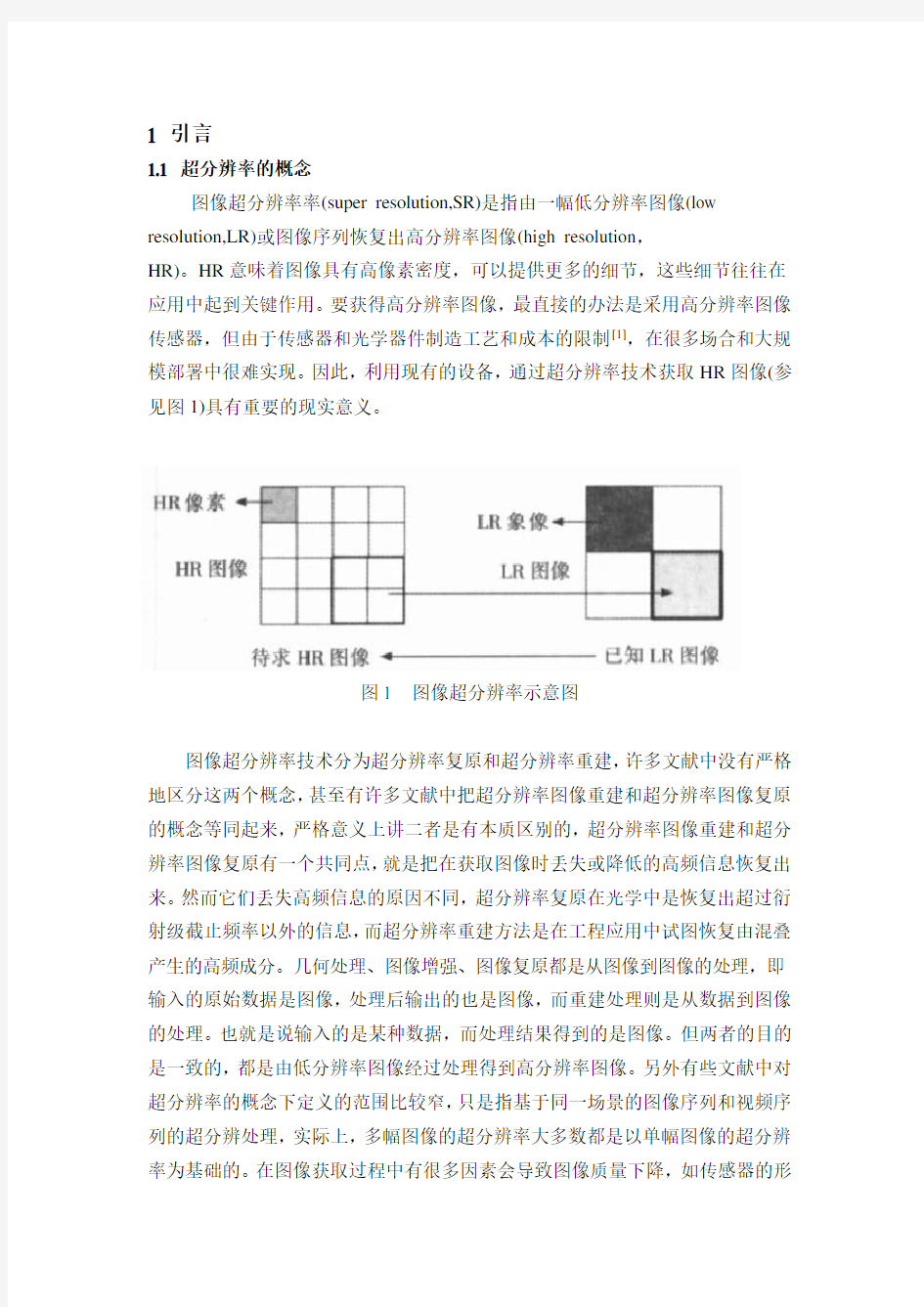

HR)。HR意味着图像具有高像素密度,可以提供更多的细节,这些细节往往在应用中起到关键作用。要获得高分辨率图像,最直接的办法是采用高分辨率图像传感器,但由于传感器和光学器件制造工艺和成本的限制[1],在很多场合和大规模部署中很难实现。因此,利用现有的设备,通过超分辨率技术获取HR图像(参见图1)具有重要的现实意义。

图1 图像超分辨率示意图

图像超分辨率技术分为超分辨率复原和超分辨率重建,许多文献中没有严格地区分这两个概念,甚至有许多文献中把超分辨率图像重建和超分辨率图像复原的概念等同起来,严格意义上讲二者是有本质区别的,超分辨率图像重建和超分辨率图像复原有一个共同点,就是把在获取图像时丢失或降低的高频信息恢复出来。然而它们丢失高频信息的原因不同,超分辨率复原在光学中是恢复出超过衍射级截止频率以外的信息,而超分辨率重建方法是在工程应用中试图恢复由混叠产生的高频成分。几何处理、图像增强、图像复原都是从图像到图像的处理,即输入的原始数据是图像,处理后输出的也是图像,而重建处理则是从数据到图像的处理。也就是说输入的是某种数据,而处理结果得到的是图像。但两者的目的是一致的,都是由低分辨率图像经过处理得到高分辨率图像。另外有些文献中对超分辨率的概念下定义的范围比较窄,只是指基于同一场景的图像序列和视频序列的超分辨处理,实际上,多幅图像的超分辨率大多数都是以单幅图像的超分辨率为基础的。在图像获取过程中有很多因素会导致图像质量下降,如传感器的形

状和尺寸、光学系统的像差、大气扰动、运动、散焦等。另外,在成像、传输、存储过程中,会引入不同类型的噪声,这些都会直接影响到图像的分辨率。此外,数字化采集过程也会影响图像的分辨率,欠采样效应会造成图像的频谱混叠,使获取的图像因变形效应而发生降质。由于军事侦察及医学图像、卫星图像、视频应用及其它许多领域的实际需要,人们对得到的图像的质量要求越来越高。虽然光学元件能有效的限制传感器阵列上的图像频带宽度,使获取的图像又可能避免变形效应的发生。但这要求光学元件与传感器阵列进行有效的组合,而这在实际场合中是很难做到的,同时提升硬件要花费很高的经济成本,图像质量的提高也是有限的,因此,超分辨率图像复原技术就显得更加重要了,其中,图像超分辨率技术是数字图像处理领域中的一个重要分支。随着图像超分辨率理论和技术的日益成熟,图像超分辨率技术的应用更加广泛。本文着重对图像超分辨率方法进行阐述和分析,以向人们展示超图像分辨率技术的发展方向和应用前景。

1.2 图像超分辨率发展的背景及现状

超分辨率概念最早出现在光学领域。在该领域中,超分辨率是指试图复原衍射极限以外数据的过程。Toraldo di Francia在1955年的雷达文献中关于光学成像第一次提出了超分辨率的概念。复原的概念最早是由J.L.Harris和J.w.Goodman 分别于1964年和1965年提出一种称为Harris-Goodman频谱外推的方法。这些算法在某些假设条件下得到较好的仿真结果,但实际应用中效果并不理想。Tsai &Huang首先提出了基于序列或多帧图像的超分辨率重建问题。

1982,D.C.C.Youla和H.Webb在总结前人的基础上,提出了凸集投影图像复原(Pocs)方法。1986年,S.E.Meinel提出了服从泊松分布的最大似然复原(泊松-ML)方法。1991年和1992年,B.R.Hunt和PJ.Sementilli在Bayes分析的基础上,提出了泊松最大后验概率复原(泊松-MAP)方法,并于1993年对超分辨率的定义和特性进行了分析,提出了图像超分辨率的能力取决于物体的空间限制、噪声和采样间隔。

近年来,图像超分辨率研究比较活跃,美国加州大学Milanfar等提出的大量实用超分辨率图像复原算法,Chan等从总变差正则方面,Zhao等、Nagy等从数学方法、多帧图像的去卷积和彩色图像的超分辨率增强方面,对超分辨率图像恢复进行了研究。Chan等研究了超分辨率图像恢复的预处理迭代算法。此外,Elad 等对包含任意图像运动的超分辨率恢复进行了研究;Rajan和Wood等分别从物理学和成像透镜散射的角度提出了新的超分辨率图像恢复方法;韩国Pohang理

工大学对各向异性扩散用于超分辨率。Chung-Ang图像科学和多媒体与电影学院在基于融合的自适应正则超分辨率方面分别进行了研究。

国内许多科研院所和大学等对超分辨率图像恢复进行研究,其中部分是关于频谱外推、混叠效应的消除,其他主要是对国外超分辨率方法所进行的改进,包括对POCS算法和MAP算法的改进,对超分辨率插值方法的改进,基于小波域隐马尔可夫树(HMT)模型对彩色图像超分辨率方法的改进以及对超分辨率图像重构方法的改进。

2 图像超分辨率研究的主要方法

2.1图像超分辨率方法的分类

图像超分辨率按要处理的图像源可分为单幅图像超分辨和多幅图像超分辨。单幅图像超分辨率是指恢复出由于图像获取时丢失的信息(主要是指高频信息),多幅图像超分辨率是指从低分辨率的图像序列恢复出高分辨率的图像。基于序列或多幅图像的超分辨率增强就是利用这些不同,但相互补充的信息以及目标的先验信息,从一系列低分辨率的图像恢复出高分辨率的单幅图像。该思想与前述的单幅图像超分辨率方法相比,其优点是除了利用物体的先验信息和单幅图像的信息之外,还充分利用了不同图像之间的补充信息,因此,其超分辨率增强能力高于单幅图像超分辨率方法。但是在实际应用中,获得同一场景的图像序列常常是很困难,例如在未来高技术局部战争条件下,战场环境瞬息万变,战场信息稍纵即逝,因此给军事侦察提出了更高的要求,在这种情况下,要想获得同一场景的多幅图像很难,因此,单幅图像的超分辨率技术就显得尤为重要。同时,多幅图像的超分辨率方法大多都是以单幅图像的超分辨率为基础的,只有对单幅图像的超分辨率图像进行更广泛深入地研究,多幅图像的超分辨率技术才能有更广阔的前景。目前,单幅图像的超分辨率研究较少,多幅图像超分辨率已经成为研究的热点,就是因为多幅图像比单幅图像所含的可利用的信息量大。

图像超分辨率按实现的具体方法主要可分为空域法和频域法。频域方法是在频域上消除频谱混叠,改善空间分辨率;空间域方法是在图像像素的尺度上,通过对图像像素点的变换、约束而改善图像质量的方法。

频率域方法是图像超分辨率中的一类重要方法。目前比较流行的是能量连续降减法和消混叠重建方法。消混叠重建方法是通过解混叠而改善影像的空间分辨率实现超分辨率。中国科学院遥感应用研究所从分辨率低的欠采样图像会导致相

应空间频率域频谱混叠的理论出发,给出了多次欠采样图像在频率域混叠的更一般的公式,并给出一种针对不同分辨率图像解频谱混叠的逐行迭代方法,该方法在有噪声的情况下也具有很好的收敛性,取得了很好的效果。

频域方法实际上是在频域内解决图像内插问题,其观察模型是基于傅里叶变换的移位特性。频域方法基于以下三条基本性质:(1)傅里叶变换的平移特性。(2)连续傅里叶变换和离散傅里叶变换之间的混叠关系。(3)原始场景的带宽有限。频域方法理论简单,运算复杂度低,很容易实现并行处理,具有直观的去变形超分辨率机制。但这类方法的缺点是所基于的理论前提过于理想化,不能有效地应用于多数场合,只能局限于全局平移运动和线性空间不变降质模型,包含空域先验知识的能力有限。

空域方法的适用范围较广,具有很强的包含空域先验约束的能力,主要包括迭代反投影方法(IBP)、集合论方法(如凸集投影:POCS)、统计复原方法(最大后验概率估计MAP 和最大似然估计ML),混合MAP/POCS 方法以及自适应滤波方法,人工神经网络法、基于非均匀采样的插值法、基于最优化技术的方法等。其中,非均匀样本内插方法、迭代反投影方法等结合先验信息的能力很弱,在改善图像超分辨率效果方面受到了一定的限制。因此,研究和应用较多的是凸集投影方法和最大后验概率估计方法。下面重点介绍几种常用的超分辨率方法的特点。

2.2 几种常用的图像超分辨率方法

2.2.1 超分辨率系统模型及技术概述

对超分辨率问题的求解,通常是构造一个前向关系模型,低分辨率图像和高分辨率图像之间的关系可以表述为

,,1,,p k j n x M DB y j j j k j k ≤≤+= (1)

其中,p 为图像序列帧数,j x 、k y 和j n 分别为待求的第j 帧高分辨率图像、第k 帧观察到的低分辨率图像和图像获取时的噪声,矩阵D 、j B 和j k M ,分别为下采样矩阵、模糊矩阵和第j 帧和第k 帧之间运动矢量所构成的运动矩阵。关于模糊矩阵和运动矩阵的先后关系,WANG Z Z 等[2]指出,如果更换两者的位置会引起系统误差。设H=DBM ,则式(1)即可简化为

n Hx y += (2) 求解式(2)需要确定H ,也就是求解或者确认式(1)中的D 、B 、M 和噪声n ,这包括以下几个问题:(1)运动估计,需要从观察到的低分辨率图像得到精确的

运动矢量,并使用插值等方法去近似高分辨率图像的运动矢量;(2)图像模糊的估计,通常需要对点扩散函数进行计算或假设;(3)噪声估计,噪声会极大地影响系统的求解,对于噪声的估计是非常重要的一步。

SR 技术在早期研究中仅指基于多幅图像的还原方法,将基于单幅图像的增强称为插值,而目前多数文献中将这2种情况均称为超分辨率。超分辨率技术自Tsai 和Huang 提出利用多帧图像序列来恢复高分辨率图像以来,至今已有二十余年,其间大量算法被提出。目前,图像超分辨率研究可分为3个主要范畴:基于插值、基于重建和基于学习的方法。

2.2.2 基于插值的方法

基于多帧图像插值技术的方法是超分辨率研究中最直观的方法。这类方法首先估计各帧图像之间的相对运动信息,获得HR 图像在非均匀间距采样点上的像素值,接着通过非均匀插值得到HR 栅格上的像素值,最后采用图像恢复技术来去除模糊和降低噪声。典型的方法包括:Rajan 和Chaudhuri 通过分解、插值和融合3个步骤实现的通用插值方法;TAOHJ 等提出的小波域的双线性插值;Lertrattanapanich 和Bose 提出的使用基于光滑性约束的Delaunay 三角化插值算法等。这类方法的优点是算法快速易行,适合并行计算,基本可以满足实时要求,但因为不能引入额外有用的高频信息,因而很难在SR 图像中得到锐化的效果,同时,也没有考虑到LR 图像的像素值并不是HR 图像的理想采样值,而是对HR 图像像素值的空间平均和卷积效应这一事实。

2.2.3 基于重建的方法

(1) 凸集投影法(POCS)

Stark 和Oskoui [3]最早提出的凸集投影方法可以简单而有效地求解超分辨率问题,通过把高分辨率图像的解空间上与一系列的代表高分辨率图像性质的约束集(如非负性、能量有界性、观测数据一致性、局部光滑性等)相交,可以得到一个更小的解空间。从高分辨率图像空间的一点出发,不断利用迭代投影的方法寻找满足所有约束凸集的下一点,最终获得高分辨率图像的估计。对于初始值0

x ,设每一个约束集定义一个凸集投影算子k P ,则计算过程为

0123...x P P P P x N n (3) 凸集投影法的优点在于算法简单,能够充分利用先验知识。但是缺点在于解不惟一,收敛过程依赖初值的选择,解不稳定。

(2) 贝叶斯分析方法

贝叶斯分析法包括最大后验概率估计法(MAP)和最大似然估计法(ML),最大后验概率估计方法的优点是在解中可以直接加入先验约束、能确保解的存在和唯

一、降噪能力强和收敛稳定性高等。缺点是收敛慢和运算量大。另外,最大后验概率估计方法的边缘保持能力不如凸集投影方法,由这类方法获得的高分辨率图像上的细节容易被平滑掉。

(3) 迭代反投影法(IBP)

Irani 和Peleg [4]提出的迭代反向投影法是超分辨率图像复原中具有代表性的一种方法。首先估计一个高分辨率图像作为初始解0x ,通常采用单幅低分辨率图像的插值结果。然后根据系统模型,计算其模拟低分辨率图像:

n Hx y +=00 (4) 如果0

x 与原始高分辨率图像精确相等,并且若式(4)模拟的成像过程符合实际情况,则模拟低分辨率序列0y 应与观察得到的实际低分辨率图像y 相同。当两者不同时,将它们之间的误差0y y -反向投影到0x 上使其得到修正: )(001y y H x x BP -+= (5) 当误差满足要求时,迭代结束,Irani 和Peleg 证明了算法是收敛的。算法简单、直观。但是,BP H 较难选择,并且没有能够利用到先验知识,解不稳定、不惟一。

(4) 最大后验概率方法

Schultz 和Stevenson [5]提出的MAP 方法是典型的概率论方法,他们把高分辨率图像和观察得到的低分辨率图像当作两个不同的随机过程。根据MAP 准则:

)]|[Pr(max arg y x x x m ap = (6) 使用条件概率对式(6)进行变形、取负对数并舍弃常数项,可得

)]Pr(log )|Pr(log [arg x x y mix x x m ap --= (7) 其中,高分辨率图像的先验模型)(x P r 可以由图像的先验知识确定,通常采用的MRF 模型使图像的局部在光滑性和边缘保持上同时获得了比较好的效果,条件概率密度)|(x y P r 则由系统的噪声统计量确定。

其它还有基于高斯先验假设和动态树推理算法等。MAP 方法的优点在于有惟一解,如果有合理的先验假设可以获得非常好的图像边缘效果。但是其显著的缺点就在于计算量相对比较大。

(5) 正规化法

Nguyen [6]等提出的正则有参超分辨率图像恢复把模糊矩阵C 表示为带参数σ的B(σ),对应地将H 表示为H(σ),则系统模型式(2)改写为:

n x H y +=)(σ (8) 正则有参超分辨率恢复采用恒定正则算子,使用一个最优正则参数,构造关于图像模糊参数σ、正则参数λ和高分辨率图像x 的Tikhonov 最小化能量泛函,形成正则超分辨率恢复模型:

]||||||)([||},,{222

2min arg x x H y x λσλσ+-= (9)

Nguyen 等采用广义交叉验证(GCV)的参数估计方法确定参数σ和λ,最后使用预处理共轭梯度法(PCG)求解式(9)导出的线性方程:

y H x H H H T T =+-1)( (10) 正则化算法的优点在于不要求点扩散函数(PSF)为圆形,也不需要对图像和噪声做任何统计假设,但是正则化项在抑制噪声的同时也抑制了图像的细节,容易产生过于平滑的效果。

(6) 混合方法

通过最小化有特定集合约束的最大后验概率/最大似然估计(MAP/ML)的损失函数,得到高分辨率图像的估计就是最大后验概率/最大似然估计/凸集投影(MAP/ML/POCS)混合方法。Schultz 和Stevenson 最早将MAP 优化与投影约束相结合,后来Elad 和Feuer 提出了一种通用的最大似然估计/凸集投影(ML/POCS)超分辨率方法:

}1,{]},[][][]{[min 2M k C x Sx V Sx Hx y W Hx y k T T ≤≤∈+--=βε (11)

其中,W 为噪音的自相关函数,S 为Laplacian 算子,V 为控制光滑程度的加权矩阵,k C 为其他的非椭圆约束。

混合方法结合了MAP 和POCS 各自的优点,充分利用了先验知识并且收敛的稳定性也比较好,是目前为止最好的基于重建的算法。

上述介绍的6类常用的基于重建的超分辨率方法,共同的优点是只需要一些局部性的先验假设,就能在一定程度上缓解了插值方法所产生的模糊或者锯齿效果。但缺点也是显而易见的:当抽取率较大(如4倍以上)时,获取准确的亚像素运动信息是不现实的,且不准确的运动信息对重建效果影响很大。鉴于亚像素的配准困难,不少文献中都假设已经获得准确的亚像素精度的运动。即便假设已获得准确的亚像素运动信息,当抽取率较大时,重建效果通常也不太理想,主要原因是重建过程中能够使用的先验知识太少,低分辨率图像提供的信息不满足高分辨率需求。

2.2.4 基于学习的方法

基于学习的方法是近年来超分辨率算法研究的热点方向。其基本思路是通过给定的训练图像集,计算测试样本的patch与训练图像集patches之间的邻域关系,并构造最优权值约束,来获得先验知识并逼近测试样本的高分辨率图像。当低分辨率数据提供的信息不满足高分辨率需求时,基于学习的方法可以获得更多的图像高层信息,因而具有很大优势,在图像超分辨率应用中可能得到比较理想的结果,为在大抽取率情况下恢复必要的高频信息给出了新的思路。基于学习的方法认为,低分辨率的图像已经拥有充分的用于推理预测其所对应的高分辨率部分(例如边缘等)的信息,通过对一组同时包括高分辨率图像和低分辨率图像的训练集合的训练,学习到一个联合的系统模型。这个模型的表现形式可以是一组学习到的插值核、一个低分辨率patch的查找表、低分辨率patch与高分辨率patch 之间的映射系数等。

(1) Example-based方法

Freeman[7]等首次使用Markov网络对图像的空间关系进行建模,他把图像分成一些5×5或7×7的小块,成为patch,通过学习,获得表示高分辨率patch 之间的转移概率矩阵Ψ和表示高分辨率patch和低分辨率patch之间的转移概率矩阵Φ。对于一个给定的测试图像,同样把它分割成patch之后,对于每一个patch 在寻找它在Markov网络中的位置,同时获得它与一些高分辨率patch之间的关系,再根据训练得到的转移概率把高频分量添进去。

Example-based方法是较早提出使用学习的方法实现超分辨率,相对于之前的基于插值和基于重建的方法,这种方法可以获取丰富的高频信息,在放大4倍时,仍能获得较高的图像质量。但缺点也比较明显,训练样本的选择要求比较高,并且对于图像中的噪声极为敏感。

(2) 邻域嵌入方法(neighbor embedding)

Chang等首次提出了基于邻域嵌入的图像超分辨率方法,其假定了高分辨率和对应的低分辨率图像块在特征空间可以形成具有相同局部几何结构的流形。首先通过训练得到高分辨率patch和低分辨率patch的流形,接着对于测试样本中的每一个patch,寻找其在低维流形中的k近邻表示,最后使用这些系数加权得到其在高维流形中patch的估计,即高分辨率patch.但是,高低分辨率块在邻域嵌入时并不是总具有邻域保持,要提高邻域保持,有2个可能的途径:一个是选择更合理的描述图像块的特征,以便能更好地保持邻域关系,一个是给定高分辨率邻域块,选择更好的重建函数。因此,为了改进邻域嵌入方法的不足,张军平

提出了基于直方图匹配的训练样本选择算法,基于残差局部嵌入的方法和基于边缘检测和特征选择的方法。

相对于Example-based的方法,邻域嵌入的方法需要较少的训练样本,并且对于噪声的敏感度不是非常强。

(3) 支持向量回归方法(SVR)

Karl和Nguyen等提出了使用支持向量回归实现图像的超分辨率,他们通过加入一些额外的约束条件把kernel学习由半正定规划问题转化为二次规划问题求解。对于测试数据,则先对图像patch进行内容分类,再在其所属的类中做支持向量回归,得到高分辨率patch。

SVR方法实现了对样本的自动选择,训练集较小,并且该算法在频域中同样适用。但是从实验结果来看,图像的对比度有所下降。

(4) 虚幻脸(hallucination face)

Baker和Kanade最早提出仅对人脸做超分辨率,他们的复原算法采用从训练patch数据库中查询与测试低分辨率patch最相近的作为输出,并且取得了8倍的放大效果。

LIUC等通过主成分分析(PCA)估计一个全局的脸而后采用非参数的局部模型进行拟合。同样采用特征脸表示的还有文献。另外,还有一些工作是针对人脸视频做超分辨率,其中Dedeoglu等的算法在特定的人脸库中甚至取得了16倍的放大效果。相对于其他的超分辨率技术,虚幻脸由于增加了人脸这个非常重要的先验条件,使得超分辨率的质量大幅提高,但是如果针对通用人脸(更多的表情、更多的人种和更广的年龄分布),目前的算法就只能获得4倍左右的放大效果。

(5) 稀疏表示法(sparse presentation)

最近,Yang[8]等提出了使用图形patch的稀疏表示来实现超分辨率。他们从一些高分辨率图像中随机选取一些patch组成一个过完备的词典(overcomplete dictionary),接着对于每一个测试patch,通过线性规划的方法求得该测试patch 在这个过完备的词典下的稀疏表示,最后以这组系数加权重构出高分辨率的图像。

这种方法克服了邻域嵌入方法中对于邻域大小的选择问题,即在求解稀疏表示的时候,无需指定重构所需要基的个数,其表示系数和基的个数将同时通过线性规划求解得到。然而,目前该方法的缺陷就在于过完备词典的选择,随机的选择只能实现特定领域的图像的超分辨率,对于通用图像的超分辨率效果较差。

3 图像超分辨率的发展前景

图像超分辨率在视频、遥感、医学和安全监控等领域具都有十分重要的应用,另外其应用也逐步涉及到其它各个领域。在高清数字电视方面采用超分辨率技术会进一步减少成本,提高画面的质量。超分辨率技术在采集军事与气象遥感图像应用可实现高于系统分辨率的图像观测。在医学成像系统中(如CT、MRI和超声波仪器等),可以用图像超分辨率技术来提高图像质量,对病变目标进行仔细的检测。在银行、证券等部门的安全监控系统中,当有异常情况发生后。可对监控录像进行超分辨率重建,提高图像要害部分的分辨率,从而为事件的处理提供重要的线索。在未来超分辨技术广泛的应用前景必然会推动这一技术不断发展。

为了获得高质量的高分辨率的图像,满足不同情况下的实际应用要求,未来的发展主要集中在以下几个方面:

(1) 精确有效的运动估计算法[9]。图像的运动变形、模糊和噪声等降质因素具有密切的关系,在图像超分辨率增强中,需要对图像序列进行亚像素精度的运动估计。由于运动估计只能利用低分辨率序列上的信息,所以很难达到精确的运动估计。虽然目前已经有很多比较成熟的运动估计方法,但在实际应用场合仍然无法获得令人满意的运动补偿效果,同时这些方法的适用场合非常有限,需要发展和寻求新的运动模型,对运动进行精确估计。

(2) 针对视频压缩格式和编解码技术,在图像超分辨率算法中综合考虑成像模型和压缩算法带来的图像污染效果,以及运动补偿和编码传输机制,提高压缩视频的超分辨率能力。

(3) 完善现有算法,不断发展新的算法。目前的很多图像超分辨率算法在一定程度上解决了实际应用中存在的问题,但这些方法仍然存在着较大的缺陷和不足。所以在超分辨率算法方面,还需要进一步提高超分辨率图像增强的能力,减小计算量,加快运算的收敛速度,适用于不同的图像要求。

(4) 在应用范围上将不局限于单色和单张高分辨率图像的恢复,还要扩展到多通道和彩色图像、三维立体成像、动态多媒体序列、压缩图像、CCD阵列成像和核磁共振成像的超分辨率恢复与增强。

(5) 提高算法的效率,目前已有的超分辨率算法很多,不少算法的效果还是不错的,但由于算法复杂度高,运算量大,因此实用性不强。

(6)盲重建。很多算法都假设模糊函数(PSF函数)已知,但是在实际中,准确

的估计PSF函数有一定的困难,通常都只能知道PSF函数的部分信息,因此,盲重建也是一个重要的研究方向。

4结束语

随着图像超分辨率技术的进一步发展必将导致这一技术拓宽到一些新的应用领域,图像超分辨率技术更广泛地应用会进一步加快该技术的发展。此外,超分辨率技术的理论研究结果还可为未来我国

新型传感器的硬件设计与实现提供理论指导与参考,图像超分辨率技术会有更广阔的前景。

参考文献:

[1] KANG M, CHAUDHURIS. Super-resolution image reconstruction[J].

IEEE Signal Processing Magazine, 2003,20(3).

[2] WANG Z Z, QI F H. On ambiguities in super-resolution modeling[J].

Signal Processing Letters, 2004, 11(8).

[3] STARK H, OSKOUI P. High-resolution image recovery from image-

plane arrays, using convex projections[J]. Journal of the O-

ptical Society of America A, 1989, 6.

[4] IRANI M, PELEG S. Super resolution from image sequences[J].

ICPR-C, 1990.

[5] SCHULTZ R, STEVENSON R. Video resolution enhancement[C]//I-

mage and Video Processing III, Proceedings of the SPIE. San Jose, CA: Society of Photo Optical Instrumentation Engineers, 1995:23-24.

[6] NGUYEN N, MILANFAR P, GOLUB G. Efficient generalized cross

validation with applications to parametric image restoration and reso- lution enhancement[J]. IEEE Trans Image Processing,2001,10(9). [7] FREEMAN W T, JONES T R, PASZTOR E C. Example based super-

Resolution[J]. IEEE Computer Graphics and Applications,2002,22(2)

[8] YANG J C, WRIGHT J, MA Y. Image super-resolution as sparse repr-

esentation of raw image patches[C]

[9] 苏秉华,金伟其.超分辨率影像复原及其进展[J]. 光学技术, 2001,

21(7):6-9.

超分辨率图像重建方法综述_苏衡

第39卷第8期自动化学报Vol.39,No.8 2013年8月ACTA AUTOMATICA SINICA August,2013 超分辨率图像重建方法综述 苏衡1,2周杰1张志浩1 摘要由于广泛的实用价值与理论价值,超分辨率图像重建(Super-resolution image reconstruction,SRIR或SR)技术成为计算机视觉与图像处理领域的一个研究热点,引起了研究者的广泛关注.本文将超分辨率图像重建问题按照不同的输入输出情况进行系统分类,将超分辨率问题分为基于重建的超分辨率、视频超分辨率、单帧图像超分辨率三大类.对于其中每一大类问题,分别全面综述了该问题的发展历史、常用算法的分类及当前的最新研究成果等各种相关问题,并对不同算法的特点进行了比较分析.本文随后讨论了各不同类别超分辨率算法的互相融合和图像视频质量评价的方法,最后给出了对这一领域未来发展的思考与展望. 关键词超分辨率图像重建,计算机视觉,图像处理,方法综述 引用格式苏衡,周杰,张志浩.超分辨率图像重建方法综述.自动化学报,2013,39(8):1202?1213 DOI10.3724/SP.J.1004.2013.01202 Survey of Super-resolution Image Reconstruction Methods SU Heng1,2ZHOU Jie1ZHANG Zhi-Hao1 Abstract Because of its extensive practical and theoretical values,the super-resolution image reconstruction(SRIR or SR)technique has become a hot topic in the areas of computer vision and image processing,attracting many researchers attentions.This paper categorizes the SR problems according to their input and output conditions into three main cat-egories:reconstruction-based SR,video SR and single image SR.For each category,the development history,common algorithm classes and state-of-the-art research achievements are reviewed comprehensively.We also analyze the charac-teristics of di?erent algorithms.Afterwards,we discuss the combination of di?erent super-resolution categories and the evaluation of image and video qualities.Thoughts and foresights of this?eld are given at the end of this paper. Key words Super-resolution image reconstruction,computer vision,image processing,survey Citation Su Heng,Zhou Jie,Zhang Zhi-Hao.Survey of super-resolution image reconstruction methods.Acta Auto-matica Sinica,2013,39(8):1202?1213 超分辨率图像重建(Super resolution image re-construction,SRIR或SR)是指用信号处理和图像处理的方法,通过软件算法的方式将已有的低分辨率(Low-resolution,LR)图像转换成高分辨率(High-resolution,HR)图像的技术.它在视频监控(Video surveillance)、图像打印(Image printing)、刑侦分析(Criminal investigation analysis)、医学图像处理(Medical image processing)、卫星成像(Satellite imaging)等领域有较广泛的应用. 收稿日期2011-08-31录用日期2013-01-29 Manuscript received August31,2011;accepted January29, 2013 国家自然科学基金重大国际(地区)合作研究项目(61020106004),国家自然科学基金(61005023,61021063),国家杰出青年科学基金项目(61225008),教育部博士点基金(20120002110033)资助 Supported by Key International(Regional)Joint Research Pro-gram of National Natural Science Foundation of China(6102010 6004),National Natural Science Foundation of China(61005023, 61021063),National Science Fund for Distinguished Young Scholars(61225008),and Ph.D.Programs Foundation of Min-istry of Education of China(20120002110033) 1.清华大学自动化系北京100084 2.北京葫芦软件技术开发有限公司北京100084 1.Department of Automation,Tsinghua University,Beijing 100084 2.Beijing Hulu Inc.,Beijing100084 超分辨率问题的解决涉及到许多图像处理(Im-age processing)、计算机视觉(Computer vision)、优化理论(Optimization problem)等领域中的基本问题[1],例如图像配准(Image registration)、图像分割(Image segmentation)、图像压缩(Image com-pression)、图像特征提取(Image feature extrac-tion)、图像质量评价(Image quality estimation)、机器学习(Machine learning)、最优化算法(Opti-mization algorithm)等,超分辨率是这些基本问题的一个具体应用领域,同时也对它们的研究进展起到了推动的作用.因此超分辨率问题本身的研究具有重要的理论意义.目前超分辨率问题已经成为相关研究领域的热点之一. 在上世纪80~90年代,就有人开始研究超分辨率图像重建的方法,1984年Tsai的论文[2]是最早提出这个问题的文献之一.在这之后有很多相关的研究对超分辨率的问题进行更加深入的讨论.有关超分辨率问题的研究成果,在计算机视觉、图像处理与信号处理领域的顶级会议和期刊都有大量收录. 1998年,Borman等[3]发表了一篇超分辨率图像重建的综述文章.2001年,Kluwer出版了一本详细介

提高显微镜分辨率的方法简述

目录 1 选题背景 (1) 2 方案论证及过程论述 (1) 2.1 像差 (1) 2.1.1 球面像差 (1) 2.1.2 慧形像差 (2) 2.1.3 色像差 (2) 2.2 照明对显微镜分辨率的影响 (2) 2.2.1 非相干光照明 (2) 2.2.2 相干光照明 (2) 2.2.3 部分相干光照明 (3) 2.2.4 临界照明 (3) 2.3 衍射 (3) 2.3.1 对两个发光点的分辨率 (3) 2.3.2 对不发光物体的分辨率 (4) 2.4 光噪声 (6) 3 结果分析 (6) 4 结论 (7) 4.1 提高光学显微镜与电子显微镜分辨率的方法 (7) 4.1.1 提高光学显微镜分辨率的方法 (7) 4.1.2 如何提高电子显微镜分辨率 (7) 参考文献 (9)

1 选题背景 显微镜是实验室最重要的设备之一,对观察微小物体细节的显微镜来说,评价光学显微镜及电子显微镜的重要指标之一是分辨本领。显微镜的分辨能力是指其分辨近距离物体细微结构的能力,它主要是显微镜的性能决定。通常是以显微镜的分辨率级即显微镜能分辨开两个物点的最小距离d来表示,d值越小,则显微镜的分辨能力越强。 人眼本身就是一台显微镜,在标准照明条件下,人眼在明视距离(国际公认为25cm)上的分辨率约等于1/10mm。对于观察两条直线来说,由于直线能刺激一系列神经细胞,眼睛的分辨率还能提高一些,这就是显微镜的分划板使用双线对准的原理所在。人眼的分辨率只有1/10mm,那么比1/10mm小的物体或比1/10mm近的两个微小物体的距离,人眼就无法分辨了。这时人们开始研制出放大镜和显微镜,显微镜的分辨率计算公式为:d=0.61入/NA;式中:d为分辨率(μm);入为光源波长(μm);NA为物镜的数值口径(也称镜口率)。 造成显微镜光学像欠缺的因素主要在物镜组,有像差、衍射和光噪声等,它们是影响显微镜分辨率的主要因素,其次照明对显微镜的分辨率也有一定的影响。 对于显微镜的使用者来讲,应该对造成显微镜分辨率下降的因素有比较清楚的认识,并知道克服和减少这些因素的方法。本文从几何像差、色像差、衍射、干涉和照明几个方面分析了对显微镜分辨率的影响,指出了孔径数的增加,从衍射角度看对显微镜分辨率的提高有好处,但从几何像差的角度看则会降低显微镜的分辨率;并指出了照明对显微镜分辨率的影响是不可忽略的等。 2 方案论证及过程论述 2.1 像差 像差可分为单色像差和色像差两大类。单色像差有五种:(1)球面像差;(2)彗形像差;(3)像散;(4)像场弯曲;(5)畴变。其中(1)和(2)是由大孔径引起的,(3)、(4)、(5)是由大视场引起的。显微镜需要大孔径,但不需要大视场,所以显微镜的单色像差主要是(1)和(2)。 2.1.1 球面像差 单球面公式只有在满足近轴光线的条件下才能成立。当孔径较大时,有许多远轴光线也进入了透镜,近轴光线和远轴光线经透镜折射后不能在同一点上会聚。换句话说,主轴上一物点经透镜成像后,像不是一个点,而是一个圆斑,这样就产生了球面像差。消除的方法有二:一是在透镜前加一光阑,用以限制远轴光线的进入。这样做,会使显微镜的孔径数降低,从而降低了显微镜的分辨率。二是用复合透镜法,显微镜物镜就是采用这种方法制作的。

群智能优化算法综述

现代智能优化算法课程群智能优化算法综述 学生姓名: 学号: 班级: 2014年6月22日

摘要 工程技术与科学研究中的最优化求解问题十分普遍,在求解过程中,人们创造与发现了许多优秀实用的算法。群智能算法是一种新兴的演化计算技术,已成为越来越多研究者的关注焦点,智能优化算法具有很多优点,如操作简单、收敛速度快、全局收敛性好等。群智能优化是智能优化的一个重要分支,它与人工生命,特别是进化策略以及遗传算法有着极为特殊的联系。群智能优化通过模拟社会性昆虫的各种群体行为,利用群体中个体之间的信息交互和合作实现寻优。本文综述群智能优化算法的原理、主要群智能算法介绍、应用研究及其发展前景。 关键词:群智能;最优化;算法

目录 摘要 (1) 1 概述 (3) 2 定义及原理 (3) 2.1 定义 (3) 2.2 群集智能算法原理 (4) 3 主要群智能算法 (4) 3.1 蚁群算法 (4) 3.2 粒子群算法 (5) 3.3 其他算法 (6) 4 应用研究 (7) 5 发展前景 (7) 6 总结 (8) 参考文献 (9)

1 概述 优化是人们长久以来不断研究与探讨的一个充满活力与挑战的领域。很多实际优化问题往往存 在着难解性,传统的优化方法如牛顿法、共扼梯度法、模式搜索法、单纯形法等己难以满足人们需求。 因此设计高效的优化算法成为众多科研工作者的研究目标。随着人类对生物启发式计算的研究, 一些社会性动物( 如蚁群、蜂群、鸟群) 的自组织行为引起了科学家的广泛关注。这些社会性动物在漫长的进化过程中形成了一个共同的特点: 个体的行为都很简单, 但当它们一起协同工作时, 却能够“突现”出非常复杂的行为特征。基于此,人们设计了许多优化算法,例如蚁群算法、粒子群优化算法、混合蛙跳算法、人工鱼群算法,并在诸多领域得到了成功应用。目前, 群智能理论研究领域主要有两种算法: 蚁群算法(Ant Colony Optimization, ACO) 和粒子群优化算法(ParticleSwarm Optimization, PSO)。 2 定义及原理 2.1 定义 群集智能优化算法源于对自然界的生物进化过程或觅食行为的模拟。它将搜索和优化过程模拟成个体的进化或觅食过程,用搜索空间中的点模拟自然界中的个体;将求解问题的目标函数度量成个体对环境的适应能力;将个体的优胜劣汰过程或觅食过程类比为搜索和优化过程中用好的可行解取代较差可行解的迭代过程。从而,形成了一种以“生成+检验”特征的迭代搜索算法,是一种求解极值问题的自适应人工智能技术。各类优化算法实质上都是建立问题的目标函数,求目标函数的最优解,因而实际工程优化问题均可转化为函数优化问题。其表达形式如下: 求: ,,2,1,0)(..), (min , ,,2,1,),,,(21Lm j X g t s X f n L i x L x x X i T n i =≤== 。Ω∈X 其中, i X 为设计变量;)(X f 为被优化的目标函数;0)(≤X g j 为约束函数;Ω为设计变量的 可行域。

超分辨率算法综述

超分辨率复原技术的发展 The Development of Super2Re solution Re storation from Image Sequence s 1、引言 在图像处理技术中,有一项重要的研究内容称为图像融合。通常的成像系统由于受到成像条件和成像方式的限制,只能从场景中获取部分信息,如何有效地弥 补观测图像上的有限信息量是一个需要解决的问题。图像融合技术的含义就是把相关性和互补性很强的多幅图像上的有用信息综合在一起,产生一幅(或多幅) 携带更多信息的图像,以便能够弥补原始观测图像承载信息的局限性。 (图象融合就是根据需要把相关性和互补性很强的多幅图象上的有用信息综合在一起,以供观察或进一步处理,以弥补原始单源观测图象承载信息的局限性,它是一门综合了传感器、图象处理、信号处理、计算机和人工智能等技术的现代高新技术,于20 世纪70 年代后期形成并发展起来的。由于图象融合具有突出的探测优越性,在国际上已经受到高度重视并取得了相当进展,在医学、遥感、计算机视觉、气象预报、军事等方面都取得了明显效益。从图象融合的目标来看,主要可将其归结为增强光谱信息的融合和增强几何信息的融合。增强光谱信息的融合是综合提取多种通道输入图象的信息,形成统一的图象或数据产品供后续处理或指导决策,目前在遥感、医学领域都得到了比较广泛的应用。增强几何信息的融合就是从一序列低分辨率图象重建出更高分辨率的图象(或图象序列) ,以提 高图象的空间分辨率。对图象空间分辨率进行增强的技术也叫超分辨率 (super2resolution) 技术,或亚像元分析技术。本文主要关注超分辨率(SR) 重建技术,对SR 技术中涉及到的相关问题进行描述。) (我们知道,在获取图像的过程中有许多因素会导致图像质量的下降即退化,如 光学系统的像差、大气扰动、运动、离焦和系统噪音,它们会造成图像的模糊和变形。图像复原的目的就是对退化图像进行处理,使其复原成没有退化前的理想图像。按照傅里叶光学的观点,光学成像系统是一个低通滤波器,由于受到光学衍射的影响,其传递函数在由衍射极限分辨率所决定的某个截止频率以上值均为零。显然,普通的图像复原技术如去卷积技术等只能将物体的频率复原到衍射极

文本分类中的特征提取和分类算法综述

文本分类中的特征提取和分类算法综述 摘要:文本分类是信息检索和过滤过程中的一项关键技术,其任务是对未知类别的文档进行自动处理,判别它们所属于的预定义类别集合中的类别。本文主要对文本分类中所涉及的特征选择和分类算法进行了论述,并通过实验的方法进行了深入的研究。 采用kNN和Naive Bayes分类算法对已有的经典征选择方法的性能作了测试,并将分类结果进行对比,使用查全率、查准率、F1值等多项评估指标对实验结果进行综合性评价分析.最终,揭示特征选择方法的选择对分类速度及分类精度的影响。 关键字:文本分类特征选择分类算法 A Review For Feature Selection And Classification Algorithm In Text Categorization Abstract:Text categorization is a key technology in the process of information retrieval and filtering,whose task is to process automatically the unknown categories of documents and distinguish the labels they belong to in the set of predefined categories. This paper mainly discuss the feature selection and classification algorithm in text categorization, and make deep research via experiment. kNN and Native Bayes classification algorithm have been applied to test the performance of classical feature detection methods, and the classification results based on classical feature detection methods have been made a comparison. The results have been made a comprehensive evaluation analysis by assessment indicators, such as precision, recall, F1. In the end, the influence feature selection methods have made on classification speed and accuracy have been revealed. Keywords:Text categorization Feature selection Classification algorithm

超分辨率算法综述

图像超分辨率算法综述 摘要:介绍了图像超分辨率算法的概念和来源,通过回顾插值、重建和学习这3个层面的超分辨率算法,对图像超分辨率的方法进行了分类对比,着重讨论了各算法在还原质量、通用能力等方面所存在的问题,并对未来超分辨率技术的发展作了一些展望。 关键词:图像超分辨率;插值;重建;学习; Abstract:This paper introduced the conception and origin of image super resolu- tion technology. By reviewing these three kinds of methods(interpolation,reconstruct, study), it contrasted and classified the methods of image super-resolution,and at last, some perspectives of super-resolution are given. Key words: image super-resolution;interpolation;reconstruct;study;

1 引言 1.1 超分辨率的概念 图像超分辨率率(super resolution,SR)是指由一幅低分辨率图像(low resolution,LR)或图像序列恢复出高分辨率图像(high resolution, HR)。HR意味着图像具有高像素密度,可以提供更多的细节,这些细节往往在应用中起到关键作用。要获得高分辨率图像,最直接的办法是采用高分辨率图像传感器,但由于传感器和光学器件制造工艺和成本的限制[1],在很多场合和大规模部署中很难实现。因此,利用现有的设备,通过超分辨率技术获取HR图像(参见图1)具有重要的现实意义。 图1 图像超分辨率示意图 图像超分辨率技术分为超分辨率复原和超分辨率重建,许多文献中没有严格地区分这两个概念,甚至有许多文献中把超分辨率图像重建和超分辨率图像复原的概念等同起来,严格意义上讲二者是有本质区别的,超分辨率图像重建和超分辨率图像复原有一个共同点,就是把在获取图像时丢失或降低的高频信息恢复出来。然而它们丢失高频信息的原因不同,超分辨率复原在光学中是恢复出超过衍射级截止频率以外的信息,而超分辨率重建方法是在工程应用中试图恢复由混叠产生的高频成分。几何处理、图像增强、图像复原都是从图像到图像的处理,即输入的原始数据是图像,处理后输出的也是图像,而重建处理则是从数据到图像的处理。也就是说输入的是某种数据,而处理结果得到的是图像。但两者的目的是一致的,都是由低分辨率图像经过处理得到高分辨率图像。另外有些文献中对超分辨率的概念下定义的范围比较窄,只是指基于同一场景的图像序列和视频序列的超分辨处理,实际上,多幅图像的超分辨率大多数都是以单幅图像的超分辨率为基础的。在图像获取过程中有很多因素会导致图像质量下降,如传感器的形

关于图像超分辨率重构的现状研究

关于图像超分辨率重构的现状研究 摘要:图像超分辨率的重构技术是近20年来兴起的一门新的数字图像处理技术。随着计算机硬件技术和软件设计技术的不断发展,各种图像超分辨率重构算法被提出。综述超分辨率重构的相关研究,指出图像超分辨率重构技术近几年来的一些研究成果。 关键字:图像超分辨率;图像超分辨率重构;迭代法投影法 Abstract:Image super-resolution reconstruction technology is nearly 20 years the rise of a new digital image processing technology. With the continuous development of computer hardware and software design technology, all kinds of image super-resolution reconstruction algorithm was proposed. Of related studies on super-resolution reconstruction, and points out that the technology of image super-resolution reconstruction in recent years, some of the research. Keywords:image super-resolution; image super-resolution reconstruction; iterative projection method 1引言 超分辨率重构算法始于20世纪80年代,其目的在于恢复一些已丢失的频率分量。在成像过程中,由于受成像系统的物理性质和天气条件的影响,图像中存在着光学和运动模糊、采样不足和附加噪声等退化现象,图像空间分辨率较低。而在实际应用中,需要高分辨率的图像,如在遥感检测、军事侦查、交通及安全监控、医学诊断和模式识别等方面。在现有的传感器不作改变的情况下,人们希望利用信号处理的方法,通过一系列低分辨率图像来重构高分辨率图像。这种从同一场景的低分辨率图像序列中,通过信息融合来提高空间分辨率的方法通常被称为超分辨率重构。

智能优化算法综述

智能优化算法的统一框架 指导老师:叶晓东教授 姓名:李进阳 学号:2 班级:电磁场与微波技术5班 2011年6月20日

目录 1 概述 (3) 2群体智能优化算法.................................. 错误!未定义书签。 人工鱼群算法 (4) 蚁群算法 (5) 混合蛙跳算法 (9) 3神经网络算法 (10) 神经网络知识点概述 (10) 神经网络在计算机中的应用 (11) 4模拟退火算法 (15) 5遗传算法.......................................... 错误!未定义书签。 遗传算法知识简介 (17) 遗传算法现状 (18) 遗传算法定义 (19) 遗传算法特点和应用 (20) 遗传算法的一般算法 (21) 遗传算法的基本框架 (26) 6总结 (28) 7感谢 (29)

1概述 近年来,随着人工智能应用领域的不断拓广,传统的基于符号处理机制的人工智能方法在知识表示、处理模式信息及解决组合爆炸等方面所碰到的问题已变得越来越突出,这些困难甚至使某些学者对强人工智能提出了强烈批判,对人工智能的可能性提出了质疑。众所周知,在人工智能领域中,有不少问题需要在复杂而庞大的搜索空间中寻找最优解或准优解。像货朗担问题和规划问题等组合优化问题就是典型的例子。在求解此类问题时,若不能利用问题的固有知识来缩小搜索空间则会产生搜索的组合爆炸。因此,研究能在搜索过程中自动获得和积累有关搜索空间的知识,并能自适应地控制搜索过程,从而得到最优解或准有解的通用搜索算法一直是令人瞩目的课题。智能优化算法就是在这种背景下产生并经实践证明特别有效的算法。 2群体智能优化算法 自然界中群体生活的昆虫、动物,大都表现出惊人的完成复杂行为的能力。人们从中得到启发,参考群体生活的昆虫、动物的社会行为,提出了模拟生物系统中群体生活习性的群体智能优化算法。在群体智能优化算法中每一个个体都是具有经验和智慧的智能体 (Agent) ,个体之间存在互相作用机制,通过相互作用形成强大的群体智慧来解决复杂的问题。自 20世纪 90年代模拟蚂蚁行为的蚁群算法(ACO)提出以来,又产生了模拟鸟类行为的微粒群算法 ( PSO)、模拟鱼类生存习性的人工鱼群算法、模拟青蛙觅食的混合蛙跳算法 ( SFLA)等。这些群体智能优化算法的出现,使原来一些复杂的、难于用常规的优化算法进行处理的问题可以得到解决,大大增强了人们解决和处理优化问题的能力,这些算法不断地用于解决工程实际中的问题,使得人们投入更大的精力对其理论和实际应用进行研究。群体智能优化算法本质上是一种概率搜索,它不需要问题的梯度信息具有以下不同于传统优化算法的特点: ①群体中相互作用的个体是分布式的,不存在直接的中心控制,不会因为个别个体出现故障而影响群体对问题的求解,具有较强的鲁棒性; ②每个个体只能感知局部信息,个体的能力或遵循规则非常简单,所以群体智能的实现简单、方便; ③系统用于通信的开销较少,易于扩充; ④自

图像超分辨率重建

收稿日期:2008唱08唱21;修回日期:2008唱10唱28 作者简介:王培东(1953唱),男,黑龙江哈尔滨人,教授,硕导,CCF会员,主要研究方向为计算机控制、计算机网络、嵌入式应用技术;吴显伟(1982唱),男(回族),河南南阳人,硕士,主要研究方向为计算机控制技术(wu_xianwei@126.com). 一种自适应的嵌入式协议栈缓冲区管理机制 王培东,吴显伟 (哈尔滨理工大学计算机科学与技术学院,哈尔滨150080) 摘 要:为避免创建缓冲区过程中必须指定大小和多次释放而导致可能的内存泄露和代码崩溃的弊端,提出一种自适应的嵌入式协议栈的缓冲区管理机制AutoBuf。它是基于抽象缓冲区接口而设计的,具有自适应性,支持动态内存的自动分配与回收,同时实现了嵌入式TCP/IP协议栈各层之间的零拷贝通信。在基于研究平台S3C44B0X的Webserver网络数据监控系统上的测试结果表明,该缓冲区的设计满足嵌入式系统网络通信的应用需求,是一种高效、可靠的缓冲区管理机制。 关键词:嵌入式协议栈;抽象缓冲区;零拷贝;内存分配 中图分类号:TP316 文献标志码:A 文章编号:1001唱3695(2009)06唱2254唱03doi:10.3969/j.issn.1001唱3695.2009.06.077 Designandimplementationofadaptivebufferforembeddedprotocolstack WANGPei唱dong,WUXian唱wei (CollegeofComputerScience&Technology,HarbinUniversityofScience&Technology,Harbin150080,China) Abstract:Toavoidtraditionalmethodofcreatingbuffer,whichmusthavethesizeofbufferandfreememoryformanytimes,whichwillresultinmemoryleaksandcodescrash.ThispaperproposedaflexiblebuffermanagementmechanismAutoBufforembeddednetworkprotocolstack.Itwasadaptiveandscalableandbasedonanabstractbufferinterface,supporteddynamicme唱moryallocationandbackup.ByusingtheAutoBufbuffermanagementmechanismwithdatazerocopytechnology,itimplementedtotransferdatathroughtheembeddednetworkprotocolstack.ThemanagementmechanismhadbeenappliedtotheWebserversystembaseonS3C44b0Xplatformsuccessfully.Theresultsinrealnetworkconditionshowthatthesystemprovidesagoodper唱formanceandmeetsthenecessaryofembeddednetworksystem.Keywords:embeddedstack;abstractbuffer;zero唱copy;memoryallocation 随着网络技术的快速发展,主机间的通信速率已经提高到了千兆数量级,同时多媒体应用还要求网络协议支持实时业务。嵌入式设备网络化已经深入到日常生活中,而将嵌入式设备接入到互联网需要网络协议栈的支持。通过分析Linux系统中TCP/IP协议栈的实现过程,可以看出在协议栈中要有大量数据不断输入输出,而管理这些即时数据的关键是协议栈中的缓冲区管理机制,因此对嵌入式协议栈的缓冲区管理将直接影响到数据的传输速率和安全。通用以太网的缓冲区管理机制,例如4.4BSDmbuf [1] 和现行Linux系统中的sk_buf [2] 多是在大内存、 高处理速率的基础上设计的,非常庞大复杂。由于嵌入式设备的硬件资源有限,特别是可用物理内存的限制,通用的协议栈必然不适用于嵌入式设备,在应用时要对标准的TCP/IP协议进行裁剪 [3] 和重新设计缓冲区管理机制。 1 缓冲区管理机制的性能需求分析 缓冲区管理 [4] 是对内存提供一种统一的管理手段,通过该 手段能够对可用内存提供分配、回收、数据操作等行为。内存的分配操作是根据一定的内存分配策略从缓冲区中获得相应大小的内存空间;缓冲区的数据操作主要是向缓冲区写数据,从缓冲区读数据,在缓冲区中删除数据,对空闲的内存块进行合并等行为;内存的回收就是将已空闲的内存重新变为可用内存,以供存 储其他新的数据。 为了满足长度不一的即时数据的需求,缓冲区对内存的操作主要集中在不断地分配、回收、合并空闲的内存块等操作。因为网络中的数据包小到几个字节大到几千个字节,不同长度的数据对内存的需求必然不同。现存嵌入式设备中的内存多是以物理内存,即实模式形式存在的,没有虚拟内存的形式,对内存的操作实际是操作真实的物理内存,所以对内存操作要特别谨慎。在传统使用动态分配的缓冲区(通过调用malloc()/free())在函数之间传递数据。尽管该方法提供了灵活性,但它也带来了一些性能影响。首先考虑对缓冲区的管理(分配和释放内存块)。如果分配和释放不能在相同的代码位置进行,那么必须确保在某个内存块不再需要时,释放一次(且仅释放一次)该内存块是很重要的,否则就会导致内存泄露。其次是必须确定缓冲区的大小才能分配该内存块。然而,确定数据大小并非那么容易,传统做法是采用最大的数据尺寸的保守估计。而采用保守估计预分配的内存大小总是远超过实际需要的大小,而且没有一定的范围标准,这样难免会导致资源的严重浪费。 随着数据在协议栈中的不断流动,内存块的多次释放和多次分配是难以避免的,而保守估计对于有限的资源来说又是一种浪费的策略。因此为了能有效地利用资源,设计一种可自控的、不用预判断大小的数据缓冲区接口就势在必行。 第26卷第6期2009年6月 计算机应用研究 ApplicationResearchofComputers Vol.26No.6Jun.2009

能够充分提高照片像素的方法!

能够充分提高照片像素的方法! 初玩摄影的朋友,是否为照片的像素不高而烦恼?下面分享能够提高照片素质12招,希望可以给大家带来帮助! 1. 尽量使用三脚架 很多情况下,照片图像模糊、不清晰的原因,是拍摄者在按动快门时产生“手振”或相机反光板抬升产生“机振”所造成的。如果使用了三脚架,无论快门速度设定到如何的“慢”,甚至长时间的曝光,即可防止图像由于“抖动”而产生的图像模糊。但要注意,使用三脚架时,要尽可能地使用快门线,忽视这一点,仍有可能在手指接触快门时产生的震动而影响清晰度。 2. 尽可能地使用高速快门 在手持照相机拍照的情况下,尽可能采用高速快门来拍摄。没有经验的拍摄者,快门速度设定在1/30s以下时,照片拍虚的概率较大。即使专业摄影工作者,也不能保证在低速快门拍摄时有百分之百的把握。提高快门速度,会相应提高照片清晰度的概率。当然,在手持照相机提高快门速度的情况下,势必开大光圈,因而会失去“大景深”,但为保证照片的清晰度,放弃景深是不得已的办法。 3. 尽可能使用“最佳光圈” 任何镜头都存在不同程度的成像误差,这些成像误差将使镜头的成像质量受到不同程度的影响。由于镜头球面的曲率不同,光线经过透镜中心和边缘时因折射率不同而不能聚焦于同一焦点,从而导致清晰度下降。如使用镜头的最大光圈拍摄,将导致该镜头像差缺陷的最大暴露,导致图像清晰度下降,而使用镜头的最小光圈拍摄,会产生光的衍射,也会导致图像清晰度下降。为改善像差而引起的清晰度下降问题,通常采用缩小光圈的办法来提高成像的质量。一般来说镜头的最佳光圈为该镜头最大光圈缩小2~3档左右,拍摄者可对某个镜头的最佳光圈进行比较。 4. 尽可能采用手动对焦 目前大多数相机具有自动对焦功能。然而,在景深特别小的情况下,自动对焦往往会聚焦不准确,特别是在向主体近距离对焦,使用长焦距镜头,采用大光圈拍摄人像特写的情况下,要特别小心。如果此时采用自动对焦,“靶子”非要对在人物的眼睛上,如果没有十分的把握,宁可放弃自动对焦,而采用手动对焦。人们不希望照片上人物的耳朵或鼻子是清晰的,而传神的眼睛是模糊的。 5. 尽量使用遮光罩 遮光罩的使用,很多人并不在意。在用正面光、前侧光或侧光时,遮光罩的作用并不明显。但是在逆光或侧逆光拍摄时,必须使用遮光罩,有时即便使用了遮光罩,阳光仍会直射到镜头上,造成画面“冲光”,产生雾翳,影响被摄体的色彩饱和度和清晰度。这时,应调整镜头角度,避开直射到镜头上的光线。此外,遮光罩还有助于防止镜头镜面损伤,同时避免手指接触到镜面。 6. 合理利用景深 景深的大小是根据拍摄者拍摄的目的来决定。如果是拍摄风光摄影,景深就要求大,目的是为让照片上景物的清晰范围从近至远都表现得很清楚。如果是拍摄特写,景深就要求小,目的是让照片上主体的背景(也可能是前景)虚化(模糊),突出被摄主体。用小景深来表现风光题材,或用大景深去表现被摄体特写,从摄影表现手法上来说适得其反。如何合理运用景深呢?请记住:采用小光圈、短焦距镜头、远距离对焦拍摄三种方法,景深就大。采用大光圈、长焦距镜头、近距离对焦拍摄三种方法,景深就小。采用其中一种或两种拍摄方法也行,但效果没有三种方法合起来使用作用更明显。 7. 尽可能选用低值感光度 要获得影像的高清晰度,让照片看起来具有丰富的质感,除选择使用高像素的数码照相

快速流分类算法研究综述

快速流分类算法研究综述 李振强 (北京邮电大学信息网络中心,北京 100876) 摘要 本文对流分类算法进行了综述,包括流分类的定义,对流分类算法的要求,以及各种流分类算法的分析比较。文章的最后指出了在流分类方面还没有得到很好解决的问题,作为进一步研究的方向。 关键词 流分类;服务质量;IP 背景 当前的IP网络主要以先到先服务的方式提供尽力而为的服务。随着Internet的发展和各种新业务的出现,尽力而为的服务已经不能满足人们对Internet的要求,IP网络必须提供增强的服务,比如:SLA(Service Level Agreement)服务,VPN(Virtual Private Network)服务,各种不同级别的QoS (Quality of Service)服务,分布式防火墙,IP安全网关,流量计费等。所有这些增强服务的提供都依赖于流分类,即根据包头(packet header)中的一个或几个域(field)决定该包隶属的流(flow)。典型的,包头中可以用来分类的域包括:源IP地址(Source IP Address)、目的IP地址(Destination IP Address)、协议类型(Protocol Type)、源端口(Source Port)和目的端口(Destination Port)等。 流分类算法描述 首先定义两个名词:规则(rule)和分类器(classifier)。用来对IP包进行分类的由包头中若干域组成的集合称之为规则,而若干规则的集合就是分类器。构成规则的域(我们称之为组件component)的值可以是某个范围,例如目的端口大于1023。流分类就是要确定和每个包最匹配的规则。表1是由6条规则组成的一个分类器。我们说这是一个5域分类器,因为每条规则由5个组件构成。我们假定分类器中的规则是有优先级的,越靠前的规则优先级越高,即规则1的优先级最高,规则6的最低。

智能算法综述

摘要:随着计算机技术的飞速发展,智能计算方法的应用领域也越来越广泛,本文介绍了当前存在的一些智能计算方法,阐述了其工作原理和特点,同时对智能计算方法的发展进行了展望。关键词:人工神经网络遗传算法模拟退火算法群集智能蚁群算法粒子群算1什么是智能算法智能计算也有人称之为“软计算”,是们受自然(生物界)规律的启迪,根据其原理,模仿求解问题的算法。从自然界得到启迪,模仿其结构进行发明创造,这就是仿生学。这是我们向自然界学习的一个方面。另一方面,我们还可以利用仿生原理进行设计(包括设计算法),这就是智能计算的思想。这方面的内容很多,如人工神经网络技术、遗传算法、模拟退火算法、模拟退火技术和群集智能技术等。 2人工神经网络算法“人工神经网络”(ARTIFICIALNEURALNETWORK,简称ANN)是在对人脑组织结构和运行机制的认识理解基础之上模拟其结构和智能行为的一种工程系统。早在本世纪40年代初期,心理学家McCulloch、数学家Pitts就提出了人工神经网络的第一个数学模型,从此开创了神经科学理论的研究时代。其后,FRosenblatt、Widrow和J.J.Hopfield等学者又先后提出了感知模型,使得人工神经网络技术得以蓬勃发展。神经系统的基本构造是神经元(神经细胞),它是处理人体内各部分之间相互信息传递的基本单元。据神经生物学家研究的结果表明,人的一个大脑一般有1010~1011个神经元。每个神经元都由一个细胞体,一个连接其他神经元的轴突和一些向外伸出的其它较短分支——树突组成。轴突的功能是将本神经元的输出信号(兴奋)传递给别的神经元。其末端的许多神经末梢使得兴奋可以同时传送给多个神经元。树突的功能是接受来自其它神经元的兴奋。神经元细胞体将接受到的所有信号进行简单处理(如:加权求和,即对所有的输入信号都加以考虑且对每个信号的重视程度——体现在权值上——有所不同)后由轴突输出。神经元的树突与另外的神经元的神经末梢相连的部分称为突触。 2.1人工神经网络的特点人工神经网络是由大量的神经元广泛互连而成的系统,它的这一结构特点决定着人工神经网络具有高速信息处理的能力。人脑的每个神经元大约有103~104个树突及相应的突触,一个人的大脑总计约形成1014~1015个突触。用神经网络的术语来说,即是人脑具有1014~1015个互相连接的存储潜力。虽然每个神经元的运算功能十分简单,且信号传输速率也较低(大约100次/秒),但由于各神经元之间的极度并行互连功能,最终使得一个普通人的大脑在约1秒内就能完成现行计算机至少需要数10亿次处理步骤才能完成的任务。人工神经网络的知识存储容量很大。在神经网络中,知识与信息的存储表现为神经元之间分布式的物理联系。它分散地表示和存储于整个网络内的各神经元及其连线上。每个神经元及其连线只表示一部分信息,而不是一个完整具体概念。只有通过各神经元的分布式综合效果才能表达出特定的概念和知识。由于人工神经网络中神经元个数众多以及整个网络存储信息容量的巨大,使得它具有很强的不确定性信息处理能力。即使输入信息不完全、不准确或模糊不清,神经网络仍然能够联想思维存在于记忆中的事物的完整图象。只要输入的模式接近于训练样本,系统就能给出正确的推理结论。 [!--empirenews.page--]正是因为人工神经网络的结构特点和其信息存储的分布式特点,使得它相对于其它的判断识别系统,如:专家系统等,具有另一个显著的优点:健壮性。生物神经网络不会因为个别神经元的损失而失去对原有模式的记忆。最有力的证明是,当一个人的大脑因意外事故受轻微损伤之后,并不会失去原有事物的全部记忆。人工神经网络也有类似的情况。因某些原因,无论是网络的硬件实现还是软件实现中的某个或某些神经元失效,整个网络仍然能继续工作。人工神经网络是一种非线性的处理单元。只有当神经元对所有的输入信号的综合处理结果超过某一门限值后才输出一个信号。因此神经网络是一种具有高度非线性的超大规模连续时间动力学系统。它突破了传统的以线性处理为基础的数字电子计算机的局限,标志着人们智能信息处理能力和模拟人脑智能行为能力的一大飞跃。 2.2几种典型神经网络简介 2.2.1多层感知网络(误差逆传播神经网络) 在1986年以Rumelhart和McCelland为首的科学家出版的《ParallelDistributedProcessing》一书中,完整地提出了误差逆传播学习算法,并被广泛